Dessin au trait, segmentation, transfert de style et montée en gamme avec Stable Diffusion !

Cette interface graphique permet de générer des images à partir de simples coups de pinceau, ou courbes de Bézier, en temps réel. Les fonctions ont été conçues principalement pour être utilisées en architecture et pour dessiner dans les premières étapes d'un projet. Il utilise Stable Diffusion et ControlNet comme base d'IA pour le processus génératif. La prise en charge de l'adaptateur IP est incluse, ainsi qu'une large bibliothèque de styles prédéfinis ! Chaque image de référence permet de transférer un style spécifique à votre travail au trait. Une fonction upscale a également été ajoutée, pour exporter les résultats en haute résolution (basée sur la tuile ControlNet).

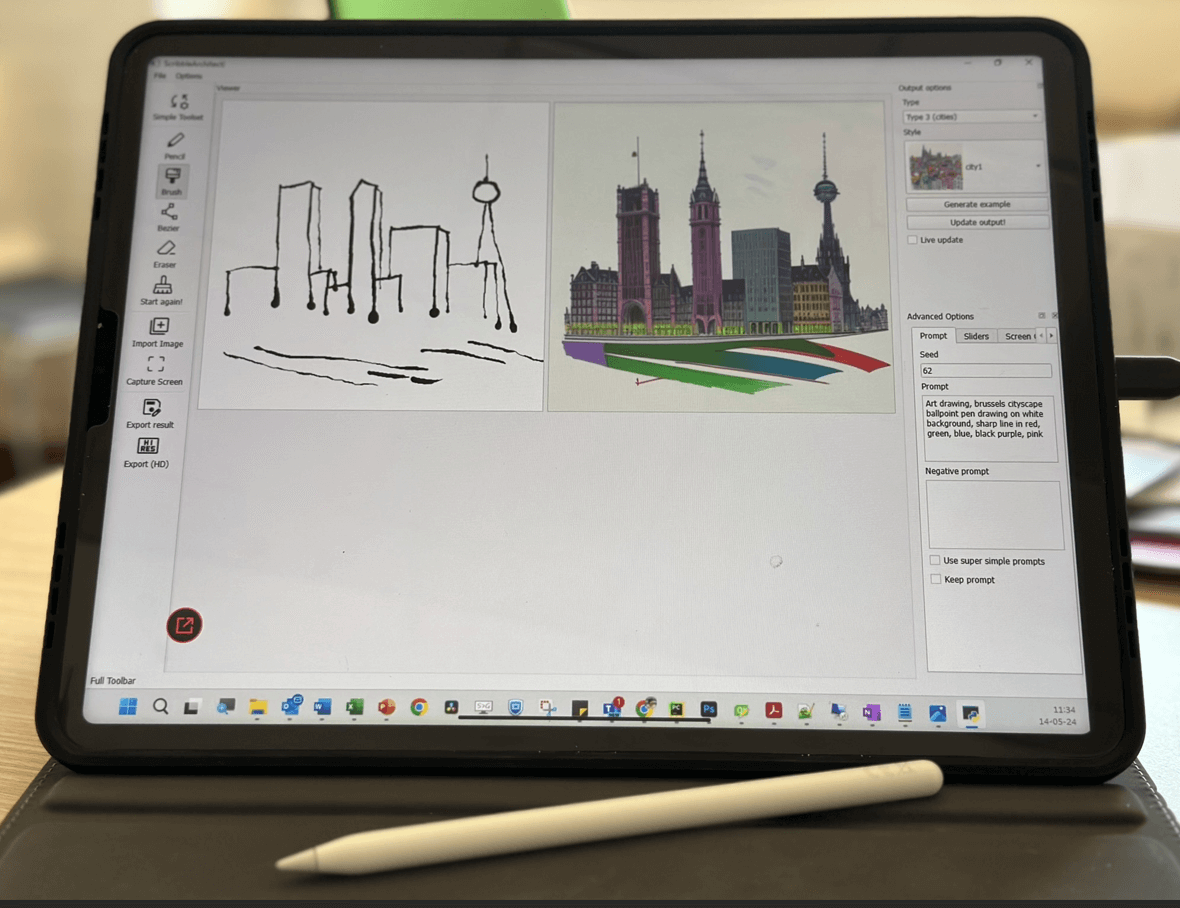

exemple montrant un dessin en direct

exemple montrant le changement de style (intérieur)

exemple montrant le changement de style (extérieur)

De nombreuses nouvelles fonctions ont été récemment ajoutées :

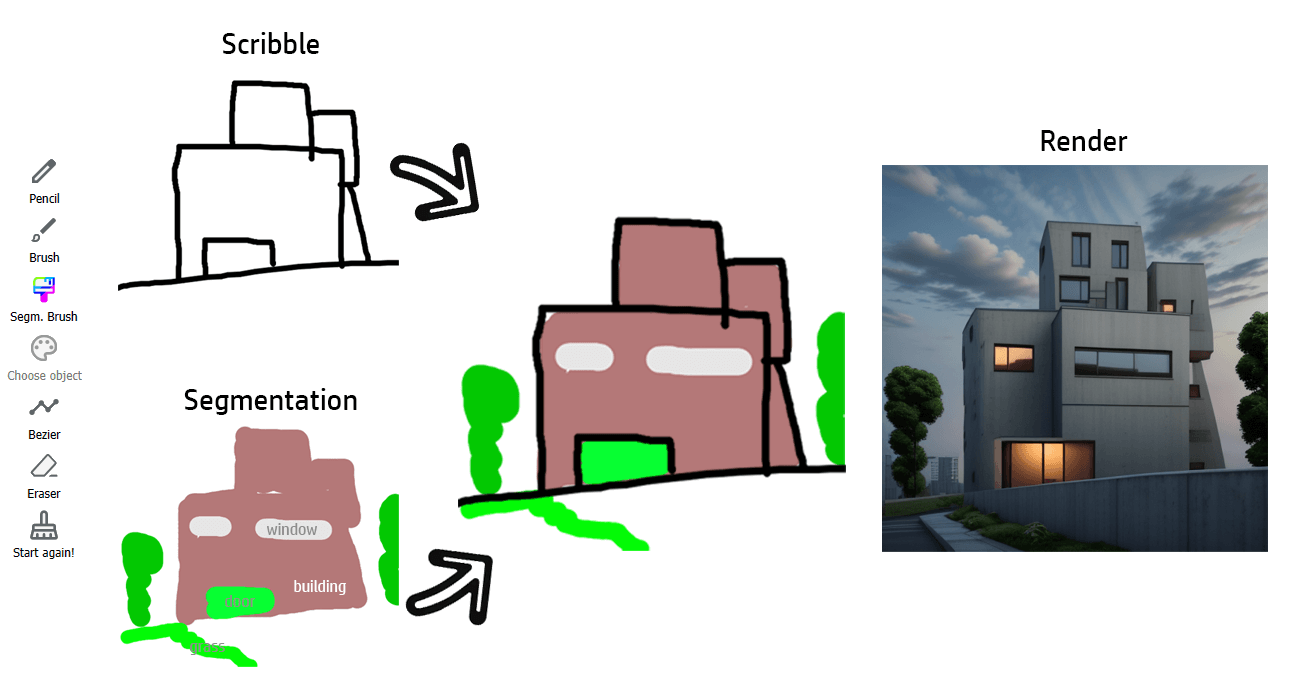

nous avons récemment incorporé un nouveau système de calques, dans lequel l'utilisateur peut tracer soit des lignes noires (pour alimenter ControlNet Scribble), soit des coups de pinceau colorés (pour ControlNet Segmentation). Voir « Utilisation de l'application ». REMARQUE : vous pouvez toujours trouver l'ancienne version dans la section « versions ».

Choisissez un « type » de conception architecturale (enduit extérieur, élévation de façade, enduit intérieur, ...) et un style. Sur la gauche, vous trouverez la zone de dessin. Vous pouvez ajouter soit des lignes noires pour définir les lignes importantes de votre dessin, soit des zones colorées (une carte sémantique) pour définir où placer des objets spécifiques (un arbre, une fenêtre, etc.). Un code couleur spécifique est associé à chaque type d'objet. Vous n'avez pas à vous soucier du choix de la bonne couleur, puisque l'interface graphique vous permet de sélectionner directement l'objet à dessiner. Le processus de dessin lui-même est tout à fait standard. Choisissez votre outil et dessinez ! (ou supprimer). Vous verrez l'image proposée s'adapter en direct (une case à cocher permet de désactiver l'inférence en direct).

exemple montrant l'utilisation d'une brosse de segmentation (intérieur)

Si vous manquez d'inspiration ou à des fins de test, un exemple de dessin griffonné peut être généré automatiquement.

Les images peuvent également être importées pour générer automatiquement des gribouillages et/ou une segmentation.

Nous avons également ajouté une fonction de capture d'écran. il crée une zone de capture (bordure bleue) qui peut être déplacée et générera des gribouillages basés sur la zone capturée. Une fois satisfait de la capture, cliquez à nouveau sur l'outil pour le désactiver. Il permet de travailler avec des outils puissants en entrée (Adobe Illustrator, Inkscape, ...).

Fonction de capture d'écran avec Inkscape en entrée

Le rendu peut être exporté en haute résolution, grâce à un upscaler ControlNet. Plus d'options seront bientôt intégrées !

Upscaling (rendu extérieur artistique)

Upscaling (rendu intérieur réaliste)

La prise en charge des supports de dessin a récemment été incluse. La pression du stylo doit être détectée. Testé sur Ipad Pro + EasyCanvas.

Le dessin en direct nécessite un GPU puissant, je conseillerais de réduire la taille de l'image (dans main.py) si elle est trop lente ! La mise à niveau de l'image est vraiment gourmande en GPU...

Par défaut, l'application utilise Dreamshaper (https://huggingface.co/Lykon/dreamshaper-8). Des modèles personnalisés peuvent être ajoutés dans le dossier dédié (« custom_models »). Tout point de contrôle SD1.5 devrait fonctionner.

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

(voir https://pytorch.org/get-started/locally/)

pip install git+https://github.com/sberbank-ai/Real-ESRGAN.git

https://huggingface.co/lllyasviel/sd-controlnet-seg https://huggingface.co/lllyasviel/sd-controlnet-scribble