Foundationa LLM : La plateforme pour déployer, faire évoluer, sécuriser et gouverner l'IA générative dans les entreprises

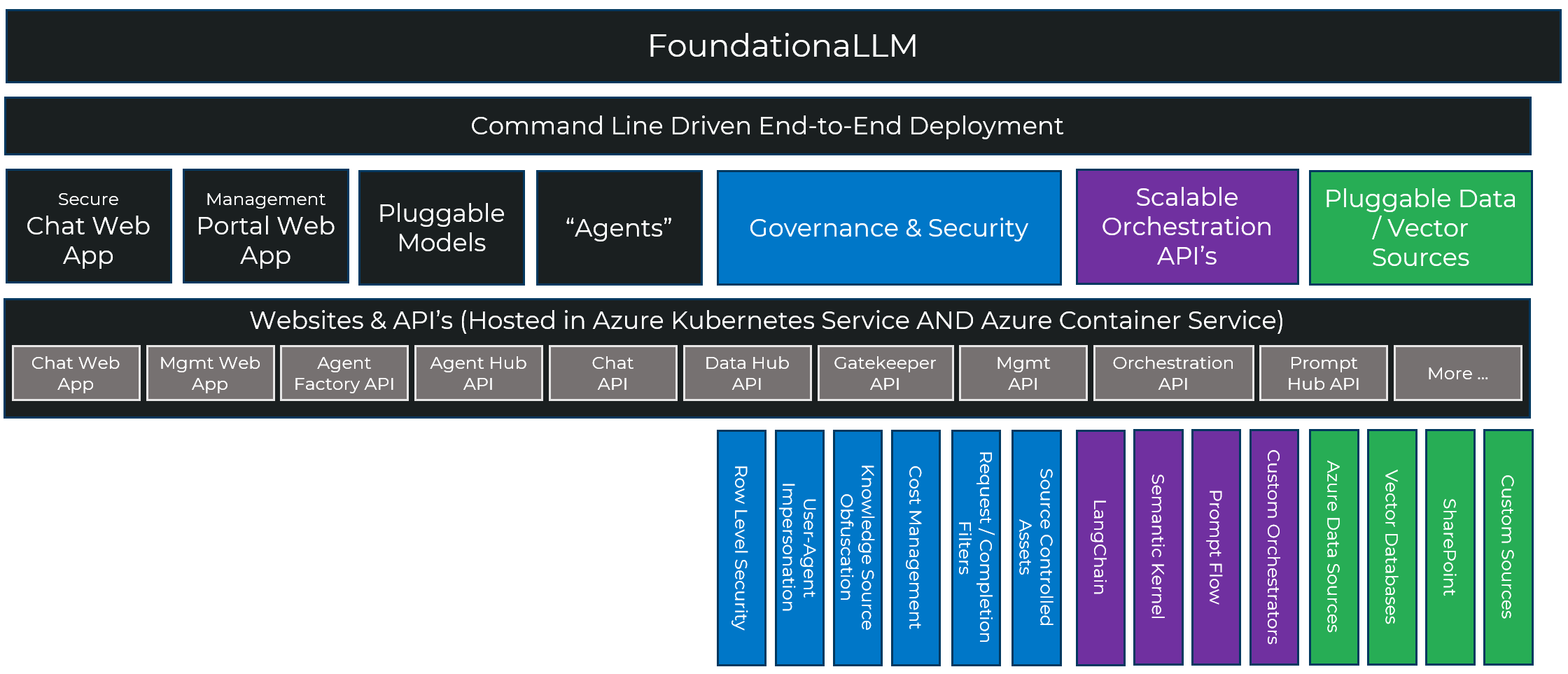

Foundationa LLM fournit la plate-forme pour déployer, faire évoluer, sécuriser et gouverner l'IA générative dans l'entreprise. Avec Foundationa LLM, vous pouvez :

- Créez des agents d'IA basés sur les données de votre entreprise, qu'il s'agisse de données textuelles, semi-structurées ou structurées.

- Mettez les agents IA à la disposition de vos utilisateurs via une interface de chat de marque ou intégrez l'API REST à l'agent IA dans votre application pour une expérience copilote ou intégrez l'API de l'agent dans un processus automatisé de machine à machine.

- Expérimentez des agents de création qui peuvent utiliser une variété de grands modèles de langage, notamment OpenAI GPT-4, Mistral et Llama 2, ou tout modèle extrait du catalogue de modèles Hugging Face qui fournit un point de terminaison de complétion REST.

- Gérez, configurez et sécurisez de manière centralisée vos agents IA ET leurs actifs sous-jacents, notamment les invites, les sources de données, les pipelines de données de vectorisation, les bases de données vectorielles et les grands modèles de langage à l'aide du portail de gestion.

- Permettez à tous les membres de votre entreprise de créer leurs propres agents IA. Vos utilisateurs non-développeurs peuvent créer et déployer leurs propres agents en libre-service à partir du portail de gestion, mais nous ne gênons pas vos développeurs d'IA avancés qui peuvent déployer leurs propres orchestrations construites dans LangChain, Semantic Kernel, Prompt Flow ou toute orchestration qui expose un point de terminaison de complétion.

- Déployez et gérez des pipelines de données de vectorisation évolutives qui peuvent ingérer des millions de documents pour fournir des connaissances à votre modèle.

- Offrez à vos utilisateurs autant d’agents IA axés sur les tâches que vous le souhaitez.

- Contrôlez l'accès aux agents IA et aux ressources auxquelles ils accèdent à l'aide de contrôles d'accès basés sur les rôles (RBAC).

- Exploitez les capacités en évolution rapide d’Azure AI et d’Azure OpenAI à partir d’une pile intégrée.

Note

Foundationa LLM n’est pas un grand modèle de langage. Il vous permet d'utiliser les grands modèles de langage de votre choix (par exemple, OpenAI GPT-4, Mistral, LLama 2, etc.)

Foundationa LLM déploie une plateforme copilote sécurisée, complète et hautement configurable dans votre environnement cloud Azure :

- Simplifie l'intégration avec les sources de données d'entreprise utilisées par l'agent pour l'apprentissage en contexte (par exemple, en activant les modèles RAG, CoT, ReAct et monologues internes).

- Fournit une défense en profondeur avec des contrôles de sécurité précis sur les données utilisées par l'agent et des filtres pré/post-achèvement qui protègent contre les attaques.

- Solution renforcée attaquée par une équipe rouge LLM depuis sa création.

- La charge de la solution évolutive est répartie sur plusieurs points de terminaison LLM.

- Extensible à de nouvelles sources de données, de nouveaux orchestrateurs LLM et LLM.

Pourquoi Foundationa LLM est-il nécessaire ?

En termes simples, nous avons vu beaucoup de gens réinventer la roue juste pour obtenir un copilote ou un agent d'IA personnalisé qui était ancré et basait ses réponses sur leurs propres données, par opposition à la connaissance paramétrique entraînée du modèle. La plupart des solutions que nous avons vues constituaient d'excellentes démonstrations, mais étaient en fait des jouets enveloppant des appels vers des points de terminaison OpenAI - elles n'étaient pas quelque chose de prévu ou prêt à être mis en production à l'échelle de l'entreprise. Nous avons construit Foundationa LLM pour offrir un parcours continu, rapide à démarrer afin que les gens puissent expérimenter rapidement les LLM sans tomber ensuite dans une falaise avec une solution qui ne serait pas sécurisée, sans licence, rigide et pas assez complète pour passer du prototype à une solution de production sans avoir à tout recommencer.

Les principaux problèmes liés à la fourniture de copilotes d'entreprise ou d'agents IA sont :

- Les copilotes ou agents IA de niveau entreprise sont complexes et comportent de nombreuses pièces mobiles (sans parler de l'infrastructure).

- L’industrie manque de compétences lorsqu’il s’agit de remplir les rôles nécessaires pour fournir ces solutions copilotes complexes.

- Les principaux risques liés à l’IA (inexactitude, cybersécurité, conformité, explicabilité, confidentialité) ne sont pas atténués par des outils individuels.

- La livraison d’une solution de copilote ou d’agent IA prend du temps, est coûteuse et frustrante lorsqu’on part de zéro.

L'idée fausse contre la réalité

Idée fausse

Il existe une idée fausse selon laquelle la création d'applications LLM et d'agents IA est une question d'ingénierie rapide, c'est aussi simple que :

Cela peut être vrai pour les démos et les scénarios de jouets, mais pour les agents IA dans l'entreprise, il y a beaucoup plus d'exigences telles que :

- mettre à l'échelle et charger par lots des milliers, voire des millions de documents en tant que connaissances pour le modèle ? tirer parti d'autres LLM (Llama 2, Mistral) aux côtés des modèles ChatGPT ?

- garder les sources de connaissances sensibles privées pour les utilisateurs autorisés ?

- empêcher que les données sensibles (PII, secrets commerciaux) soient envoyées au LLM ?

- parvenez-vous à avoir plusieurs agents IA ?

- régir l’utilisation des jetons et gérer les rétrofacturations pour les applications ?

Réalité

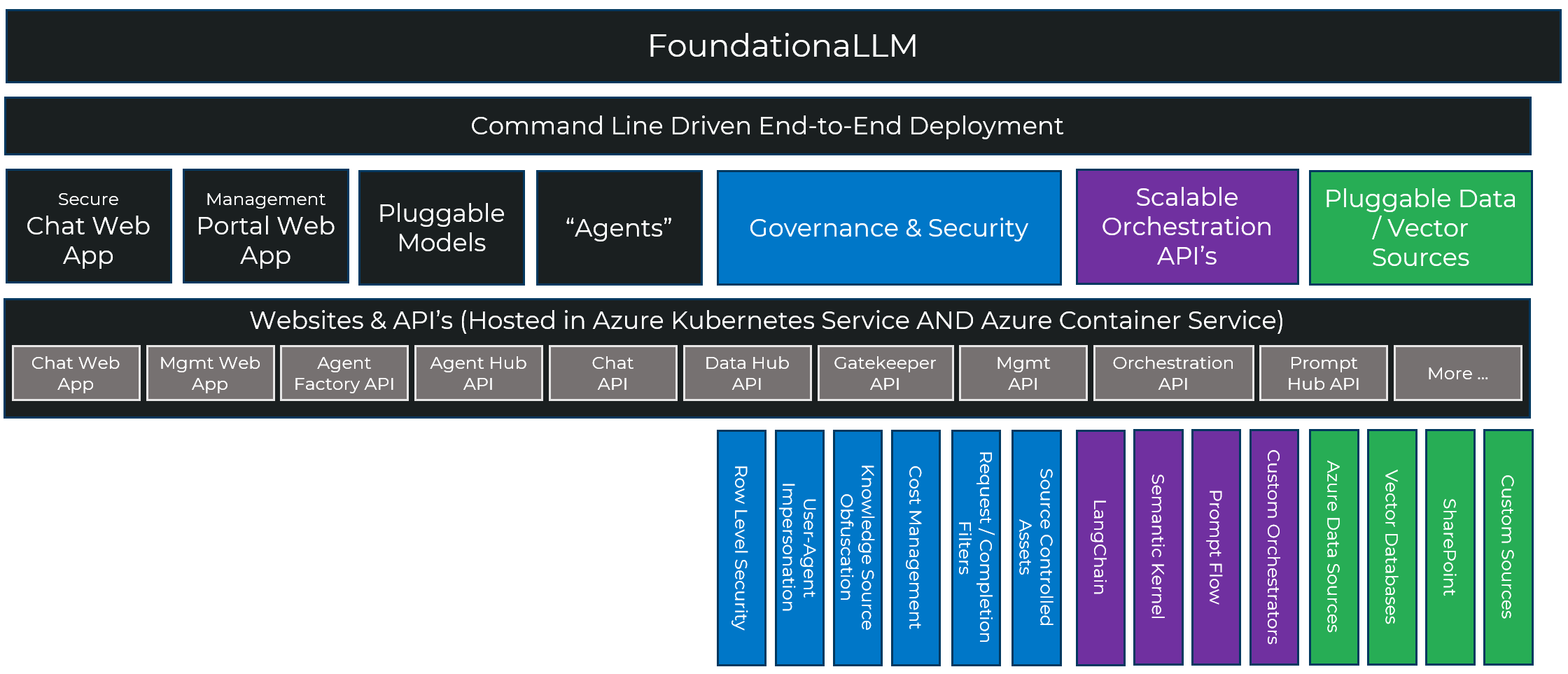

De nombreux composants entrent en jeu dans la création d'un agent d'IA sécurisé, bien gouverné, évolutif et extensible et Foundationa LLM fournit une pile complète pour rendre ce processus plus rapide, plus reproductible et plus fiable :

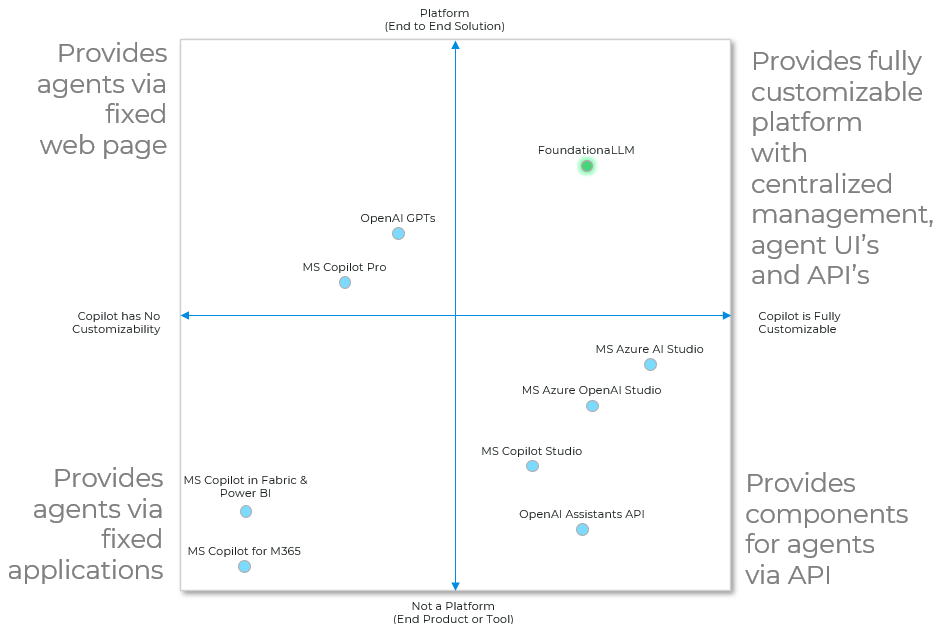

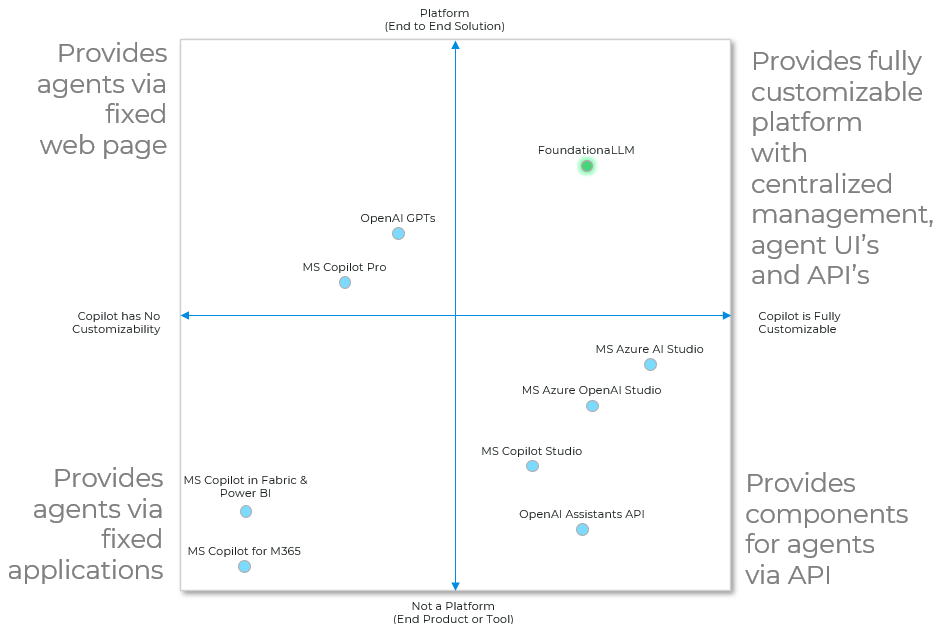

Où se situe Foundationa LLM par rapport aux autres solutions ?

Il existe de nombreux outils formidables dans l’écosystème qui facilitent certaines parties de la création d’un copilote ou d’un agent IA. Seul Foundationa LLM les rassemble pour fournir la plate-forme de bout en bout permettant de créer des agents d'IA entièrement personnalisables avec une gestion centralisée, des interfaces utilisateur et des API d'agent.

À la base, un copilote ou un agent d'IA utilise les connaissances fournies par l'entreprise et les modèles d'IA génératifs pour rédiger du texte, écrire du code ou restituer des images, souvent en raisonnant sur des invites fournies par l'homme. Dans ces modalités, l’IA est utilisée pour assister directement un humain dans une tâche spécifique.

Cette capacité de base apparaît dans deux archétypes, tous deux pris en charge de manière native par Foundationa LLM :

- Gestion des connaissances : aidez les utilisateurs à trouver rapidement les informations qu'ils recherchent et à les diffuser au bon niveau et dans le bon format. Les exemples incluent le résumé, la reformulation ou le reciblage pour s'adresser à un personnage (par exemple, expliquez-le comme si j'avais cinq ans), l'analyse des sentiments et les recommandations.

- Analytics : aidez les utilisateurs à accéder rapidement aux informations basées sur les données qu'ils recherchent. Les exemples incluent les recommandations, les prédictions, la détection d’anomalies, l’analyse statistique ainsi que l’interrogation et la création de rapports de données.

Foundationa LLM simplifie et rationalise la création d'agents de gestion des connaissances (par exemple, agents de questions/réponses) et d'analyse (par exemple, business intelligence en libre-service) sur les sources de données présentes dans votre entreprise.

Documentation

Familiarisez-vous avec Foundationa LLM en lisant la documentation. Cela inclut les instructions de déploiement, les démarrages rapides, l'architecture et les références API.

Commencer

Foundationa LLM fournit une approche simple basée sur la ligne de commande pour mettre en place et exécuter votre premier déploiement. En gros, ce sont deux commandes. Après cela, vous pouvez personnaliser la solution, l'exécuter localement sur votre machine et mettre à jour le déploiement avec vos personnalisations.

Suivez les instructions de déploiement rapide pour déployer Foundationa LLM dans votre abonnement Azure.

Signalement des problèmes et assistance

Si vous rencontrez des problèmes avec Foundationa LLM , veuillez ouvrir un problème sur GitHub. Nous répondrons à votre problème dans les plus brefs délais. Veuillez utiliser les étiquettes ( bug , documentation , general question , release xxx ) pour catégoriser votre problème et fournir autant de détails que possible pour nous aider à comprendre et à résoudre le problème.

Contribuer à Foundationa LLM

Nous sommes heureux d'accepter les contributions au projet FoundationaLLM sous forme de commentaires, de rapports de bogues et de demandes d'extraction. Veuillez consulter Contribuer à FoundationaLLM pour obtenir des instructions.