tinker chat

1.0.0

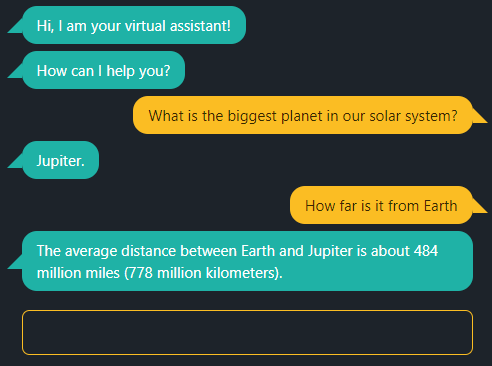

Cette application de chat prend en charge le GPT d'OpenAI ou votre propre LLM local.

Pour utiliser GPT depuis OpenAI, définissez la variable d'environnement OPENAI_API_KEY sur votre clé API.

Pour utiliser llama.cpp localement avec son moteur d'inférence, chargez d'abord un modèle quantifié tel que Phi-3 Mini, par exemple :

/path/to/llama.cpp/server -m Phi-3-mini-4k-instruct-q4.gguf Avant de lancer la démo, définissez la variable d'environnement OPENAI_API_BASE :

export OPENAI_API_BASE=http://127.0.0.1:8080Avec Node.js >= v18 :

npm install

npm start

et ouvrez localhost:5000 avec un navigateur Web.