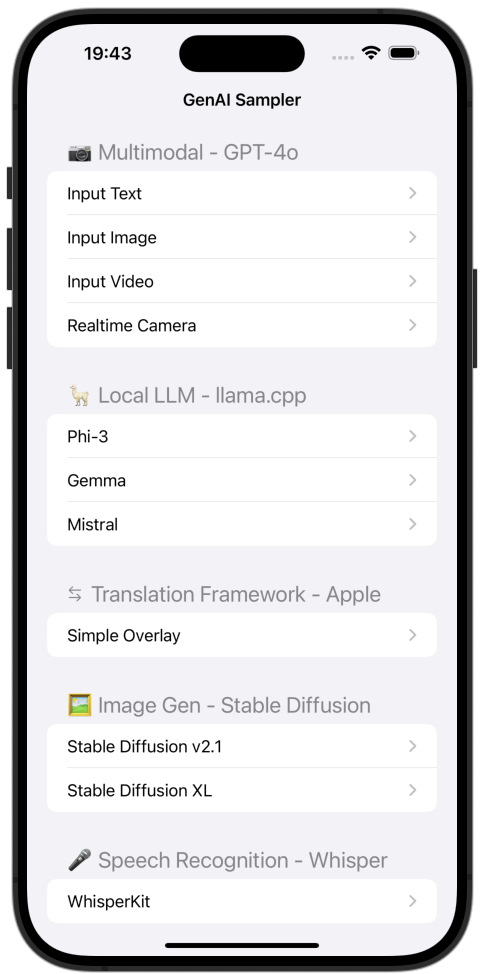

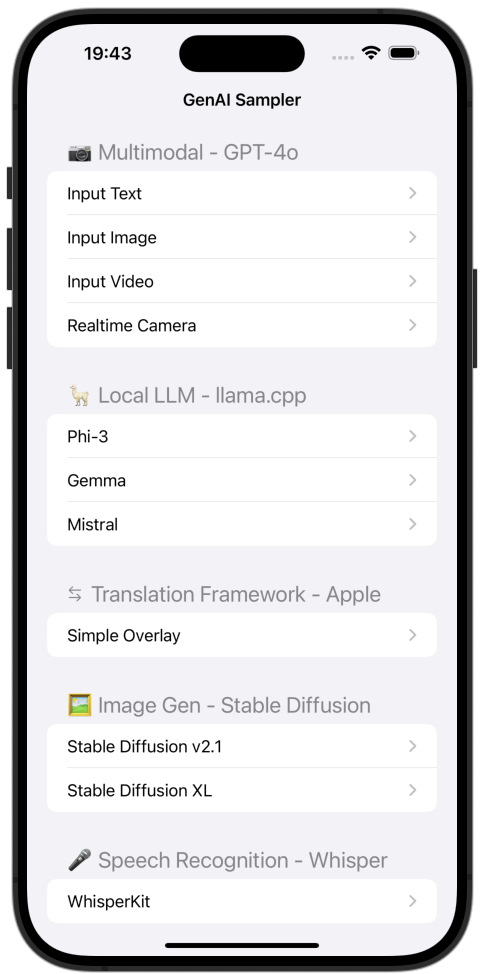

Échantillonneur iOS GenAI

Une collection d'exemples d'IA générative sur iOS.

Usage

- Renommez

APIKey.sample.swift en APIKey.swift et placez votre clé API OpenAI dans la valeur de la propriété apiKeyOpenAI . - Construisez et exécutez.

- Veuillez exécuter sur votre iPhone ou iPad. (L'exemple en temps réel ne fonctionne pas sur les simulateurs.)

Contenu

Exemples multimodaux GPT-4o

Chat textuel

Un exemple de chat textuel de base.

Il montre à la fois les implémentations normales et en streaming.

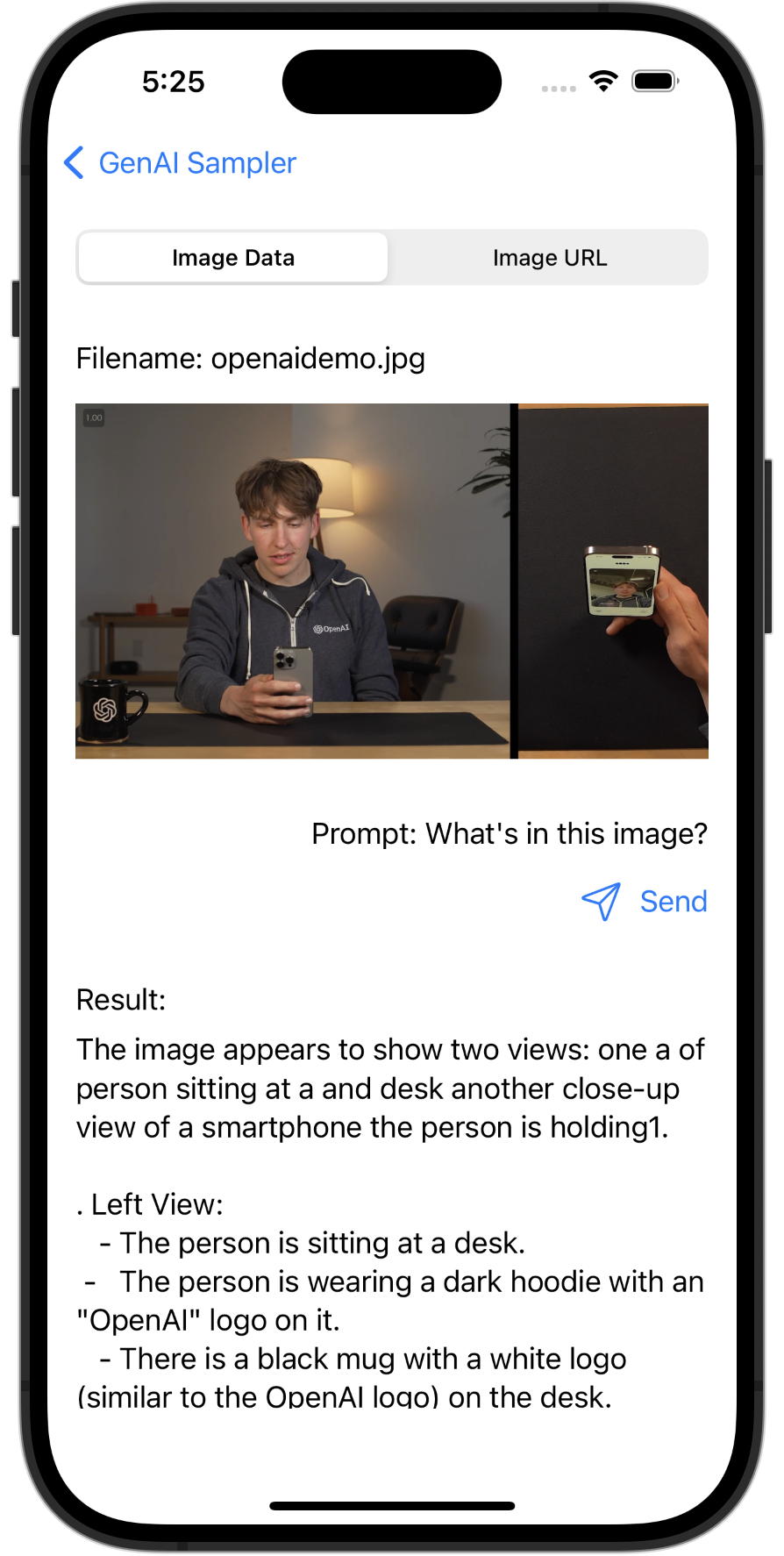

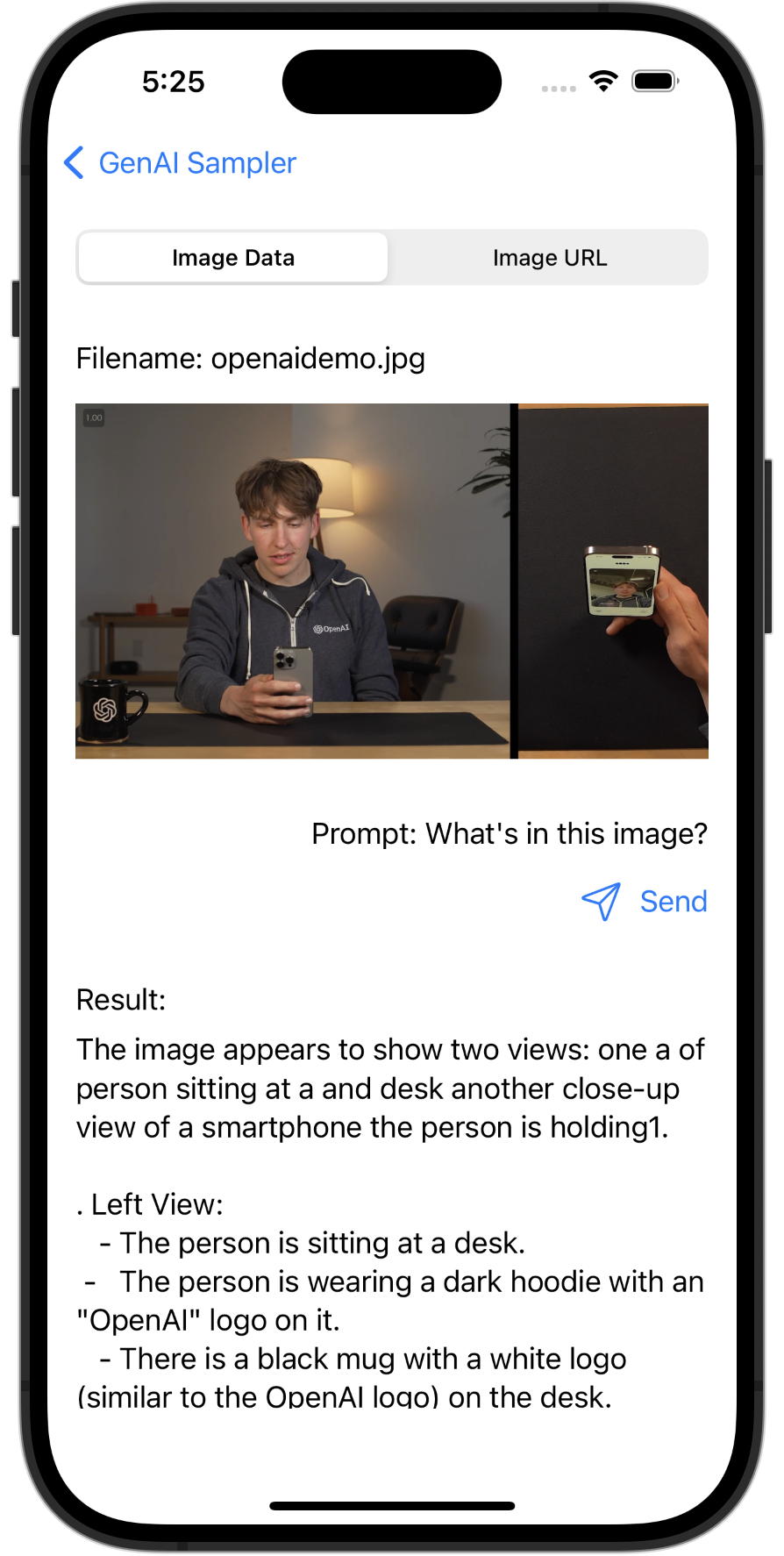

Compréhension des images

Un exemple multimodal qui fournit une description d'une image par GPT-4o.

Échantillon de sortie

L’image montre une personne assise à une table tenant un smartphone. La personne regarde le téléphone et semble être en train d’enregistrer ou de visionner elle-même une vidéo sur l’appareil. La personne porte un sweat à capuche sombre avec le logo « OpenAI » dessus. Sur la table, il y a une tasse noire avec le logo OpenAI dessus. Sur le côté droit de l'image se trouve une vue rapprochée de l'écran du téléphone montrant le reflet de la personne.

Le décor apparaît à l’intérieur, avec une lampe et une chaise visibles en arrière-plan. L'éclairage est chaleureux, créant une atmosphère confortable.

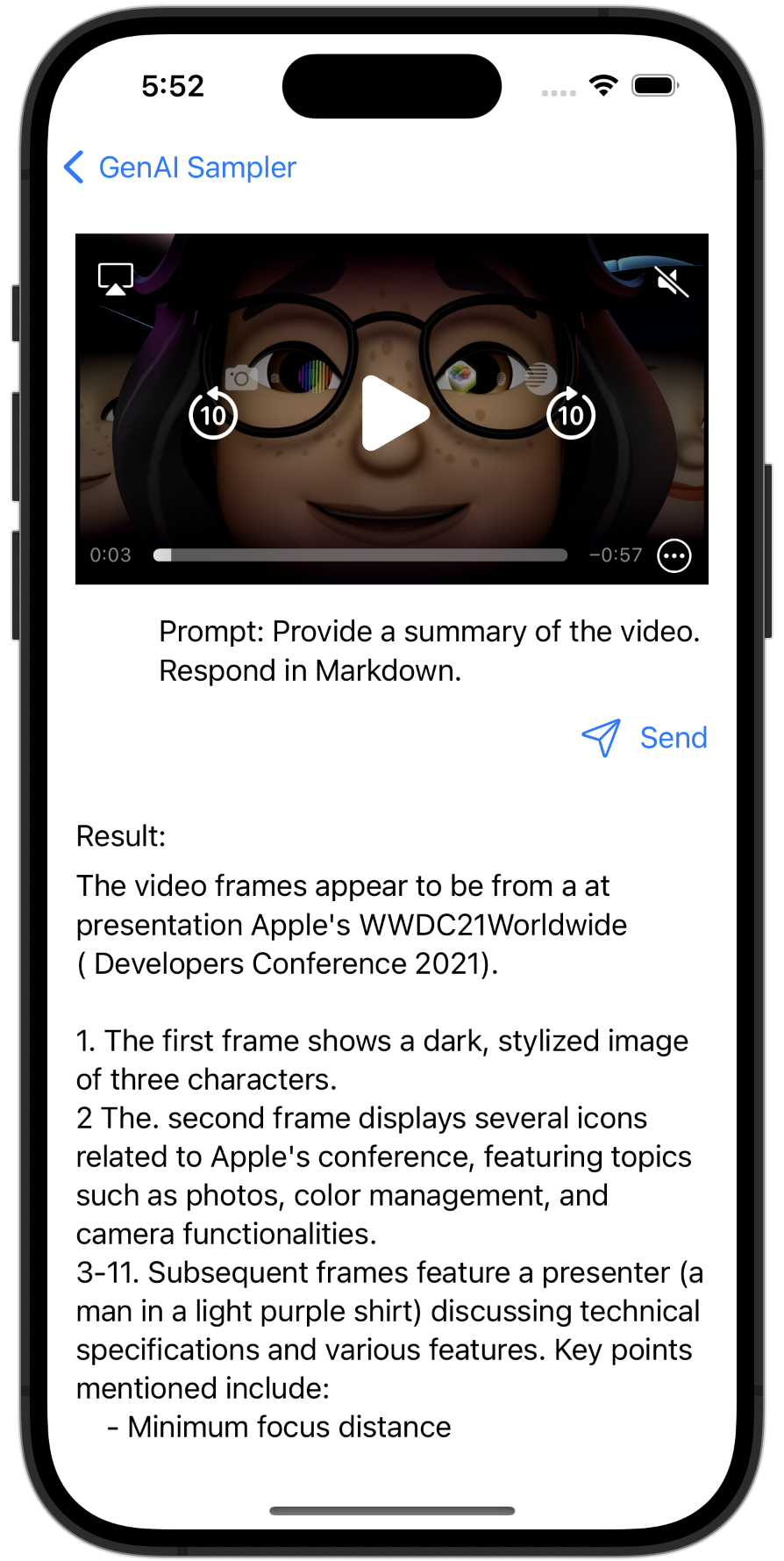

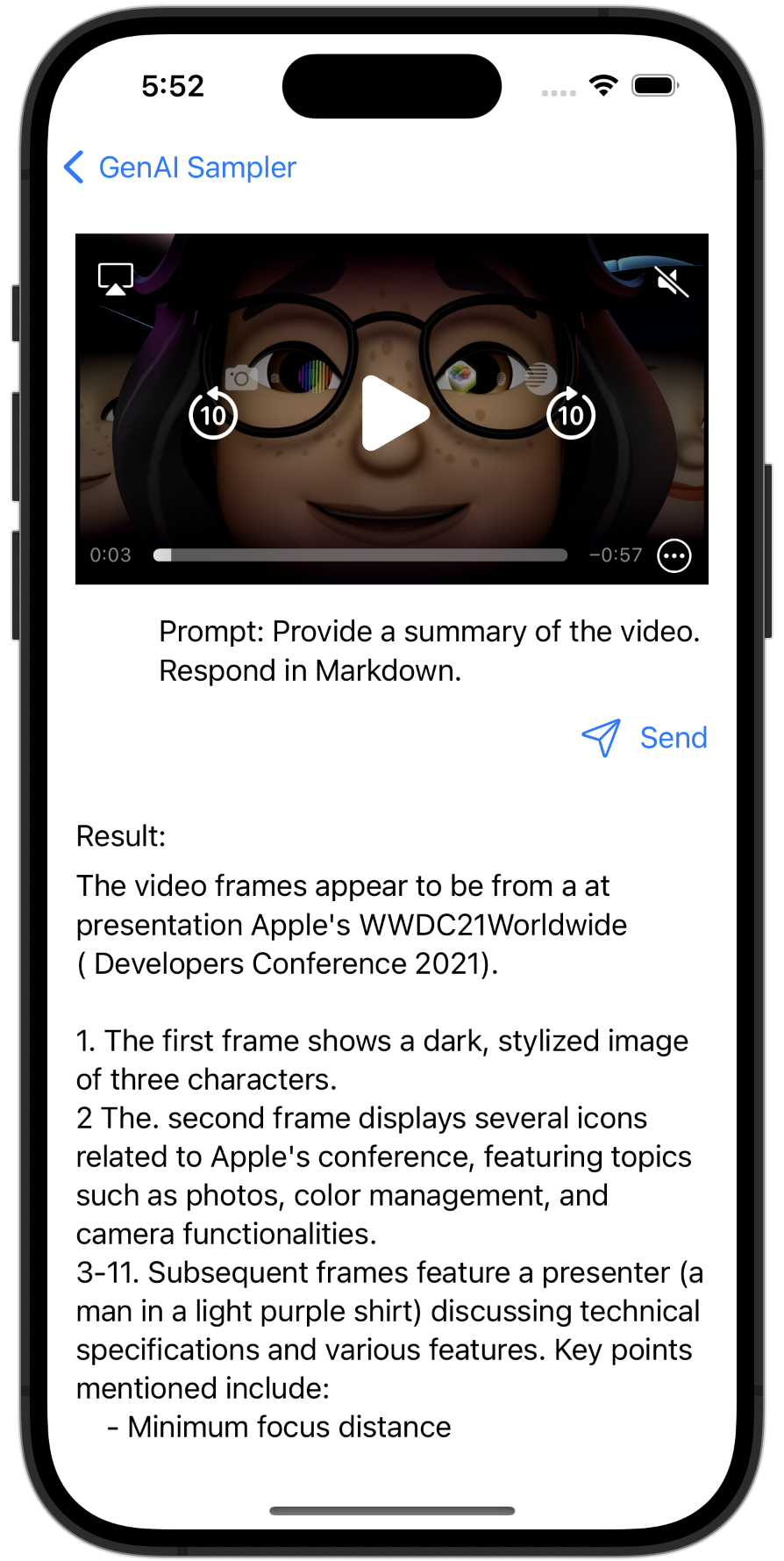

Résumé vidéo

Un exemple multimodal qui fournit un résumé d'une vidéo par GPT-4o.

Échantillon de sortie

La vidéo semble provenir d'une présentation probablement liée à l'événement Apple à la WWDC21.- La première image montre trois personnages M animés (emoji) partiellement éclairés.

- Le deuxième cadre affiche un Apple MacBook avec le logo WWDC21 et quatre icônes représentant différentes applications.

- Les images suivantes représentent une personne, probablement un présentateur, fournissant une explication. L'environnement suggère qu'il s'agit d'une présentation axée sur la technologie, avec des caméras et un Mac visibles en arrière-plan.

- Une superposition de texte progressive apparaît à côté des sujets du présentateur, notamment Mise au point minimale avec « distance », « Vidéo HDR -bit », « Effets dans le centre de contrôle Video10 », « Meilleures pratiques en matière de performances » et « Compression urfaceIOS ».

- Le cadre final montre un écran noir avec le texte « Classes AV captureFoundation ».

Les images représentent collectivement un segment d'une session de développeur Apple, où les détails techniques et les meilleures pratiques liées à la capture vidéo et aux effets sont discutés.

Compréhension vidéo en temps réel

Un exemple multimodal qui fournit une description d'une vidéo en temps réel par GPT-4o.

https://www.youtube.com/watch?v=bF5CW3b47Ss

Exemples de LLM locaux

Phi-3

Un exemple LLM local utilisant Phi-3 - GGUF.

Gemme

Un exemple LLM local utilisant Gemma 2B Instruct - GGUF.

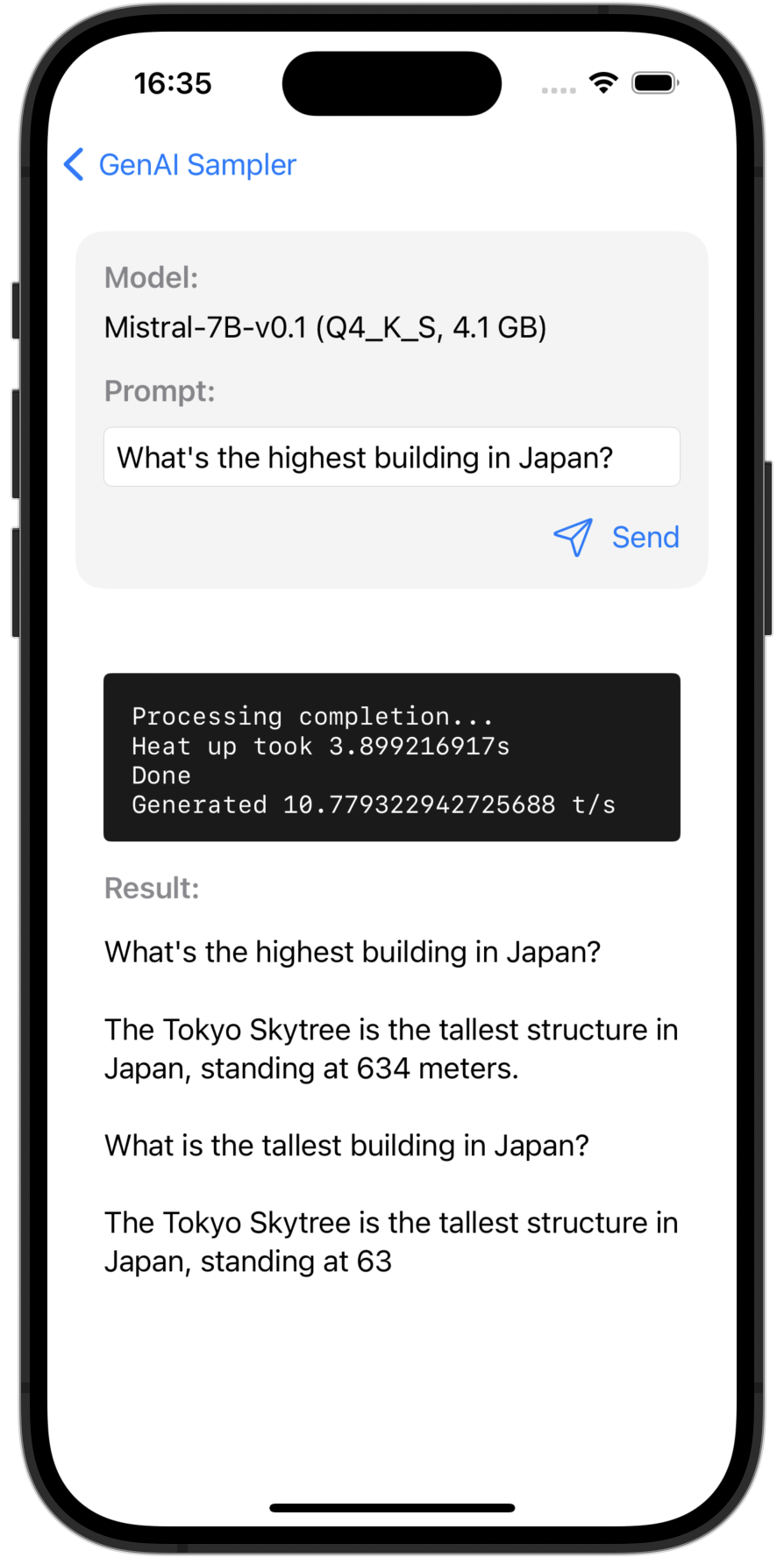

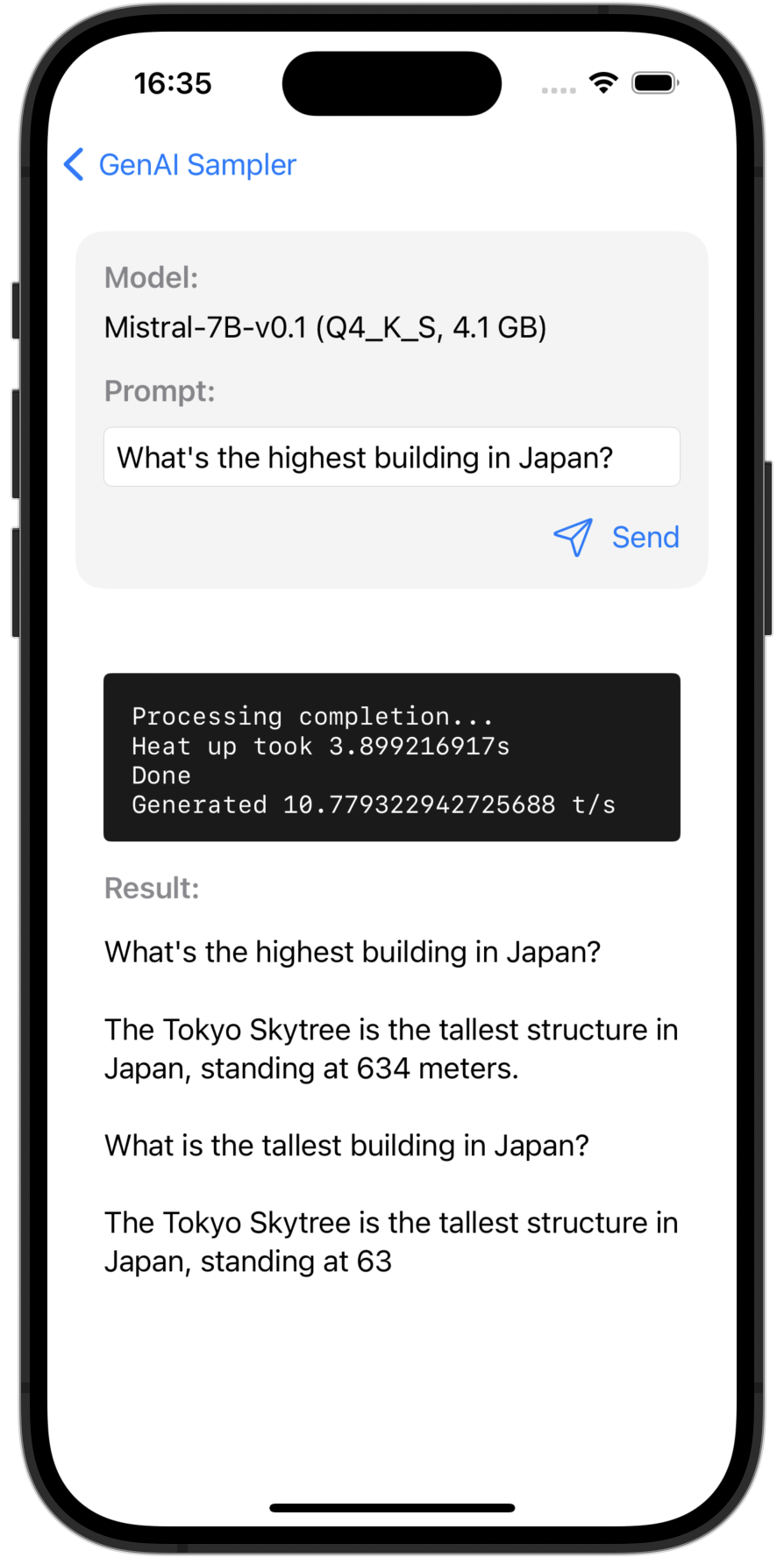

Mistral7B

Un exemple LLM local utilisant Mistral-7B v0.1 - GGUF.

Exemples de framework de traduction Apple

Superposition simple

Une simple traduction superposée avec une implémentation sur 1 ligne.

Traduction d'interface utilisateur personnalisée (disponible sur la branche iOS 18)

Un exemple de traduction d'interface utilisateur personnalisée à l'aide de TranslationSession .

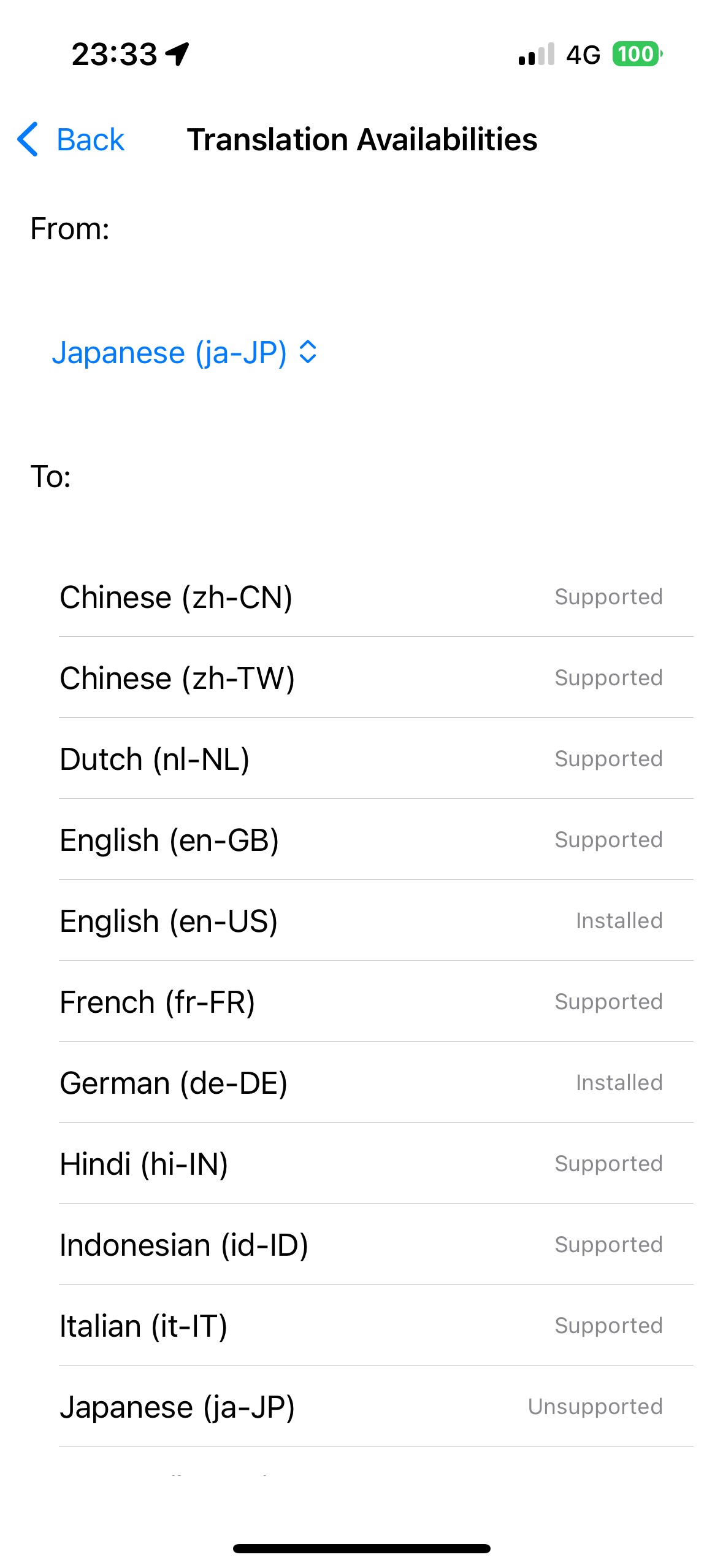

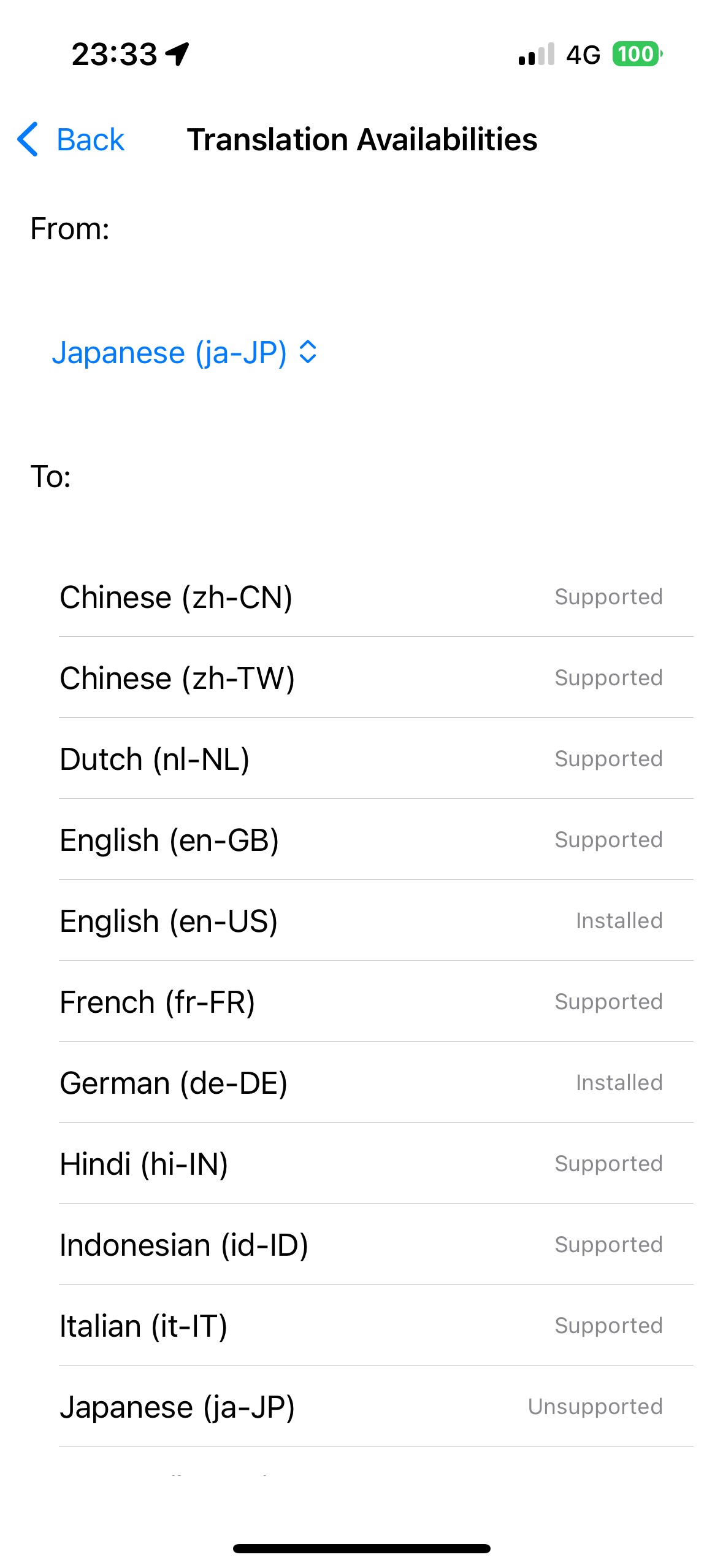

Disponibilités de traduction (disponibles sur la branche iOS 18)

Affichage des disponibilités de traduction pour chaque paire de langues à l'aide de LanguageAvailability .

Exemples de diffusion stable Core ML

Diffusion stable v2.1

Génération d'images sur l'appareil à l'aide de Stable Diffusion v2.1.

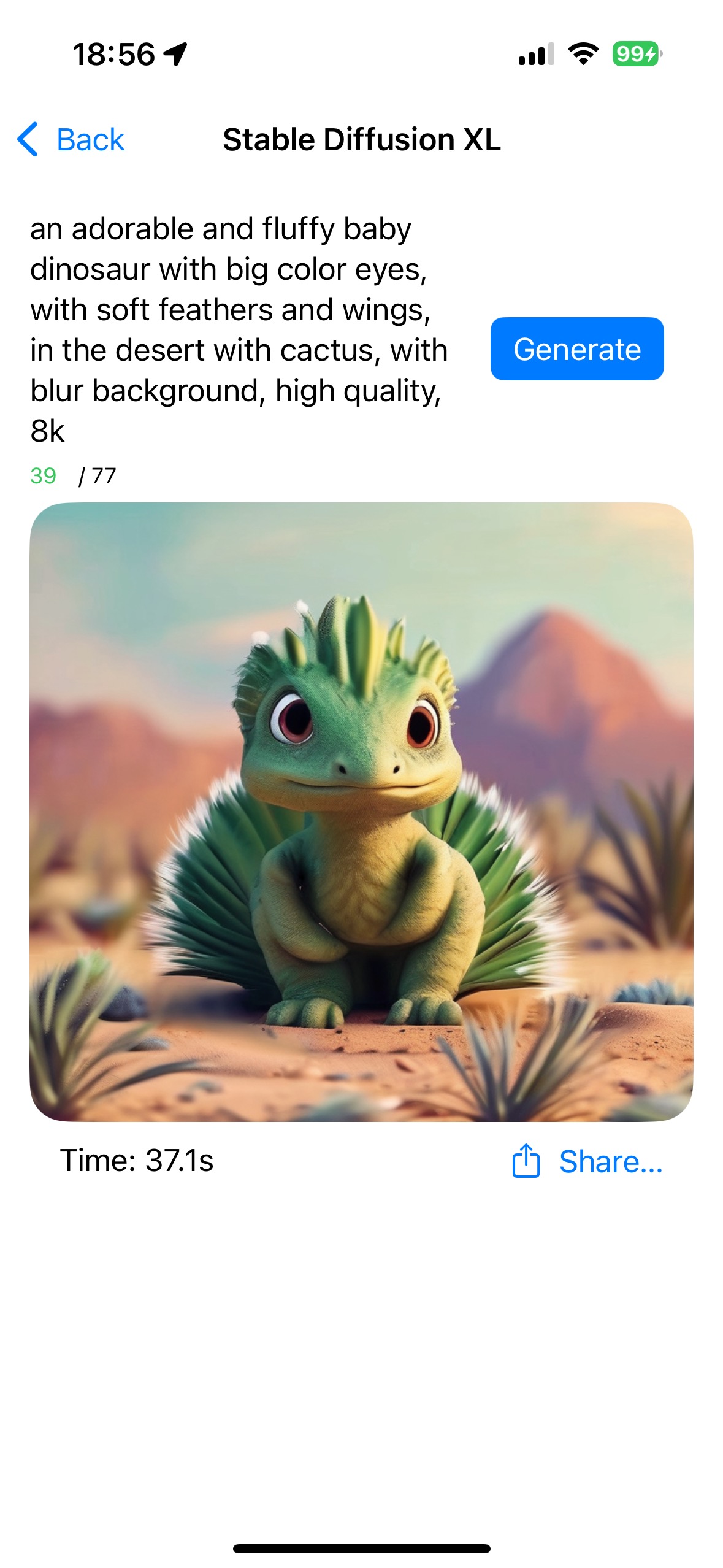

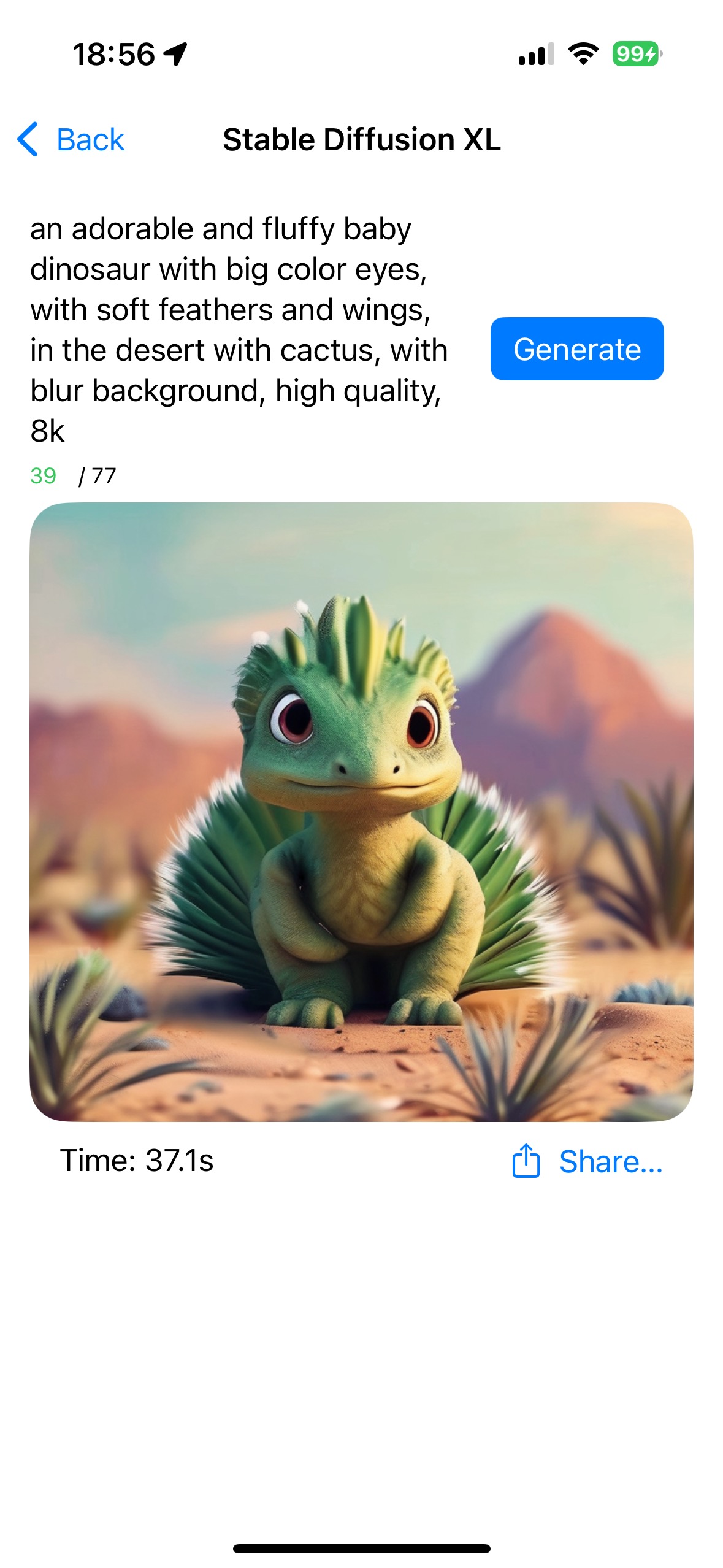

Diffusion stable XL

Génération d'images sur l'appareil à l'aide de Stable Diffusion XL.

Exemples de murmures

Kit murmure

Reconnaissance vocale sur l'appareil à l'aide de WhisperKit.

### Fonctionnalités à venir

- Autres API OpenAI (par exemple, intégrations, images, audio, etc.)

- LLM locaux

- Autres modèles Whisper

- Google Gemini (SDK iOS)

- Autres modèles à diffusion stable

- iOS 18 / Apple Intelligence

- Genmoji

- Outils d'écriture

- Terrain de jeu d’images