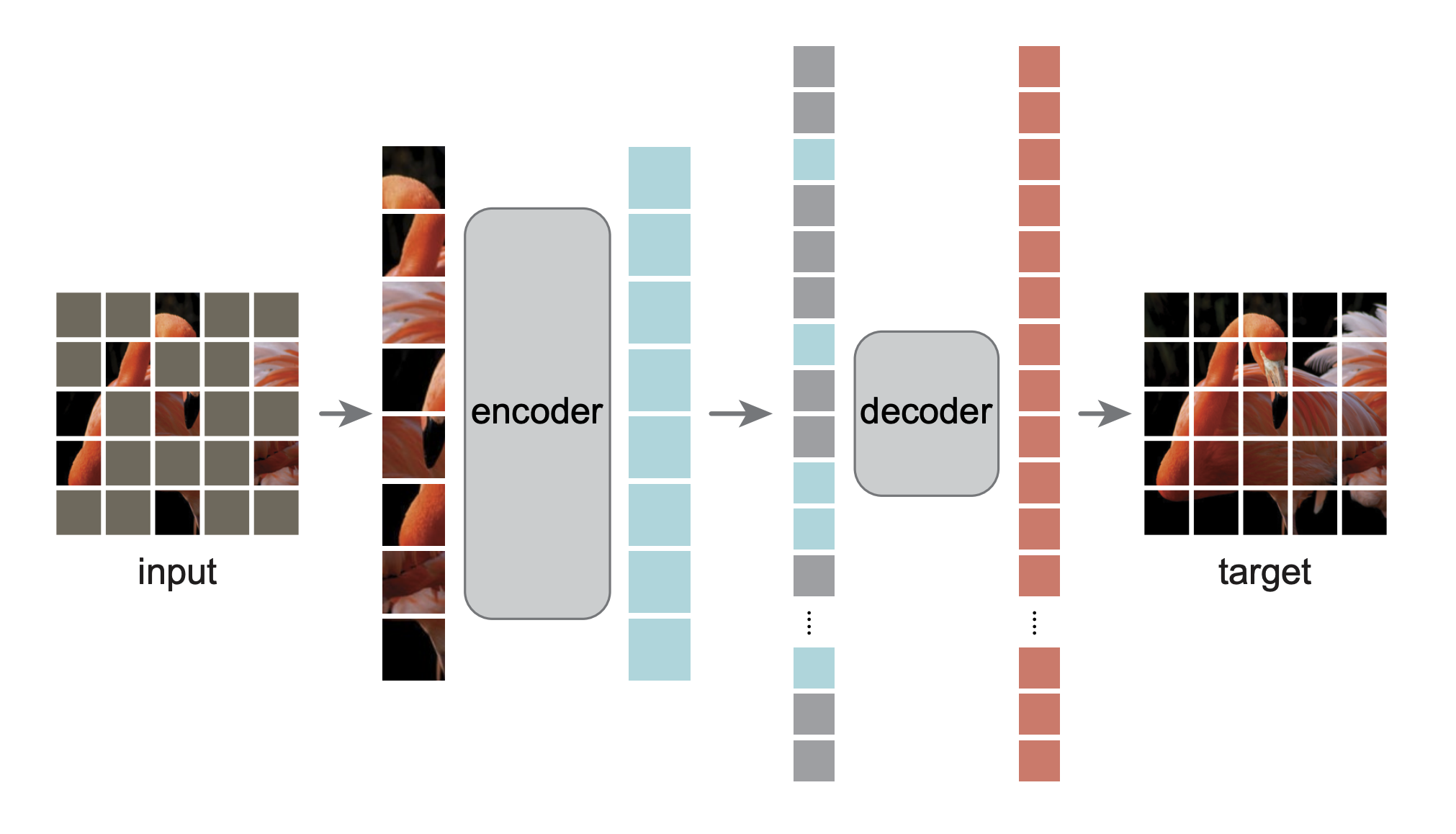

Il s'agit d'une réimplémentation PyTorch/GPU de l'article Les auto-encodeurs masqués sont des apprenants à vision évolutive :

@Article{MaskedAutoencoders2021,

author = {Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Doll{'a}r and Ross Girshick},

journal = {arXiv:2111.06377},

title = {Masked Autoencoders Are Scalable Vision Learners},

year = {2021},

}

L'implémentation originale était dans TensorFlow+TPU. Cette réimplémentation est dans PyTorch+GPU.

Ce repo est une modification du repo DeiT. L'installation et la préparation suivent ce dépôt.

Ce dépôt est basé sur timm==0.3.2 , pour lequel un correctif est nécessaire pour fonctionner avec PyTorch 1.8.1+.

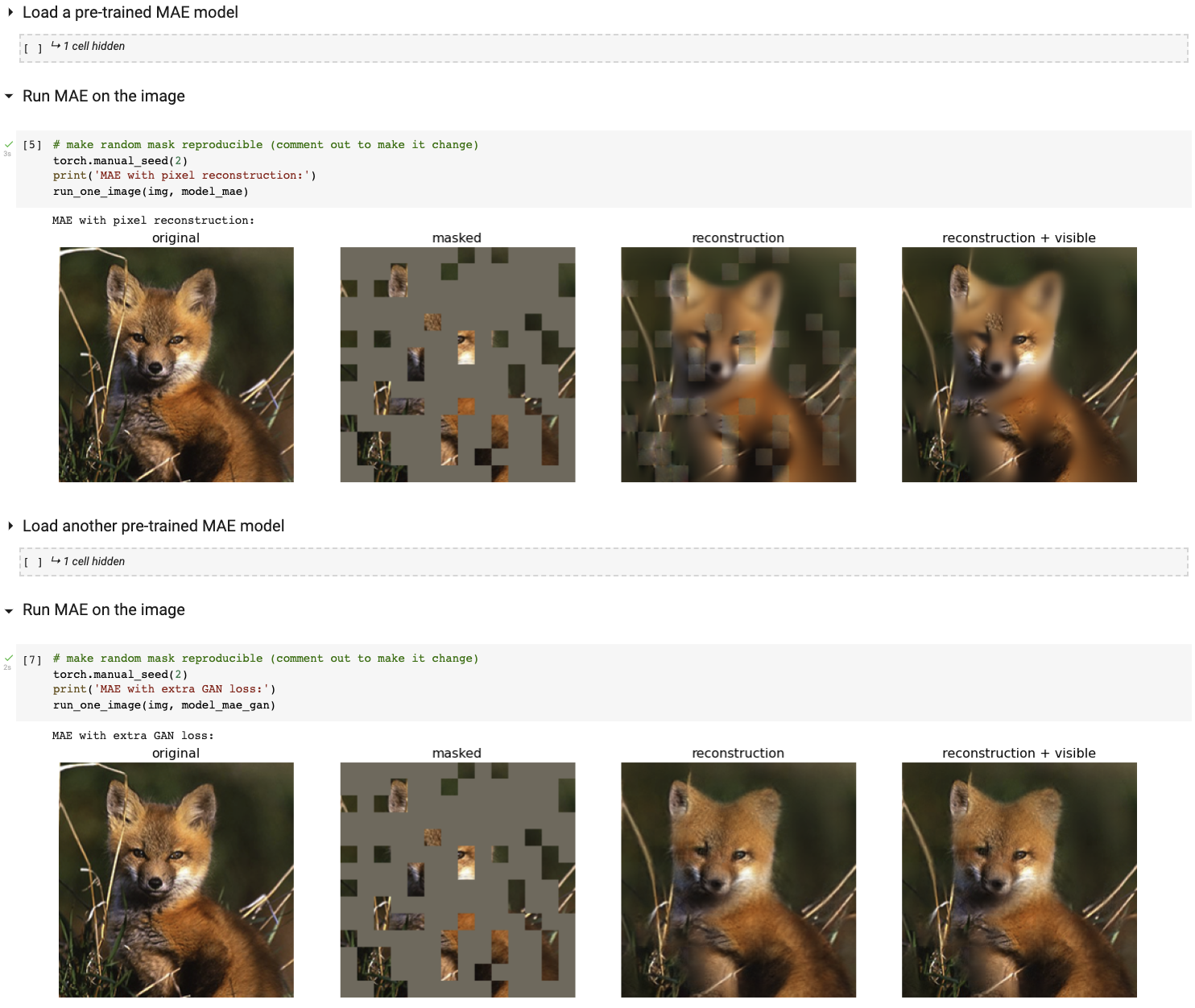

Exécutez notre démo de visualisation interactive à l'aide du notebook Colab (aucun GPU requis) :

Le tableau suivant fournit les points de contrôle pré-entraînés utilisés dans l'article, convertis de TF/TPU en PT/GPU :

| Base ViT | ViT-Large | ViT-Énorme | |

|---|---|---|---|

| point de contrôle pré-entraîné | télécharger | télécharger | télécharger |

| md5 | 8cad7c | b8b06e | 9bdbb0 |

Les instructions de réglage fin se trouvent dans FINETUNE.md.

En affinant ces modèles pré-entraînés, nous nous classons n°1 dans ces tâches de classification (détaillées dans l'article) :

| ViT-B | ViT-L | ViT-H | ViT-H 448 | précédent meilleur | |

|---|---|---|---|---|---|

| ImageNet-1K (pas de données externes) | 83,6 | 85,9 | 86,9 | 87,8 | 87.1 |

| Voici l'évaluation des mêmes poids de modèle (affinés dans ImageNet-1K d'origine) : | |||||

| ImageNet-Corruption (taux d'erreur) | 51,7 | 41,8 | 33,8 | 36,8 | 42,5 |

| ImageNet-Adversaire | 35,9 | 57.1 | 68,2 | 76,7 | 35,8 |

| Rendu ImageNet | 48.3 | 59,9 | 64,4 | 66,5 | 48,7 |

| ImageNet-Sketch | 34,5 | 45.3 | 49,6 | 50,9 | 36,0 |

| Voici l'apprentissage par transfert en affinant le MAE pré-entraîné sur l'ensemble de données cible : | |||||

| iNaturalistes 2017 | 70,5 | 75,7 | 79,3 | 83,4 | 75,4 |

| iNaturalistes 2018 | 75,4 | 80,1 | 83,0 | 86,8 | 81.2 |

| iNaturalistes 2019 | 80,5 | 83,4 | 85,7 | 88,3 | 84.1 |

| Lieux205 | 63,9 | 65,8 | 65,9 | 66,8 | 66,0 |

| Lieux365 | 57,9 | 59,4 | 59,8 | 60,3 | 58,0 |

L'instruction de pré-formation se trouve dans PRETRAIN.md.

Ce projet est sous licence CC-BY-NC 4.0. Voir LICENCE pour plus de détails.