Beijing Zhipu Huazhang Technology Co., Ltd. a lancé le modèle open source Cogvideox V1.5, qui a fait des percées importantes dans le domaine de la génération vidéo. Après sa sortie début août, la série Cogvideox est rapidement devenue l'objectif de l'industrie avec ses principales technologies et ses fonctionnalités adaptées aux développeurs. Cette mise à jour a apporté de nombreuses améliorations, notamment en soutenant la génération de vidéos plus longue et supérieure, ainsi qu'une amélioration significative de la qualité et de la compréhension sémantique de la vidéo de génération d'images, offrant aux utilisateurs une meilleure expérience de génération de vidéos d'IA. Ce qui mérite le plus de noter, c'est que la nouvelle version intègre la plate-forme Qingying et le modèle d'effet sonore Cogsound, améliorant davantage l'écosystème de génération de vidéos.

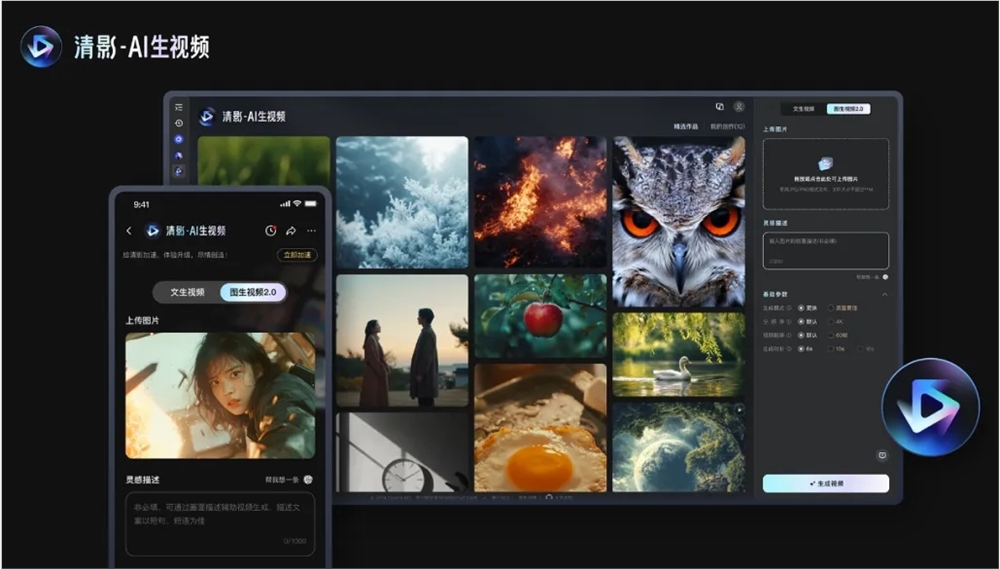

Le contenu de cette open source comprend deux modèles: Cogvideox V1.5-5b et Cogvideox V1.5-5b-I2V. La nouvelle version sera également lancée sur la plate-forme Qingying simultanément, et sera combinée avec le modèle d'effet sonore Cogsound nouvellement lancé pour fournir une amélioration de la qualité, un support de résolution ultra-haute définition, des proportions variables pour s'adapter à différents scénarios de lecture, multi-canaux multi-canaux Sortie et vidéos AI avec des effets sonores.

Au niveau technique, Cogvideox V1.5 filtre les données vidéo qui manquent de connectivité dynamique via un cadre de filtrage automatisé et utilise un modèle de compréhension vidéo de bout capacités. In addition, the new version adopts an efficient three-dimensional variational autoencoder (3D VAE) to solve the problem of content coherence, and independently develops a Transformer architecture that integrates three-dimensional text, time and space, cancels the traditional cross-attention module et la technologie de normalisation de la couche adaptative experte optimise l'utilisation des informations de pas dans le temps dans le modèle de diffusion.

En termes de formation, Cogvideox V1.5 construit un cadre de formation de modèle de diffusion efficace et réalise une formation rapide de longues séquences vidéo grâce à une variété de techniques de calcul parallèle et d'optimisation du temps. La société a déclaré avoir vérifié l'efficacité de la loi d'échelle dans le domaine de la génération de vidéos et prévoit d'étendre le volume des données et l'échelle du modèle à l'avenir, d'explorer des architectures de modèle innovantes pour compresser plus efficacement des informations vidéo et mieux intégrer le contenu de texte et de vidéo.

Code: https://github.com/thudm/cogvideo

Modèle: https://huggingface.co/thudm/cogvideox1.5-5b-sat

L'open source de Cogvideox v1.5 fournit un nouvel élan pour le développement de la technologie de génération de vidéos et fournit aux développeurs des outils plus puissants. L'innovation technologique continue et l'esprit open source de Zhipu Huazhang sont dignes de reconnaissance, et les futures perspectives d'application de ce modèle méritent d'être attendues. Dans l'attente d'applications plus innovantes basées sur Cogvideox v1.5.