KoGPT2 chatbot

1.0.0

Expérience de chatbot simple utilisant les données de chatbot Hangul accessibles au public et KoGPT2 pré-entraîné

Nous explorons le potentiel de diverses utilisations de KoGPT2 et évaluons qualitativement ses performances.

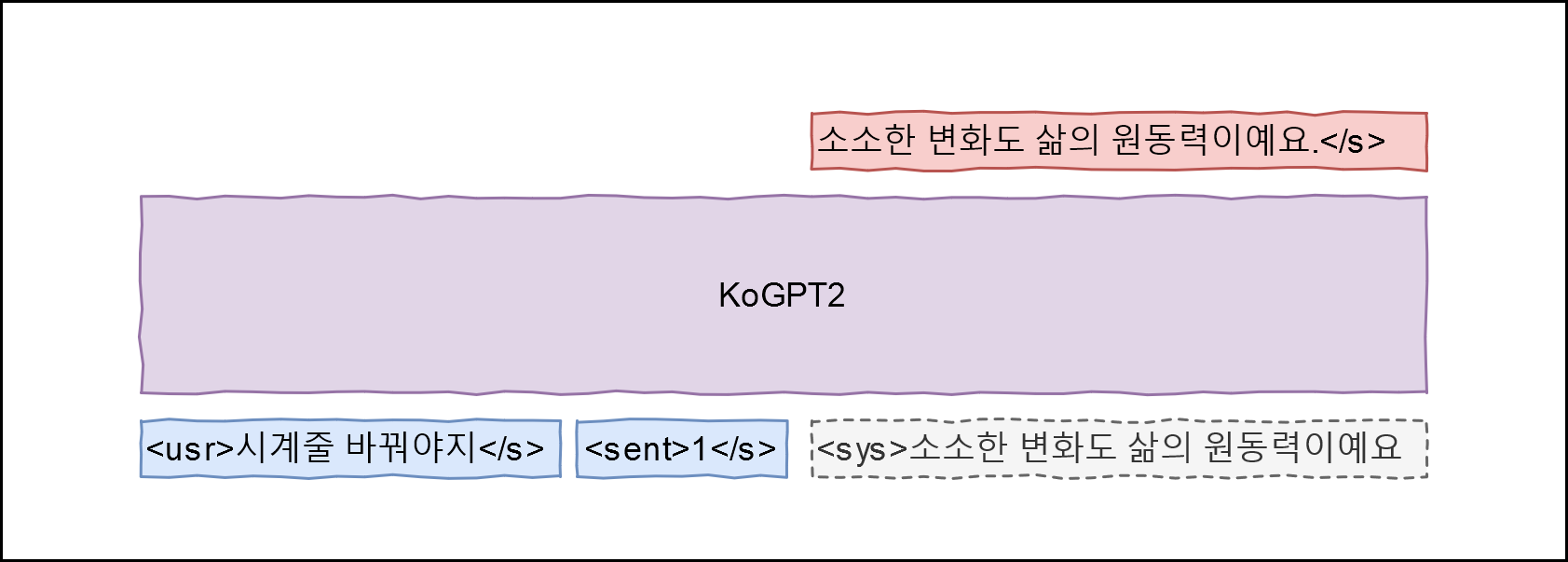

Bonjour ! convient aux données de formation. En appliquant GPT-2, nous avons conçu l'architecture suivante

Apprenez un modèle qui peut maximiser P(<sys>|<usr>, <sent>) en mappant le champ Q des données à l'énoncé <usr> , le champ A à l'énoncé <sys> et l'étiquette d'émotion à <sent> Les étiquettes d'émotion suivent les définitions ici (occurrence quotidienne 0, rupture (négative) 1, amour (positif) 2).

git clone --recurse-submodules https://github.com/haven-jeon/KoGPT2-chatbot.gitcd KoGPT2-chatbot pip3 install -r exigences.txt

CUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --train --max_epochs 2

# CUDA_VISIBLE_DEVICES=0 python train.py --chatCUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --chat utilisateur > jackpot Simsimi > Tout ira bien. utilisateur > Quel est votre nom ? Simsimi > Je suis Wirobot. utilisateur > Que faisons-nous le jour de la fête des parents ? Simsimi > Joue avec moi. utilisateur > Il pleut Simsimi > Prenez un parapluie. utilisateur > Il neige Simsimi > Construisez un bonhomme de neige. utilisateur > Le tonnerre frappe Simsimi > Tu me manques aussi. utilisateur > Le printemps est arrivé. Simsimi > J'ai toujours hâte au printemps. utilisateur > J'ai mal au ventre. Simsimi > Rentrez chez vous et reposez-vous vite. utilisateur > Qui vous a créé ? Simsimi > Vous êtes la personne qui vous a créé.

PyTorch