Le code est une implémentation de Paper Attention, c'est tout ce dont vous avez besoin pour travailler sur des tâches de génération de dialogue telles que : Chatbot , Génération de texte , etc.

Merci à tous les amis qui ont soulevé des problèmes et aidé à les résoudre. Votre contribution est très importante pour l'amélioration de ce projet. En raison de la prise en charge limitée du « mode graphique statique » dans le codage, nous avons décidé de déplacer les fonctionnalités vers la version 2.0.0-beta1. Cependant, si vous vous inquiétez des problèmes liés à la création de Docker et à la création de services avec des problèmes de version, nous conservons toujours une ancienne version du code écrite en mode impatient en utilisant la version Tensorflow 1.12.x pour référence.

|-- root/

|-- data/

|-- src-train.csv

|-- src-val.csv

|-- tgt-train.csv

`-- tgt-val.csv

|-- old_version/

|-- data_loader.py

|-- eval.py

|-- make_dic.py

|-- modules.py

|-- params.py

|-- requirements.txt

`-- train.py

|-- tf1.12.0-eager/

|-- bleu.py

|-- main.ipynb

|-- modules.py

|-- params.py

|-- requirements.txt

`-- utils.py

|-- images/

|-- bleu.py

|-- main-v2.ipynb

|-- modules-v2.py

|-- params.py

|-- requirements.txt

`-- utils-v2.py

Comme nous le savons tous, le système de traduction peut être utilisé pour mettre en œuvre un modèle conversationnel simplement en remplaçant les paris de deux phrases différentes par des questions et des réponses. Après tout, le modèle de conversation de base nommé « Séquence à séquence » est développé à partir du système de traduction. Par conséquent, pourquoi ne pas améliorer l’efficacité du modèle de conversation dans la génération de dialogues ?

Avec le développement de modèles basés sur BERT, de plus en plus de tâches NLP sont constamment actualisées. Cependant, le modèle de langage n'est pas contenu dans les tâches open source du BERT. Il ne fait aucun doute que, dans ce domaine, nous avons encore un long chemin à parcourir.

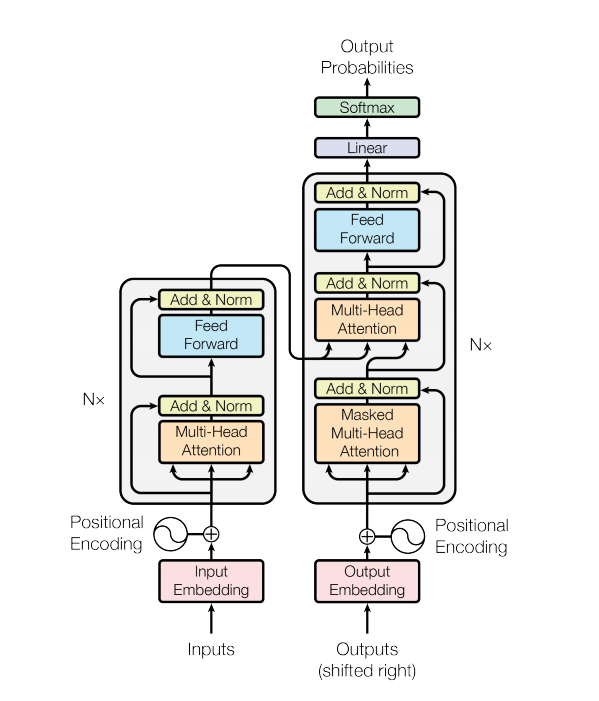

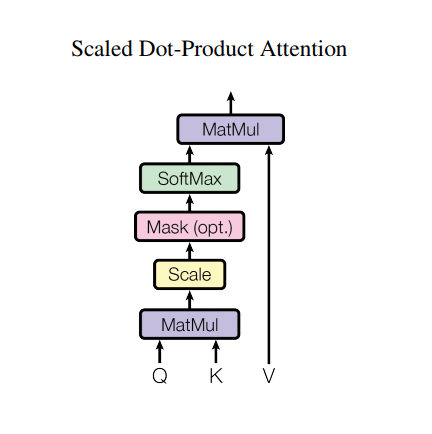

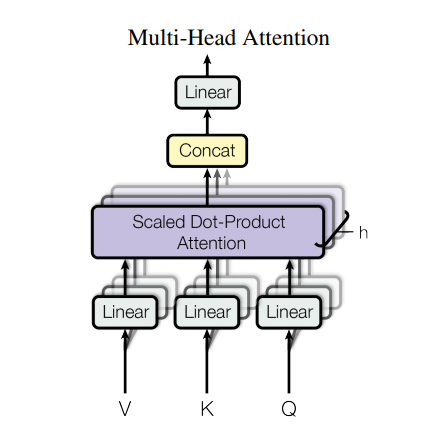

Un modèle de transformateur gère les entrées de taille variable en utilisant des piles de couches d'auto-attention au lieu de RNN ou de CNN. Cette architecture générale présente de nombreux avantages et particularités. Maintenant, retirons-les :

Dans la dernière version de notre code , nous complétons les détails décrits dans l'article.

Cependant, une architecture aussi solide présente encore quelques inconvénients :

data/ .params.py si vous le souhaitez.make_dic.py pour générer des fichiers de vocabulaire dans un nouveau dossier nommé dictionary .train.py pour créer le modèle. Checkpoint sera stocké dans le dossier checkpoint tandis que les fichiers d'événements tensorflow se trouvent dans logdir .eval.py pour évaluer le résultat avec les données de test. Le résultat sera stocké dans le dossier Results .GPU pour accélérer le traitement de la formation, veuillez configurer votre appareil dans le code. (Il prend en charge la formation multi-travailleurs) - Source: 肥 宅 初 夜 可 以 賣 多 少 `

- Ground Truth: 肥 宅 還 是 去 打 手 槍 吧

- Predict: 肥 宅 還 是 去 打 手 槍 吧

- Source: 兇 的 女 生 484 都 很 胸

- Ground Truth: 我 看 都 是 醜 的 比 較 凶

- Predict: 我 看 都 是 醜 的 比 較 <UNK>

- Source: 留 髮 不 留 頭

- Ground Truth: 還 好 我 早 就 禿 頭 了

- Predict: 還 好 我 早 就 禿 頭 了

- Source: 當 人 好 痛 苦 R 的 八 卦

- Ground Truth: 去 中 國 就 不 用 當 人 了

- Predict: 去 中 國 就 不 會 有 了 -

- Source: 有 沒 有 今 天 捷 運 的 八 卦

- Ground Truth: 有 - 真 的 有 多

- Predict: 有 - 真 的 有 多

- Source: 2016 帶 走 了 什 麼 `

- Ground Truth: HellKitty 麥 當 勞 歡 樂 送 開 門 -

- Predict: <UNK> 麥 當 勞 歡 樂 送 開 門 -

- Source: 有 沒 有 多 益 很 賺 的 八 卦

- Ground Truth: 比 大 型 包 裹 貴

- Predict: 比 大 型 包 <UNK> 貴

- Source: 邊 緣 人 收 到 地 震 警 報 了

- Ground Truth: 都 跑 到 窗 邊 了 才 來

- Predict: 都 跑 到 <UNK> 邊 了 才 來

- Source: 車 震

- Ground Truth: 沒 被 刪 版 主 是 有 眼 睛 der

- Predict: 沒 被 刪 版 主 是 有 眼 睛 der

- Source: 在 家 跌 倒 的 八 卦 `

- Ground Truth: 傷 到 腦 袋 - 可 憐

- Predict: 傷 到 腦 袋 - 可 憐

- Source: 大 家 很 討 厭 核 核 嗎 `

- Ground Truth: 核 核 欠 幹 阿

- Predict: 核 核 欠 幹 阿

- Source: 館 長 跟 黎 明 打 誰 贏 -

- Ground Truth: 我 愛 黎 明 - 我 愛 黎 明 -

- Predict: 我 愛 <UNK> 明 - 我 愛 <UNK> 明 -

- Source: 嘻 嘻 打 打

- Ground Truth: 媽 的 智 障 姆 咪 滾 喇 幹

- Predict: 媽 的 智 障 姆 咪 滾 喇 幹

- Source: 經 典 電 影 台 詞

- Ground Truth: 超 時 空 要 愛 裡 滿 滿 的 梗

- Predict: 超 時 空 要 愛 裡 滿 滿 滿 的

- Source: 2B 守 得 住 街 亭 嗎 `

- Ground Truth: 被 病 毒 滅 亡 真 的 會 -

- Predict: <UNK> 守 得 住

Si vous essayez d'utiliser AutoGraph pour accélérer votre processus de formation, assurez-vous que les ensembles de données sont complétés à une longueur fixe. En raison de l'opération de reconstruction du graphique, elle sera activée pendant l'entraînement, ce qui peut affecter les performances. Notre code assure uniquement les performances de la version 2.0, et les versions inférieures peuvent essayer de s'y référer.

Merci pour Transformer et Tensorflow