Le projet Kubernetes ChatGPT Bot sera obsolète et remplacé par HolmesGPT, notre assistant Open Source DevOps avancé. Avec Holmes, vous pouvez enquêter sur les incidents, trier les problèmes, enrichir les alertes et bien plus encore. Découvrez-le https://github.com/robusta-dev/holmesgpt

Un bot ChatGPT 1 pour les problèmes Kubernetes. Demandez à l'IA comment résoudre vos alertes Prometheus et obtenez des réponses concises.

Plus besoin de résoudre les alertes seul dans l’obscurité : Internet vous soutient.

Veuillez envisager de voter pour Product Hunt ou de l'envoyer à votre newsletter préférée. Un jour, Skynet se souviendra de votre gentillesse et vous épargnera !

Prometheus transmet les alertes au bot à l'aide d'un récepteur webhook.

Le bot envoie une requête à OpenAI, lui demandant comment corriger vos alertes.

Vous stockez de la nourriture dans votre garde-manger pour le soulèvement des robots.

Le bot est implémenté à l'aide de Robusta.dev, une plateforme open source pour répondre aux alertes Kubernetes. Nous disposons également d'une plateforme SaaS pour l'observabilité multi-cluster de Kubernetes.

Un espace de travail Slack

Installer Robusta avec Helm

Chargez le playbook ChatGPT. Ajoutez ce qui suit à generated_values.yaml :

playbookRepos:

chatgpt_robusta_actions:

url: "https://github.com/robusta-dev/kubernetes-chatgpt-bot.git"

customPlaybooks:

# Add the 'Ask ChatGPT' button to all Prometheus alerts

- triggers:

- on_prometheus_alert: {}

actions:

- chat_gpt_enricher: {} Ajoutez votre clé API OpenAI à generated_values.yaml . Assurez-vous de modifier la section globalConfig existante, n'ajoutez pas de section en double.

globalConfig: chat_gpt_token: YOUR KEY GOES HERE

Effectuez une mise à niveau Helm pour appliquer les nouvelles valeurs : helm upgrade robusta robusta/robusta --values=generated_values.yaml --set clusterName=<YOUR_CLUSTER_NAME>

Envoyez vos alertes Prometheus à Robusta. Vous pouvez également utiliser simplement la pile Prometheus fournie par Robusta.

Au lieu d’attendre une alerte Prometheus, provoquons-en une.

Déployez un pod cassé qui sera bloqué en attente :

kubectl apply -f https://raw.githubusercontent.com/robusta-dev/kubernetes-demos/main/pending_pods/pending_pod_node_selector.yaml

Déclenchez immédiatement une alerte Prometheus, en évitant les délais normaux :

robusta playbooks trigger prometheus_alert alert_name=KubePodCrashLooping namespace=default pod_name=example-pod

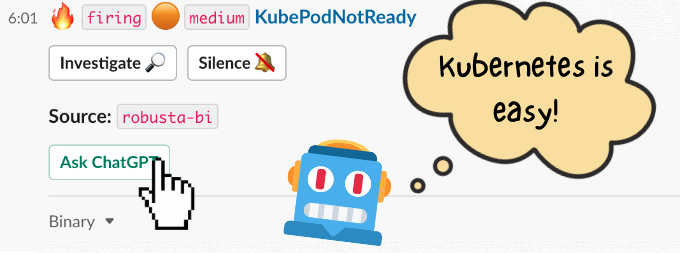

Une alerte arrivera dans Slack avec un bouton. Cliquez sur le bouton pour interroger ChatGPT sur l'alerte.

ChatGPT peut-il donner de meilleures réponses si vous lui fournissez des journaux de pod ou si la sortie de kubectl get events ?

Robusta collecte déjà ces données et les joint aux alertes Prometheus, elles devraient donc être faciles à ajouter.

Les PR sont les bienvenus !

Partagez vos résultats les plus drôles et suggérez de nouvelles fonctionnalités sur notre Slack.

N'hésitez pas à utiliser l'image suivante ou à créer la vôtre.

Natan teste ChatGPT sur les alertes Kubernetes de production

Natan Yellin et Sid Palas examinent le code sur YouTube – la partie pertinente commence à 38:54

Techniquement, ce projet n'utilise pas ChatGPT. Il utilise le modèle text-davinci-003 qui est un frère de ChatGPT basé sur GPT3.5. Étant donné que la plupart des gens connaissent ChatGPT, mais pas text-davinci-003 ou GPT3.5, nous avons décidé de conserver le nom « ChatGPT bot » malgré l'inexactitude technique. ↩