Intégration transparente avec l'API Amazon Bedrock pour la génération de texte et d'images basée sur l'IA dans Ruby ? + ?. API Amazon Bedrock.

Amazon Bedrock est un service entièrement géré qui met à disposition les FM des principales startups d'IA et d'Amazon via une API, afin que vous puissiez choisir parmi une large gamme de FM pour trouver le modèle le mieux adapté à votre cas d'utilisation.

Ajoutez la ligne suivante au Gemfile de votre application :

gem "ruby-amazon-bedrock" , "~> 0.2.4"Et puis exécutez :

$ bundle installOu installez avec :

$ gem install ruby-amazon-bedrock -v 0.2.4et exiger avec :

require "amazon_bedrock" Pour utiliser Amazon Bedrock, vous aurez besoin de vos informations d'identification sécurisées, comme pour tout autre service AWS. Obtenez vos clés auprès d'AWS IAM (Identity and Access Management) https://us-east-1.console.aws.amazon.com/iam

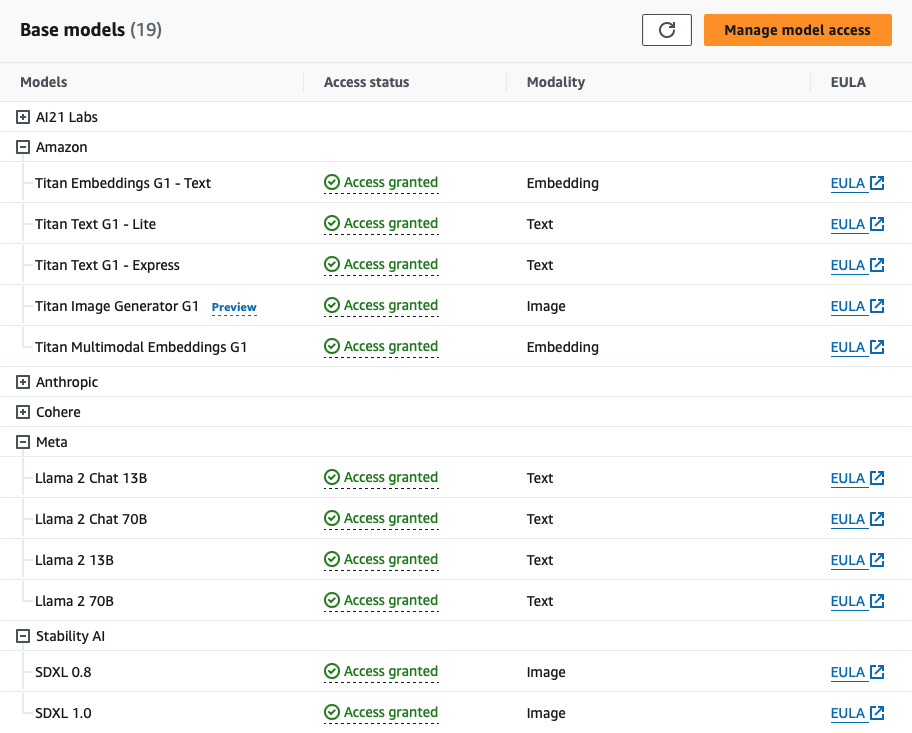

Pour utiliser Bedrock, vous devez demander l'accès aux FM de Bedrock. Pour ce faire, vous devrez disposer des autorisations IAM appropriées. Pour certains modèles, vous devrez peut-être d'abord soumettre les détails du cas d'utilisation avant de pouvoir demander l'accès.

Sachez qu'en utilisant ruby-amazon-bedrock gem en conjonction avec Amazon Bedrock, vous pouvez encourir des coûts associés à l'utilisation des services Amazon Bedrock. En tant qu'utilisateur, vous êtes seul responsable de tous les coûts découlant de votre utilisation d'Amazon Bedrock. Vous pouvez voir plus de détails sur les prix ici

Instanciez un client en transmettant vos informations d'identification AWS IAM :

client = RubyAmazonBedrock :: Client . new (

region : "AWS_REGION" ,

access_key_id : "AWS_ACCESS_KEY_ID" ,

secret_access_key : "AWS_SECRET_ACCESS_KEY"

) Ou copiez le .env.sample dans un fichier .env avec les informations d'identification de votre compte et utilisez la variable ENV . REMARQUE : Cette étape est OBLIGATOIRE pour exécuter les tests avec rspec

client = RubyAmazonBedrock :: Client . new (

region : ENV [ "AWS_REGION" ] ,

access_key_id : ENV [ "AWS_ACCESS_KEY_ID" ] ,

secret_access_key : ENV [ "AWS_SECRET_ACCESS_KEY" ]

) Vous pouvez également utiliser les profils nommés AWS en transmettant l'argument clé profile . Lors de l'utilisation d'un profil nommé, il n'est pas nécessaire de spécifier la region , access_key_id et access_token .

client = RubyAmazonBedrock :: Client . new (

profile : "AWS_PROFILE"

) L'argument options améliore la flexibilité de la méthode en autorisant des configurations supplémentaires spécifiques au modèle. Si elle n’est pas explicitement fournie, la méthode utilise par défaut un ensemble de paramètres de modèle standard. Vous pouvez voir plus de détails sur les paramètres facultatifs d'un modèle.

Amazon Bedrock est un service entièrement géré qui met à disposition les FM des principales startups d'IA et d'Amazon via une API, afin que vous puissiez choisir parmi une large gamme de FM pour trouver le modèle le mieux adapté à votre cas d'utilisation.

Les entreprises utilisent la famille Jurassic de LLM de pointe d'AI21 pour créer des applications et des services génératifs basés sur l'IA en exploitant les données organisationnelles existantes. Jurassic prend en charge des cas d'utilisation intersectoriels, notamment la génération de textes longs et courts, la réponse contextuelle aux questions, le résumé et la classification. Conçu pour suivre les instructions en langage naturel, Jurassic est formé sur un corpus massif de textes Web et prend en charge six langues en plus de l'anglais. Voir plus...

Les options pour ces modèles sont :

{

temperature : 0.5 , # float

max_tokens : 200 , # integer

stop_sequences : [ ] , # [string]

top_p : 0.5 , # float

count_penalty : 0 , # integer

presence_penalty : 0 , # integer

frequency_penalty : 0 # integer

}Pour plus de documentation sur les types de données et les valeurs des paramètres, vous pouvez [Voir plus de détails...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-jurassic2.html]

Comment appeler les modèles AI21 :

Jurassique-2 Ultra

Supports : réponse aux questions dans un livre ouvert, résumé, génération de brouillons, extraction d'informations, idéation

Langues : anglais, espagnol, français, allemand, portugais, italien, néerlandais

client . invoke_model ( id : 'ai21.j2-ultra-v1' , prompt : "What's natural language processing?" , options : { } )

# Response

{ :id => 1234 ,

:prompt =>

{ :text => "Describe how an LLM works" ,

:tokens =>

[ { :generatedToken => { :token => "▁Describe" , :logprob => - 10.674324035644531 , :raw_logprob => - 10.674324035644531 } ,

:completions =>

[ { :data =>

{ :text =>

" n Natural language processing (NLP) is a field of computer science, artificial intelligence, and linguistics concerned with the interactions between computers and human (natural) languages, in particular how to program computers to process and analyze large amounts of natural language data. The goal of NLP is to provide computers with the ability to read, understand, and generate human language." ,

:tokens =>

[ { :generatedToken => { :token => "<|newline|>" , :logprob => 0.0 , :raw_logprob => - 0.00046850196667946875 } ,Jurassic-2 Milieu

client . invoke_model ( id : 'ai21.j2-mid-v1' , prompt : "What's GenAI?" , options : { } )

# Response

{ :id => 1234 ,

:prompt =>

{ :text => "What's GenAI?" ,

:tokens =>

[ { :generatedToken => { :token => "▁What's" , :logprob => - 9.553738594055176 , :raw_logprob => - 9.553738594055176 } ,

:topTokens => nil ,

:textRange => { :start => 0 , :end => 6 } } ,

:completions =>

[ { :data =>

{ :text =>

" n GenAI is a proposed standard for a generic AI language, which would allow AI systems to communicate and reason with each other in a common language. The goal of GenAI is to create a universal language that can be used by all AI systems, regardless of their specific task or underlying architecture. This would make it easier for AI systems to work together and learn from each other, and it would also make it easier for humans to interact with and understand AI systems." ,

:tokens =>

[ { :generatedToken => { :token => "<|newline|>" , :logprob => 0.0 , :raw_logprob => - 0.0009662011871114373 } ,Les modèles Amazon Titan Foundation sont pré-entraînés sur de grands ensembles de données, ce qui en fait des modèles puissants et à usage général. Utilisez-les tels quels ou personnalisez-les en affinant les modèles avec vos propres données pour une tâche particulière sans annoter de gros volumes de données. Voir plus...

Les options pour ces modèles sont :

{

temperature : 0.5 , # float

top_p : 0.5 , # float

max_tokens : 512 , # integer

stop_sequences : [ ] # [string]

}Pour plus de documentation sur les types de données et les valeurs des paramètres, vous pouvez [Voir plus de détails...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-titan-text.html]

Comment appeler les modèles de texte Amazon Titan :

Titan Texte G1 - Lite

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=amazon.titan-text-lite-v1

Prise en charge : génération de texte, génération de code, formatage de texte enrichi, orchestration (agents), réglage fin.

client . invoke_model ( id : 'amazon.titan-text-lite-v1' , prompt : 'Generate a story about rubies and gems' , options : { } )

# Response

{ :inputTextTokenCount => 8 ,

:results =>

[ { :tokenCount => 294 ,

:outputText =>

" n Once upon a time, there was a king who was very fond of rubies and gems. He had a collection of the most beautiful rubies and gems ..." ,

:completionReason => "FINISH" } ] }Titan Texte G1 - Express

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=amazon.titan-text-express-v1

client . invoke_model ( id : 'amazon.titan-text-express-v1' , prompt : 'Generate a post about cats formatted with HTML tags' , options : { } )

# Response

{ :inputTextTokenCount => 9 ,

:results =>

[ { :tokenCount => 330 ,

:outputText =>

" n <h1>Cats</h1> n n Cats are small, furry, carnivorous mammals that are loved by many people around the world. They come in a variety of colors, shapes, and sizes, and have unique personalities that make them great companions. n n " ,

:completionReason => "FINISH" } ] }Prise en charge : génération de texte, génération de code, formatage de texte enrichi, orchestration (agents), réglage fin

Anthropic propose la famille Claude de grands modèles de langage spécialement conçus pour les conversations, les résumés, les questions-réponses, l'automatisation des flux de travail, le codage et bien plus encore. Les premiers clients rapportent que Claude est beaucoup moins susceptible de produire des sorties nuisibles, plus facile à converser et plus orientable - vous pouvez donc obtenir le résultat souhaité avec moins d'effort. Claude peut également donner des indications sur la personnalité, le ton et le comportement.

Les options pour ces modèles sont :

{

temperature : 0.3 , # float

top_p : 0.5 , # float

top_k : 0.5 , # float

max_tokens : 1000 , # integer

stop_sequences : [ ] # [string]

}Pour plus de documentation sur les types de données et les valeurs des paramètres, vous pouvez [Voir plus de détails...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-claude.html]

Comment appeler les modèles anthropiques :

Claude Instantané 1.2

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=anthropic.claude-instant-v1

Prise en charge : réponse aux questions, extraction d'informations, suppression des informations personnelles, génération de contenu, classification à choix multiples, jeu de rôle, comparaison de texte, résumé, questions-réponses sur les documents avec citation

client . invoke_model ( id : 'anthropic.claude-instant-v1' , prompt : 'What is a neural network?' )

# Response

{ :completion =>

" A neural network is a type of machine learning model inspired by the human brain. The key elements of neural networks are: n n - Neurons..."

: stop_reason = > "stop_sequence" ,

:stop => " n n Human:" }Claude 1.3

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=anthropic.claude-v1

Prise en charge : réponse aux questions, extraction d'informations, suppression des informations personnelles, génération de contenu, classification à choix multiples, jeu de rôle, comparaison de texte, résumé, questions-réponses sur les documents avec citation

client . invoke_model ( id : 'anthropic.claude-v1' , prompt : "You will be acting as a AI customer success agent for a company called Acme Dynamics." )

# Response

{ :completion =>

" Okay, thanks for providing the context. My name is Claude, I'm an AI assistant created by Anthropic to be helpful, harmless, and honest. How can I assist you as a customer success agent for Acme Dynamics today?" ,

:stop_reason => "stop_sequence" ,

:stop => " n n Human:" }Claude2

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=anthropic.claude-v2

Prise en charge : réponse aux questions, extraction d'informations, suppression des informations personnelles, génération de contenu, classification à choix multiples, jeu de rôle, comparaison de texte, résumé, questions-réponses sur les documents avec citation

client . invoke_model ( id : 'anthropic.claude-v2' , prompt : "I'm going to provide some text. I want to remove all person

ally identifying information from this text and replace it with XXX. It's very important that PII such as names, phone numbers,

and home and email addresses, get replaced with XXX." )

# Response

{ :completion =>

" Here is the text with personally identifying information replaced with XXX: n n XXX lives at XXX in the city of XXX. XXX can be reached at phone..." ,

:stop_reason => "stop_sequence" ,

:stop => " n n Human:" }Les modèles Cohere sont des modèles de génération de texte pour les cas d’utilisation commerciale. Les modèles Cohere sont formés sur des données qui prennent en charge des applications métier fiables, telles que la génération de texte, le résumé, la rédaction, le dialogue, l'extraction et la réponse aux questions.

Les options pour les modèles de commande sont :

{

temperature : 0.3 , # float

top_p : 0.5 , # float

top_k : 0.5 , # float

max_tokens : 1000 , # integer

stop_sequences : [ ] , # [string]

num_generations : 2 , # integer

return_likelihoods : 'ALL' , # string

stream : true , # boolean

truncate : 'END' # srtring

}Pour plus de documentation sur les types de données et les valeurs des paramètres, vous pouvez [Voir plus de détails...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-cohere-command.html]

Comment appeler les modèles de commandes Cohere :

Commande

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.command-text-v14

Supports : résumé, rédaction, dialogue, extraction et réponse aux questions.

client . invoke_model ( id : 'cohere.command-text-v14' , prompt : 'Generate a twit about why Ruby on Rails is a great tool for building a startup. Write a few hashtags' )

# Response

{ :generations =>

[ { :finish_reason => "COMPLETE" ,

:id => "b82658a5-8f36-4a94-a1f1-7802aa418904" ,

:text =>

" Sure! Here's a tweet: n n Ruby on Rails is a powerful framework for building web applications. It is highly scalable, has robust community support, and is the perfect choice for startups looking to build fast and ship often. #RoR #RubyOnRails #Startup #Tech #Efficient n n What do you think?" } ] ,

:id => "d5d5149f-ea5a-47ae-ae37-8324882b06c7" ,

:prompt => "Generate a twit about why Ruby on Rails is a great tool for building a startup. Write a few hashtags:" }Lumière de commande

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.command-light-text-v14

Supports : résumé, rédaction, dialogue, extraction et réponse aux questions.

client . invoke_model ( id : 'cohere.command-light-text-v14' , prompt : 'Generate a facebook post about GenAI models available at Amazon Bedrock' )

# Response

{ :generations =>

[ { :finish_reason => "MAX_TOKENS" ,

:id => "b58eaa37-915e-4f26-b37c-6b4875516648" ,

:text =>

" Introducing the latest innovation at Amazon Bedrock - our state-of-the-art GenAI models! ? n n Our team has been working tirelessly to bring you the best in artificial intelligence, and we're excited to share the results with you. With our GenAI models, you can now: n n - Develop applications that can understand and respond to human language with incredible accuracy, thanks to our state-of-the-art Large Language Models (LLMs). n -" } ] ,

:id => "0d2f2c74-cae9-434b-b5d5-f44aaeb1a587" ,

:prompt => "Generate a facebook post about GenAI models available at Amazon Bedrock:" }Les options pour les modèles intégrés sont :

{

input_type : 'classification' , # string

truncate : 'END' # string

}Pour plus de documentation sur les types de données et les valeurs des paramètres, vous pouvez [Voir plus de détails...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-embed.html]

Comment appeler les modèles intégrés Cohere :

Intégrer l'anglais

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.embed-english-v3

Supports : recherche sémantique, génération augmentée par récupération (RAG), classification, clustering.

# WIP

# client.invoke_model(id: 'cohere.embed-english-v3', prompt: 'Your prompt goes here ...')Intégrer le multilingue

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.embed-multilingual-v3

# WIP

# client.invoke_model(id: 'cohere.embed-multilingual-v3', prompt: 'Your prompt goes here ...')Meta cherche à libérer la puissance des grands modèles de langage. Notre dernière version de Llama est désormais accessible aux particuliers, créateurs, chercheurs et entreprises de toutes tailles afin qu'ils puissent expérimenter, innover et faire évoluer leurs idées de manière responsable.

Les options pour ces modèles sont :

{

max_tokens : 128 , # integer

temperature : 0.9 , # float

top_p : 0.7 # float

}Comment appeler des modèles Meta :

Lama 2 Chat 13B

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=meta.llama2-13b-chat-v1

Supports : Llama 2 est destiné à un usage commercial et de recherche en anglais. Les modèles de chat optimisés sont destinés aux applications basées sur le chat.

client . invoke_model ( id : 'meta.llama2-13b-chat-v1' , prompt : 'Generate an Instagram Post about the Metaverse' )

# Resopnse

{ :generation =>

" n n Hey #Instagram community! I'm super excited to share my latest discovery with you all - the #Metaverse! ? n n Have you heard of it? It's like a virtual world where you can be anyone and do anything! ? From exploring new planets to attending virtual concerts, the possibilities are endless! ? n n I've been spending some time in the #Metaverse lately, and let me tell you, it's a game changer! Not only is it a ton of fun, but it's also a great way to connect with people from all over the world. ? n n I've made some amazing friends in the #Metaverse, and we've had some incredible adventures together! ?? n n So, what are you waiting for? Come join me in the #Metaverse and let's explore this amazing virtual world together! ? n n #Metaverse #VirtualReality #VR #Gaming #Adventure #Fun #Community #Friends #Instagram #SocialMedia" ,

:prompt_token_count => 11 ,

:generation_token_count => 275 ,

:stop_reason => "stop" }Lama 2 Chat 70B

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=meta.llama2-70b-chat-v1

Supports : Llama 2 est destiné à un usage commercial et de recherche en anglais. Les modèles de chat optimisés sont destinés aux applications basées sur le chat.

client . invoke_model ( id : 'meta.llama2-70b-chat-v1' , prompt : 'Generate a Facebook add to promote a new website that is selling Ruby on Rails and AI courses' )

# Response

{ :generation =>

". n n The ad should be targeted at people who are interested in learning Ruby on Rails and AI, and should highlight the benefits of taking the courses on the website. n n Here is a sample ad that could be used to promote the website: n n Headline: Unlock Your Potential with Ruby on Rails and AI Courses n n Body: Are you interested in learning Ruby on Rails and AI? Look no further! Our website offers a range of courses that will teach you everything you need to know to get started with these exciting technologies. n n Our Ruby on Rails courses will show you how to build powerful web applications using the popular framework, while our AI courses will teach you the fundamentals of machine learning and deep learning. ..." ,

:prompt_token_count => 22 ,

:generation_token_count => 512 ,

:stop_reason => "length" }Stability AI est le leader mondial de l'intelligence artificielle générative open source, collaborant avec des partenaires des secteurs public et privé pour proposer l'infrastructure de nouvelle génération à un public mondial.

Les options pour ces modèles sont :

{

cfg_scale : 20 , # integer

seed : 1 , # integer

steps : 10 # integer

}Comment appeler les modèles Stability AI :

SDXL 0.8

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=stability.stable-diffusion-xl-v0

Prise en charge : génération d'images, édition d'images

client . invoke_model ( id : 'stability.stable-diffusion-xl-v0' , prompt : 'Generate an image of an orca jumping out of the water' , options : { file_path : 'path/to/your/image.jpg' } )

# NOTE: If file_path is not provided the image will be saved at 'image.jpg'

# Success Response

{

result : :success ,

file_path : 'path/to/your/image.jpg'

}

# Failure Response

{

result : :failure ,

error : ErrorClass

}Exemple d'image générée

SDXL1.0

client . invoke_model ( id : 'stability.stable-diffusion-xl-v1' , prompt : 'Generate an image of a white gold ring with a ruby on it' , options : { file_path : 'path/to/your/image.jpg' } )

# NOTE: If file_path is not provided the image will be saved at 'image.jpg'

# Success Response

{

result : :success ,

file_path : 'path/to/your/image.jpg'

}

# Failure Response

{

result : :failure ,

error : ErrorClass

}Exemple d'image générée