nGPT pytorch

0.2.7

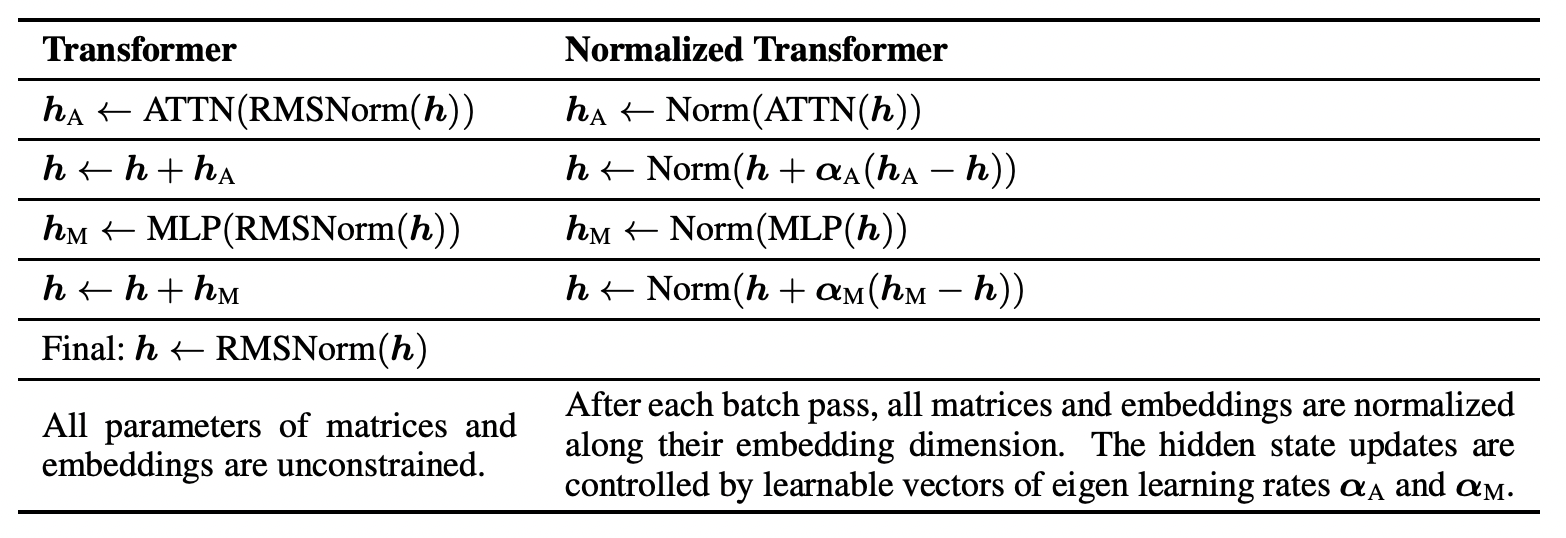

Implémentation rapide de nGPT, apprentissage entièrement sur l'hypersphère, de NvidiaAI. La question est de savoir s’il y a une perte d’expressivité qu’ils ont balayée sous le tapis, mais je la prendrai en toute bonne foi.

Ce type de réseau doit également être étudié dans un contexte d’apprentissage continu et de perte de plasticité.

L'adaptation aux transformateurs de vision est là

$ pip install nGPT-pytorch import torch

from nGPT_pytorch import nGPT

model = nGPT (

num_tokens = 256 ,

dim = 512 ,

depth = 4 ,

attn_norm_qk = True

)

x = torch . randint ( 0 , 256 , ( 2 , 2048 ))

loss = model ( x , return_loss = True )

loss . backward ()

logits = model ( x ) # (2, 2048, 256) Frwik8

$ python train.py @inproceedings { Loshchilov2024nGPTNT ,

title = { nGPT: Normalized Transformer with Representation Learning on the Hypersphere } ,

author = { Ilya Loshchilov and Cheng-Ping Hsieh and Simeng Sun and Boris Ginsburg } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273026160 }

} @article { Luo2017CosineNU ,

title = { Cosine Normalization: Using Cosine Similarity Instead of Dot Product in Neural Networks } ,

author = { Chunjie Luo and Jianfeng Zhan and Lei Wang and Qiang Yang } ,

journal = { ArXiv } ,

year = { 2017 } ,

volume = { abs/1702.05870 } ,

url = { https://api.semanticscholar.org/CorpusID:1505432 }

} @inproceedings { Zhou2024ValueRL ,

title = { Value Residual Learning For Alleviating Attention Concentration In Transformers } ,

author = { Zhanchao Zhou and Tianyi Wu and Zhiyun Jiang and Zhenzhong Lan } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273532030 }

}