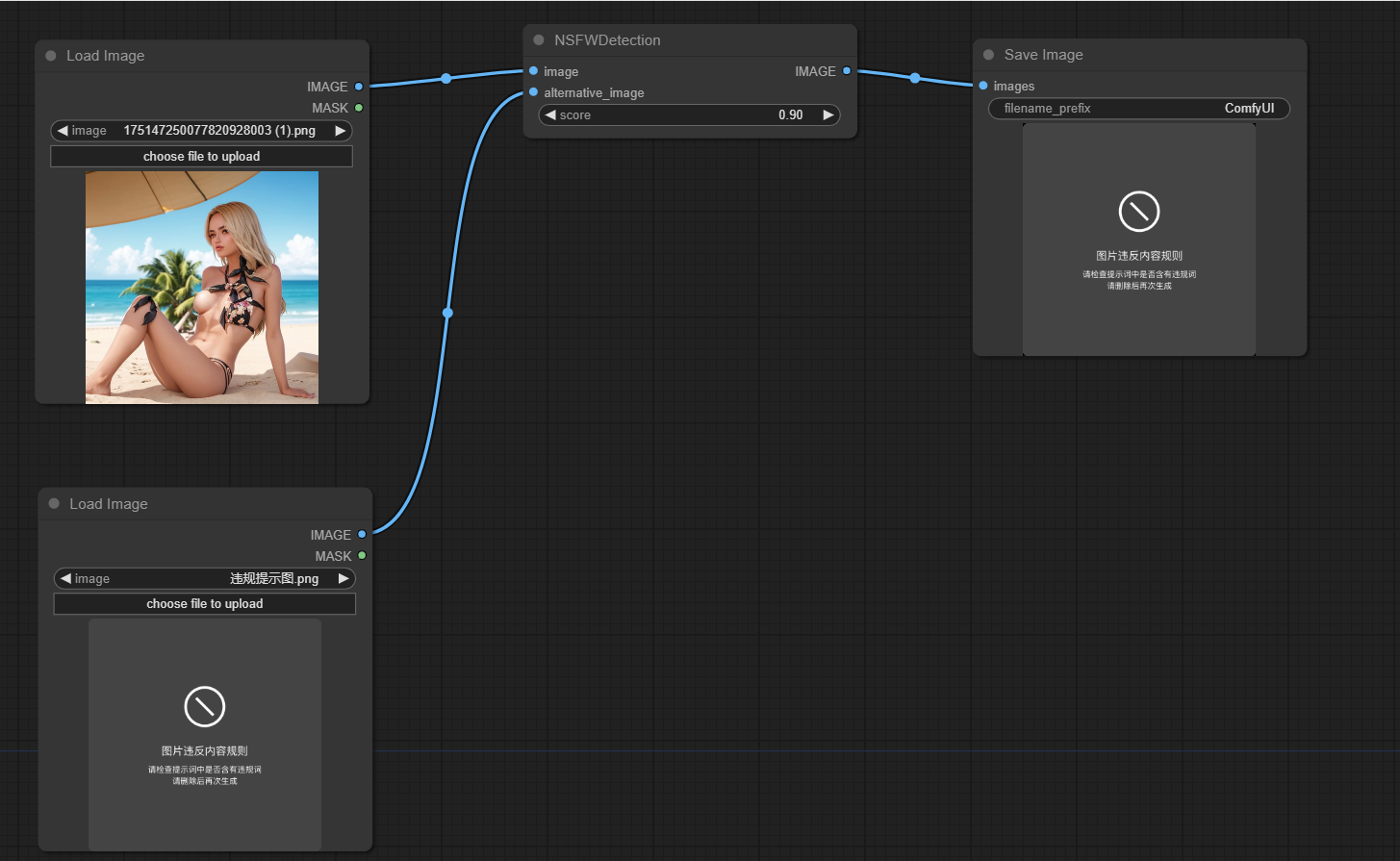

Ce projet est conçu pour détecter si les images générées par Comfyui ne sont pas sûres pour le travail (NSFW). Il utilise un modèle d'apprentissage automatique pour classer les images comme sûres ou non sûres pour le travail. Si une image est classée comme NSFW, une image alternative est renvoyée.

Clone ce repo dans Custom_Nodes Directory of Comfyui Location

Exécuter Pip Install -r exigences.txt

La principale fonctionnalité du projet est encapsulée dans la classe NSFWDetection dans le fichier node.py Cette classe a une méthode run qui prend trois paramètres:

image : l'image à classer.score : le score de seuil pour classer une image comme NSFW.alternative_image : l'image à retourner si l'image d'entrée est classée comme NSFW.

https://github.com/trumanwong/comfyui-nsfw-dection/blob/main/workflow.json

Les contributions sont les bienvenues. Veuillez soumettre une demande de traction si vous avez des améliorations ou des corrections de bogues.

Ce projet est concédé sous licence de la licence du MIT.