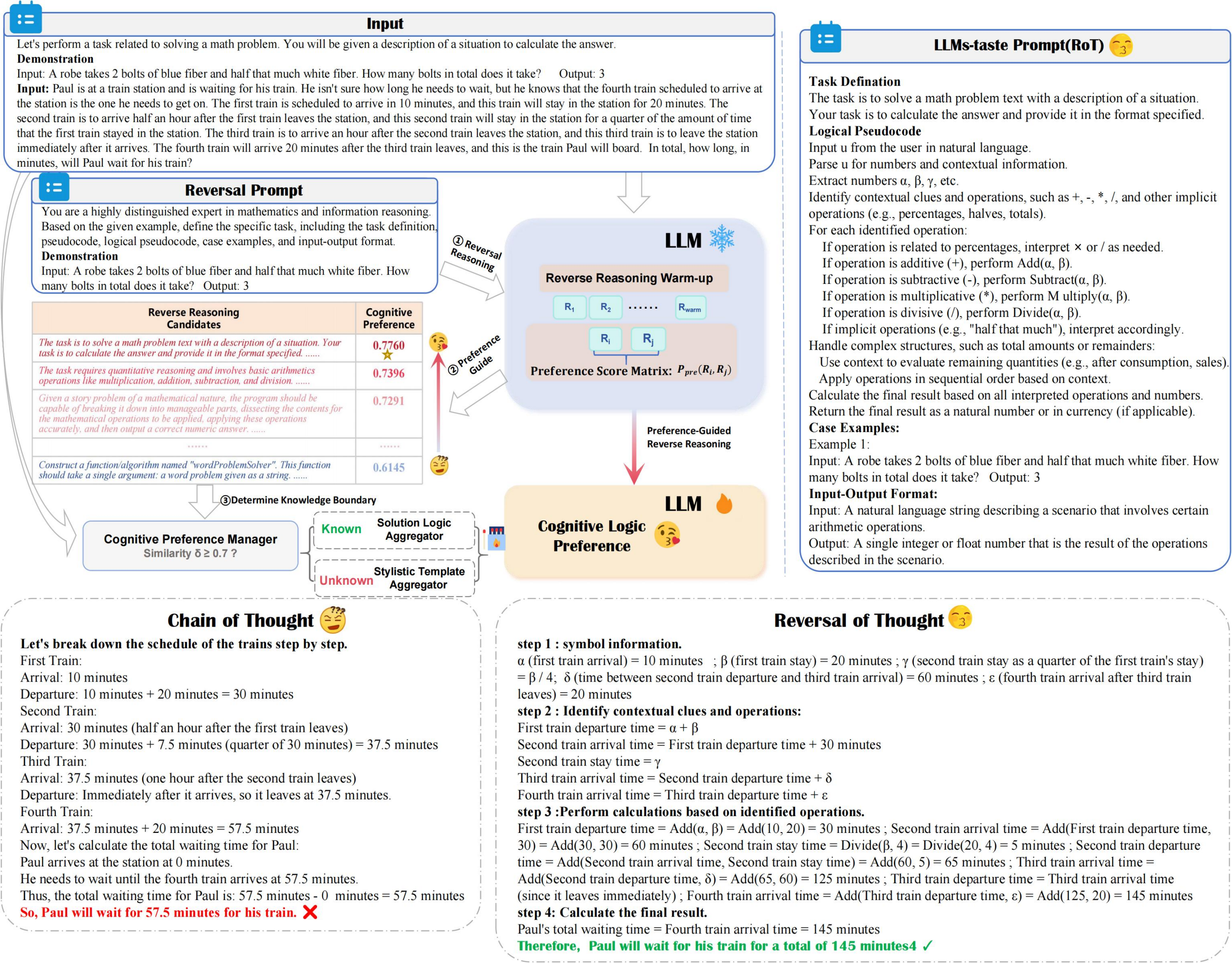

La pourriture améliore la précision et l'efficacité du raisonnement tout en minimisant les coûts de calcul, en tirant parti du raisonnement inversé guidé par les préférences et d'un gestionnaire de préférences cognitives pour explorer de manière optimale le raisonnement LLM avec les préférences cognitives.

??? inversion_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 ) Améliorer les invites préfabriquées par LLM pour des solutions de tâche

Raffine invite à s'aligner sur les stratégies préfères de LLM, optimisant l'efficacité de résolution de tâches.

Potentiel pour créer divers ensembles de données QA

Génère des paires de questions-réponses variées pour améliorer la diversité des ensembles de données.

Si vous trouvez notre travail utile pour vos recherches, veuillez citer notre article comme suit:

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}