【2024.06.13】 Prise en charge du modèle MiniCPM-Llama3-V-2_5 , modifiez la variable d'environnement MODEL_NAME=minicpm-v PROMPT_NAME=minicpm-v DTYPE=bfloat16

[2024.06.12] Soutenez le modèle GLM-4V , modifiez la variable d'environnement MODEL_NAME=glm-4v PROMPT_NAME=glm-4v DTYPE=bfloat16 , voir GLM4V pour les exemples de test.

【2024.06.08】 Le modèle QWEN2 a été pris en charge, modifiez la variable d'environnement MODEL_NAME=qwen2 PROMPT_NAME=qwen2

【2024.06.05】 Soutenez le modèle GLM4 et modifiez la variable d'environnement MODEL_NAME=chatglm4 PROMPT_NAME=chatglm4

【2024.04.18】 Code Qwen , SQL Q&R Demo

【2024.04.16】 Prise en charge du modèle de réorganisation Rerank , méthode d'utilisation

【 QWEN1.5 】 La variable d'environnement MODEL_NAME=qwen2 PROMPT_NAME=qwen2

Pour plus de nouvelles et d'histoire, veuillez aller ici

Contenu principal de ce projet

Ce projet met en œuvre une interface backend unifiée pour le raisonnement des grands modèles open source, ce qui est conforme à la réponse d' OpenAI et a les caractéristiques suivantes:

Appelez divers modèles open source sous la forme d' OpenAI ChatGPT API

? ️ prend en charge la réponse en streaming pour atteindre l'effet d'imprimante

Implémentez le modèle d'intégration de texte pour fournir une prise en charge des questions de connaissances de documents Q&R

? ️ prend en charge diverses fonctions de langchain , un outil de développement de modèle de langue à grande échelle

chatgpt

Prend en charge le chargement de modèles lora auto-formés

⚡ Prise en charge de l'accélération et du traitement de l'inférence VLLM des demandes simultanées

| chapitre | décrire |

|---|---|

| Modèle? ?? Support | Modèles open source pris en charge par ce projet et des informations brèves |

| ? Démarrer la méthode | Commandes de configuration et de démarrage de l'environnement pour les modèles de démarrage |

| Méthode de démarrage ⚡vllm | Commandes de configuration et de démarrage de l'environnement pour le démarrage des modèles à l'aide de vLLM |

| Méthode d'appel | Comment appeler après avoir commencé le modèle |

| ❓faq | Réponses à certaines FAQ |

Modèle de langue

| Modèle | Taille du paramètre du modèle |

|---|---|

| Baichuan | 7b / 13b |

| Chatglm | 6B |

| En profondeur | 7b / 16b / 67b / 236b |

| Interne | 7b / 20b |

| Lama | 7b / 13b / 33b / 65b |

| Lama-2 | 7b / 13b / 70b |

| Lama-3 | 8b / 70b |

| Qwen | 1.8b / 7b / 14b / 72b |

| Qwen1.5 | 0,5b / 1,8b / 4b / 7b / 14b / 32b / 72b / 110b |

| Qwen2 | 0,5b / 1,5b / 7b / 57b / 72b |

| Yi (1/1,5) | 6b / 9b / 34b |

Pour plus de détails, veuillez vous référer à la méthode de démarrage VLLM et à la méthode de démarrage des transformateurs.

Modèle d'intégration

| Modèle | Dimension | Lien de poids |

|---|---|---|

| BGE-LARG-ZH | 1024 | BGE-LARG-ZH |

| m3e-grand | 1024 | Moka-ai / m3e-gard |

| text2vec-chinois | 1024 | text2vec-chinois |

| BCE-Embedding-Base_V1 (recommandé) | 768 | BCE-Embedding-Base_V1 |

OPENAI_API_KEY : remplissez simplement une chaîne ici

OPENAI_API_BASE : l'adresse d'interface du démarrage du backend, tel que: http: //192.168.0.xx: 80 / v1

cd streamlit-demo

pip install -r requirements.txt

streamlit run streamlit_app.py

from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "你好" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion )

# 你好!我是人工智能助手 ChatGLM3-6B,很高兴见到你,欢迎问我任何问题。

# stream = client.chat.completions.create(

# messages=[

# {

# "role": "user",

# "content": "感冒了怎么办",

# }

# ],

# model="gpt-3.5-turbo",

# stream=True,

# )

# for part in stream:

# print(part.choices[0].delta.content or "", end="", flush=True) from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

completion = client . completions . create (

model = "gpt-3.5-turbo" ,

prompt = "你好" ,

)

print ( completion )

# 你好!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。 from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# compute the embedding of the text

embedding = client . embeddings . create (

input = "你好" ,

model = "text-embedding-ada-002"

)

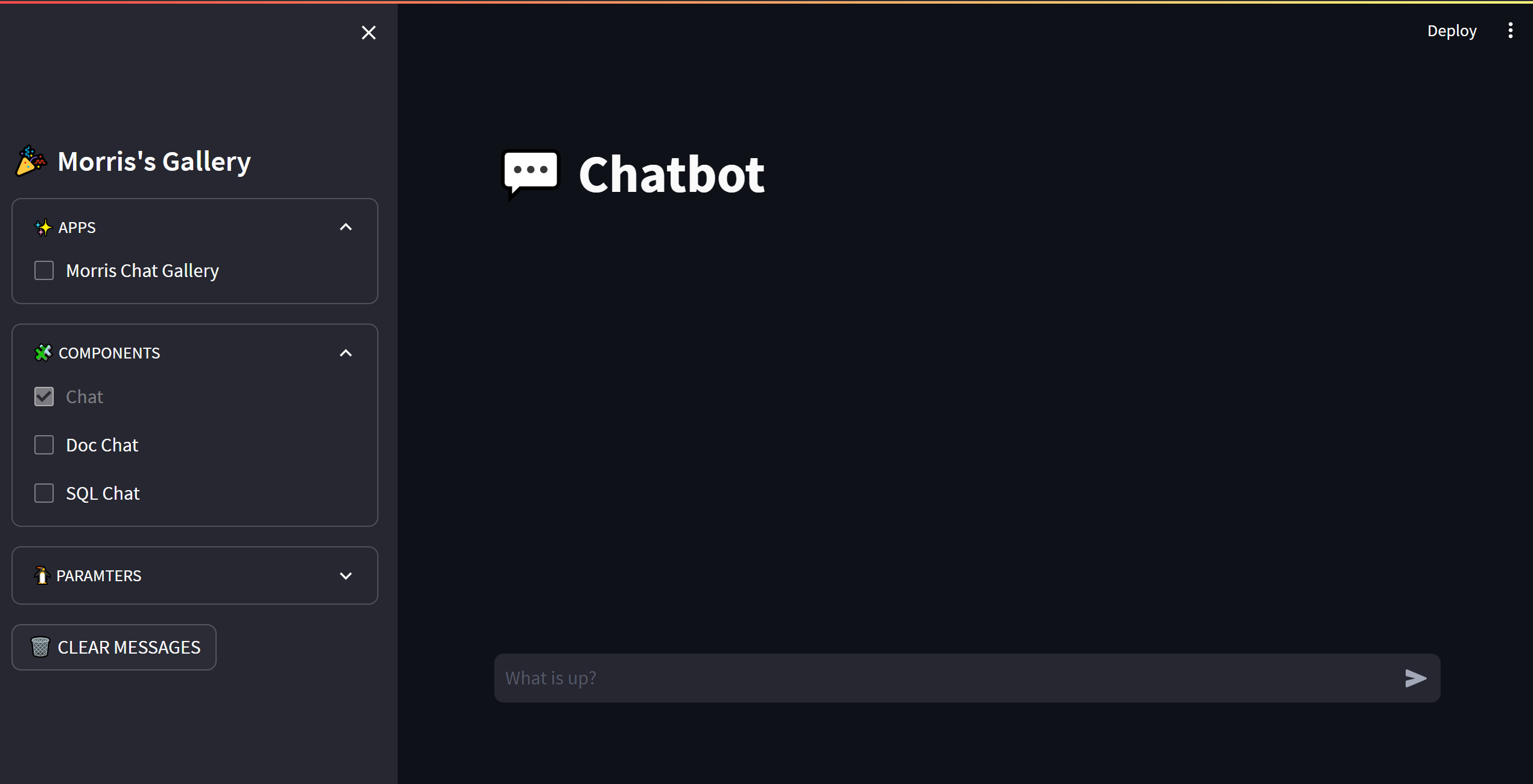

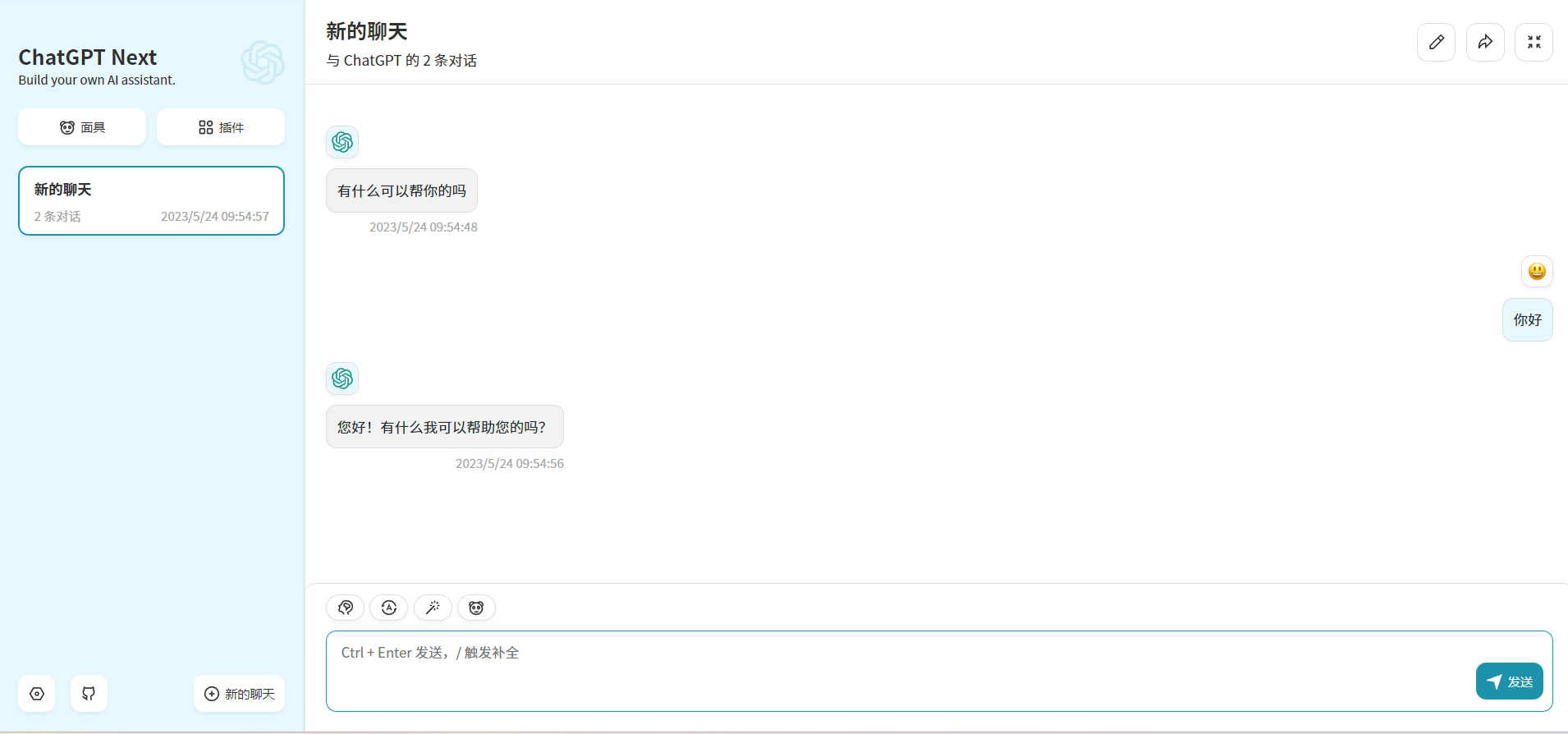

print ( embedding ) En modifiant OPENAI_API_BASE , la plupart des applications chatgpt et des projets frontaux peuvent être connectés de manière transparente!

docker run -d -p 3000:3000

-e OPENAI_API_KEY= " sk-xxxx "

-e BASE_URL= " http://192.168.0.xx:80 "

yidadaa/chatgpt-next-web

# 在docker-compose.yml中的api和worker服务中添加以下环境变量

OPENAI_API_BASE: http://192.168.0.xx:80/v1

DISABLE_PROVIDER_CONFIG_VALIDATION: ' true '

Ce projet est concédé sous licence Apache 2.0 , consultez le fichier de licence pour plus d'informations.

ChatGlm: un modèle de langue de dialogue bilingue ouverte

Bloom: un modèle de langue multilingue à accès à accès ouvert 176B-paramètre

LLAMA: modèles de langue de base ouverts et efficaces

Encodage de texte efficace et efficace pour le lama chinois et l'alpaga

Phoenix: démocratiser le chatpt à travers les langues

MOSS: un modèle de langage conversationnel au plugin open d'origine

FastChat: une plate-forme ouverte pour la formation, le service et l'évaluation des chatbots basés sur un modèle de grande langue

Langchain: Construire des applications avec LLMS via la composabilité

Chuanhuchatgpt