Générez des jeux et des programmes à l'aide d'agents OpenAI. Construit au-dessus de Microsoft Autogen.

️ Travail en cours

Le code actuel fonctionne mais:

- Il y aura et il y aura des changements de rupture:

- Vérifiez toujours que votre fichier caché

.env.jsonccorrespond à la dernière structureenv.sample.jsonc.- Mettez toujours à jour vos dépendances via

poetry install.- Beaucoup de choses doivent être optimisées afin de réduire considérablement l'utilisation des jetons: mise en cache, processus pas à pas, division de conversation, meilleures invites.

- Le code a besoin de nettoyage.

- Microsoft Autogen est encore en début de stade et contient quelques bugs.

- Beaucoup de choses à code dur pourraient être personnalisables via des fichiers de configuration.

- Je ne me concentrerai qu'au début sur quelques langages de programmation.

Il y a des projets incroyables qui font des choses similaires, mais j'espère trouver un moyen de résoudre la génération ambitieuse de programmes.

Vous avez besoin d'une clé API OpenAI ou d'une clé API Azure OpenAI.

Ne comptez pas sur GPT-3.5 , que ce soit turbo ou Standard, pour plus que des programmes "échantillon". Si vous visez des applications plus complexes, GPT-4 est un must, de préférence même GPT-4-32k .

L'utilisation de l'API OpenAI peut épuiser rapidement votre limite de jeton. Pour des projets plus étendus, l'API Azure Openai est recommandée.

Soyez conscient des coûts si vous avez des objectifs ambitieux! Surveillez toujours l'utilisation des jetons et ce que font vos agents. Bien que l'IA puisse être un outil puissant, il n'est pas nécessairement moins cher que d'embaucher de vrais développeurs - encore ?.

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc Modifiez votre env.json pour ajouter vos clés API et personnalisez votre installation.

Juste:

make run OADS générera automatiquement le code source du programme dans le répertoire ./project .

Vous pouvez le nettoyer via:

make cleanImportant: les fonctions ne fonctionneront pas.

D'après ce que j'ai testé, Autogen semble fonctionner avec n'importe quel LLM open source pris en charge par l'interface utilisateur Web de génération de texte.

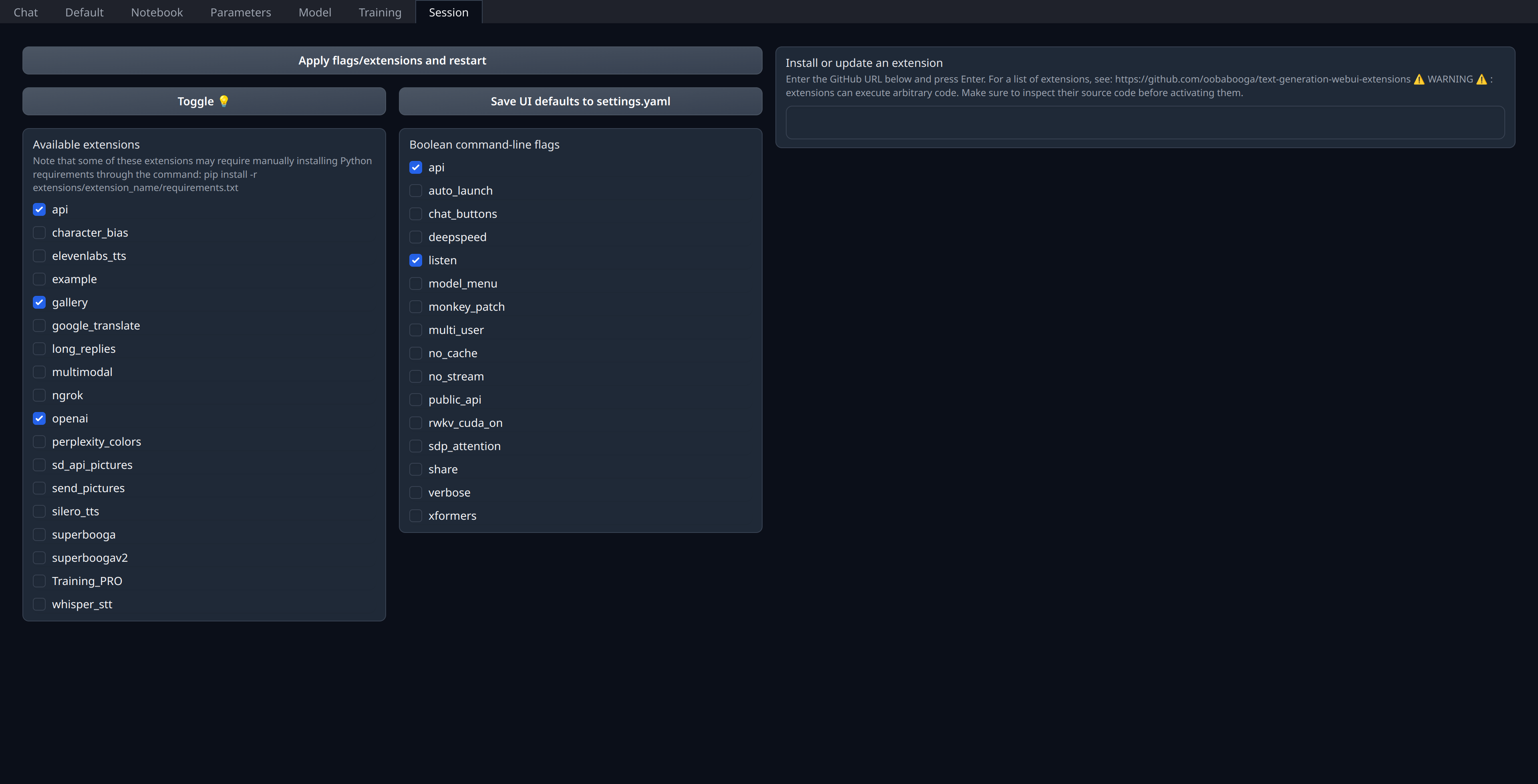

Il vous suffit d'activer l'extension openai dans l'onglet "Session" de l'interface utilisateur Web:

Assurez-vous d'avoir votre port 5001 ouvert ou BOIDE s'il s'agit d'un serveur distant, car c'est là que l'API de type OpenAI sera exposée.

Je déploie personnellement mes modèles actuels sur Runpod (non affiliés) et j'utilise thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest image même si je pense que cela semble un peu dépassé concernant Llama.cpp & Co.

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,