Récemment, la tourmente des projets OpenAI et sora a inquiété le monde extérieur quant à l'industrie animée de la vidéo IA.

Fin septembre, Mira Murati, directrice de la technologie d'OpenAI, et Barrett Zoff, vice-président de la recherche, qui ont joué un rôle important dans le développement des modèles o1, GPT-4o et GPT-4v, Barret Zoph et chef. le chercheur Bob McGrew a également annoncé leur départ.

Le 4 octobre, Tim Brooks, chef du projet Sora, a officiellement annoncé sa démission sur la plateforme sociale X et a rejoint Google DeepMind.

Si l'on ajoute à cela le fait qu'il n'y a pas de calendrier précis pour la version officielle de Sora, ce sera comme un drame familier où la bulle d'un projet vedette éclate et où chacun dans le jeu a ses propres plans.

Récemment, la compétition vidéo IA a commencé à devenir plus intense.

Selon les statistiques de SimilarWeb, le nombre total de visites sur le site Web Luma AI du leader mondial de la production de vidéos IA en septembre n'était que de 11,81 millions de fois, soit une baisse mensuelle de 38,49 %. Le succès pika a également connu une baisse du nombre total de visites en septembre. Bien qu'il soit redevenu populaire grâce à un lot de nouveaux effets de modèles dans la nouvelle version d'octobre, la question de savoir comment le produit peut continuer à susciter l'intérêt des utilisateurs a progressivement fait surface.

Certains, initialement méfiants à l'égard de Sora, sont maintenant réévalués, comme le cinéaste Patrick Cederberg qui a déclaré en avril qu'il devait faire en sorte que le modèle génère des centaines de courts clips avant de pouvoir en trouver un. Autrement dit, Sora est très difficile à utiliser.

Heureusement, Tim Brooks n'a pas dit au revoir à la vidéo IA. Il rejoindra très probablement l'outil de génération de vidéo IA de DeepMind, Veo. L'ascension et la chute de Sora ne sont peut-être pas la seule référence pour l'industrie de la vidéo IA. Au moins en termes de capacités, des challengers comme Meta Movie Gen commencent à prétendre avoir tué Sora. L’écosystème national des produits vidéo IA a également subi de nouveaux changements.

En d’autres termes, le refroidissement de la piste vidéo de l’IA est également la période de gestation avant que le prochain lot de meilleurs produits ne soit itéré. Récemment, il semble qu'un produit suffisamment étonnant soit entré dans l'attention du public.

01

PixVerse V3 brise vraiment le mur dimensionnel

Alors que les produits vidéo IA sur le marché sont devenus si abondants que les gens commencent à ressentir une « fatigue visuelle », PixVerse V3 est-il vraiment assez spécial ?

Si vous avez des doutes similaires, l’apparence de ce Pikachu suffit à dissiper la plupart d’entre eux.

À l’exception des démonstrations de conférences de presse qui ne peuvent pas être reproduites, c’est probablement la première fois que des images bidimensionnelles et le monde réel peuvent interagir aussi harmonieusement dans la génération vidéo IA.

Sur la photo, l'image de ce Pikachu est exactement la même que celle dont on se souvient du dessin animé, mais il est apparu dans une rue très fréquentée, puis a sauté dans les bras d'un petit frère.

Voici l'invite requise pour cette vidéo :

Caméra frontale centrale : Pikachu se tient dans une rue animée de la ville, à côté d'un routard. Le routard passe devant la caméra et Pikachu court par derrière. J'ai sauté dans les bras du routard. Pikachu lui serra joyeusement le cou et était très proche. Les piétons se précipitaient et les routards portaient Pikachu vers l'avant, dont les joues pétillaient d'excitation, illuminant le moment. Charmant et sans effort.

En 1934, "Hollywood Party" produit par MGM, l'action de Jimmy Durant de tenir "Mickey Mouse" avec ses doigts est devenue la première scène classique de l'histoire du cinéma mondial combinant dessins animés et images réelles, 90 ans plus tard, avec des effets complets. d'ingéniosité mais extrêmement lourde à mettre en œuvre peut enfin être réalisée par l'IA.

Ce qui est scandaleux, c’est que Pikachu a été créé par l’IA, et que le monde réel dans lequel vit Pikachu a également été créé par l’IA. À en juger par les effets, Pixverse V3 a une compréhension très fluide de l'animation entrant dans le monde réel.

Non seulement Pikachu, vous pouvez également utiliser l'invite suivante, qui semble contenir trop d'éléments, pour générer une vidéo de l'oncle Mario entrant dans la gare :

La vidéo montre une gare animée remplie d'une foule diversifiée de passagers attendant avec impatience leurs trains. La caméra balaie la scène, capturant l'atmosphère animée, un gros personnage italien au visage rond, enfile son emblématique chapeau rouge et. salopette bleue. La caméra suit de près Mario alors qu'il monte avec confiance sur la plate-forme, son visage rayonnant d'excitation. La vidéo est dans un style réaliste.

Dans la vidéo, la gare est pleine de passagers de toutes sortes qui attendent impatiemment le train. La caméra effectue un panoramique sur la scène, capturant l’atmosphère animée. Alors que le train s'approche lentement du quai, la caméra suit le grand personnage italien au visage rond, Super Mario, portant son emblématique chapeau rouge et sa salopette bleue, il marche avec confiance sur le quai avec un sourire excité sur le visage. Le style de la vidéo est très réaliste.

Il y a un protagoniste distinct, Mario, dans l'image. Chacune des foules animées derrière lui a des détails différents sur ses mouvements. À mesure que Mario avance le long de la caméra, les bords où les personnages animés se croisent avec l'environnement réel sont également traités très clairement. et proprement, au même moment, le train entra également en gare.

Si les personnages de dessins animés ne peuvent pas satisfaire votre appétit, voyons comment PixVerse V3 se comporte sur les grandes scènes.

——Mots clés : Le dragon s'endort.

L'invite complète ressemble à ceci :

Travelling au Steadycam d'un dragon plongeant dans l'eau, le moine lève les bras en signe d'appréciation.

Suivi Steadicam : Un dragon plonge dans l’eau et un moine lève les bras en signe d’appréciation.

Bien que la vidéo manque encore de certains détails mentionnés dans Prompt, dans l'ensemble, qu'il s'agisse de la cohérence du mouvement de la caméra, de la capacité à utiliser des tons sombres pour exprimer subtilement la tension de l'image et de l'utilisation de monstres au loin et abandonnés. les voitures au premier plan Les capacités de génération vidéo de PixVerse V3 ont commencé à se rapprocher de la qualité d'image d'un film.

En plus des vidéos de Vincent, PixVerse V3 a également démontré d'excellentes capacités vidéo basées sur l'image.

La vidéo de Tusheng est très imaginative. Vous pouvez essayer de trouver une belle affiche de western américain, ajouter une invite et le laisser faire des choses « scandaleuses » - comme en rencontrer une de mauvaise qualité :

L'invite ressemble à ceci :

L'invite complète ressemble à ceci :

Le pistolet a des ratés et dégage de la fumée noire, ce qui salit le visage de l'homme.

Le pistolet a raté son coup et de la fumée noire s'est échappée, tachant le visage de l'homme.

Le sentiment le plus distinctif de PixVerse V3 en termes de capacités vidéo Wensheng et Tusheng est qu'il est extrêmement proche des points d'intérêt de la vie quotidienne des gens ordinaires. En fait, à l’exception des praticiens professionnels liés à la création vidéo, peu de personnes ont besoin d’utiliser un logiciel vidéo d’IA pour créer une œuvre cinématographique et télévisuelle parfaite. Au contraire, de plus en plus de personnes qui viennent d'utiliser la capacité de génération vidéo sont curieuses de savoir si cette capacité peut être utilisée avec le monde réel ou même avec elles-mêmes. Par exemple, vous pouvez introduire vos personnages de dessins animés préférés dans les endroits où vous sortez tous les jours, ou même vous transformer en personnages de dessins animés comme Iron Man.

Bon nombre des difficultés actuellement rencontrées par les produits vidéo IA sont dues au fait qu'ils sont coincés dans l'auto-promotion des capacités techniques et que les utilisateurs ont disparu. À ce stade où la technologie vidéo Vincent vient d'émerger, ce que la plupart des gens ordinaires pourraient aimer, c'est un produit vidéo IA suffisamment proche d'eux et suffisamment convivial.

De ce point de vue, le PixVerse V3 actuel est peut-être le produit qui devine le plus précisément l'esprit de l'utilisateur.

L'étonnante de PixVerse V3 n'est pas seulement due aux capacités itératives du grand modèle vidéo d'IA derrière PixVerse V3, mais aussi à son optimisation des capacités de compréhension rapide des mots. Je pense que les personnes prudentes l'auront remarqué après avoir vu les exemples d'invite ci-dessus.

"Sujet + Description du sujet + Mouvement + Environnement" est une formule d'invite qui maximise l'efficacité de la génération vidéo AI. Par rapport à la V2.5, vous pouvez désormais ajouter une dimension "description de la prise de vue" à PixVerse V3.

Bien entendu, en plus de suivre cette formule, Prompt doit décrire les actions du personnage de manière aussi détaillée que possible et éviter les descriptions trop simplistes.

Dans le même temps, PixVerse V3 propose également une sélection plus riche de vidéos de sortie. En termes de formats vidéo de sortie, PixVerse V3 prend en charge une variété de formats vidéo, notamment 16:9, 9:16, 3:4, 4:3 et 1. :1. , la fonction de stylisation a également été mise à niveau après cette mise à jour de version. Désormais, les deux modes de Vincent Video et Tusheng Video prennent en charge quatre choix de styles : animation, réalité, argile et 3D.

En un mot, PixVerse V3 n'est pas seulement plus fort cette fois-ci, il veut même vous mettre entre les mains les descriptions de produits ligne par ligne.

Sur la plateforme sociale X, de nombreux adeptes des produits d'IA ont commencé à utiliser PixVerse V3, comme Pierrick Chevallier, qui compte de nombreux fans. Il a même créé un article dédié pour montrer les vidéos qu'il a générées à l'aide de PixVerse V3. En plus de sa puissante capacité de génération, ce qui est accrocheur, c'est qu'il montre de nombreuses vidéos très « à saveur d'Halloween ».

02

Cet Halloween, laissez PixVerse V3 faire les « effets »

Afin de briser le cercle d'un produit vidéo IA suffisamment intéressant, en plus de disposer d'un support technique suffisant, il a également besoin d'une bonne opportunité. En parlant de ça, la sortie de PixVerse V3 arrive à point nommé.

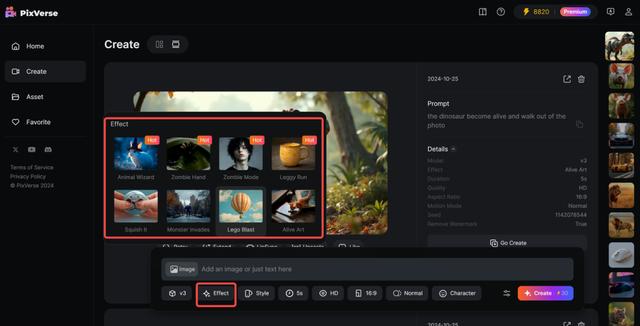

Le 1er novembre est Halloween, et ce moment de la fin octobre est le pic annuel de l'imagination des jeunes. En conjonction avec le thème Halloween, PixVerse V3 a publié une série de modèles sur le thème d'Halloween, vous permettant d'utiliser l'IA pour « lancer des sorts » sur tout ce qui vous entoure.

Il existe cette fois un total de 8 modèles sur le thème d'Halloween publiés dans PixVerse V3, dont l'un se concentre sur la « Transformation en personne vivante ».

Par exemple, un monstre apparaît de nulle part dans la ville.

En plus de ces grandes scènes, PixVerse V3 peut directement rendre les éléments d'une photo « vivants », comme par exemple faire en sorte que le chiot dans « Je t'attends sous la pluie » sorte vraiment de la photo :

Le chiot a même un mouvement naturel de lever la tête avant de se lever. Après avoir quitté la photo, la photo originale ne laissait qu'une pelouse calme et l'effet global était assez époustouflant.

Ce modèle propose également un gameplay plus imaginatif. Par exemple, l'Homme de Vitruve des œuvres de Léonard de Vinci peut-il sortir du cercle qui l'entoure ?

Quelque chose comme ça :

Pouvoir monter un tel spectacle à Halloween suffit à émerveiller le public.

Cette fois, le deuxième type de modèle préparé par PixVerse V3 pour Halloween emprunte la voie de l'abstrait.

Par exemple, laissez une boîte en fer se lever et s'enfuir :

Ou encore, brisez une Porsche en morceaux et transformez-la en un tas de blocs :

Bien sûr, cette fois, les modèles de PixVerse V3 ont également de nombreux autres effets de type Halloween qui peuvent être joués, comme mettre un chapeau de sorcier sur la photo d'un personnage puis la déplacer, comme ceci :

Ces modèles d'Halloween sont inclus dans la nouvelle fonctionnalité Effet de PixVerse V3. C'est très simple à utiliser. Après avoir téléchargé l'image, sélectionnez l'effet souhaité et cliquez pour le générer. Vous n'avez pas à vous soucier de saisir des invites au milieu. C'est très convivial pour les personnes qui ne pensent qu'à Halloween.

Cette fois, PixVerse V3 montre des capacités de génération multimodale plus fortes. Basé sur sa propre vidéo Wensheng et Tusheng, PixVerse V3 peut désormais faire en sorte que la vidéo générée transporte le contenu sonore souhaité par l'utilisateur, et si la vidéo originale n'est pas assez longue, PixVerse V3 maintenant. a la capacité de créer d’autres suites de la vidéo originale.

Ces capacités de génération multimodale sont également devenues deux nouvelles fonctionnalités faisant leurs débuts dans PixVerse V3 avec Effect. La première fonction est Lipsync, une fonction de synchronisation labiale qui peut générer des voix synchronisées de personnages multilingues pour des vidéos.

La fonction Lipsync permet aux utilisateurs de saisir leur propre rédaction ou de télécharger des fichiers audio basés sur la vidéo générée, puis PixVerse adaptera automatiquement la forme de la bouche des personnages de la vidéo en fonction de la rédaction ou du contenu du fichier audio. Actuellement, Lipsync peut prendre en charge une durée vidéo de 30 secondes et les langues pouvant effectuer la synchronisation labiale incluent l'anglais, le chinois, le français et le japonais.

Une autre fonction est de prolonger la vidéo, ou elle peut être comprise comme une continuation de l'histoire.

En réponse au problème selon lequel la durée de la vidéo actuellement générée est trop courte, dans PixVerse V3, les utilisateurs peuvent sélectionner la vidéo générée, cliquer sur le bouton « Prolonger », saisir des mots d'invite liés à la façon de développer davantage la vidéo, cliquer sur « créer ", et la vidéo originale sera La mise en scène proposée permet de progresser dans l'intrigue tout en conservant un haut degré de cohérence entre les personnages et les actions.

Avec l'ajout de capacités de génération vidéo multimodale, PixVerse V3 peut désormais générer des vidéos IA avec des récits plus grands et de meilleurs effets audiovisuels, et les limites de la création vidéo IA ont été encore élargies.

Créez un produit vidéo IA véritablement jouable

"Le moment pour ChatGPT sera celui où les utilisateurs ordinaires pourront l'utiliser", a déclaré Wang Changhu, fondateur et PDG d'Aishi Technology, dans une interview en avril de cette année.

Au cours des deux dernières années, chaque nouvelle lueur de technologie de modélisation à grande échelle s’est transformée en de nouveaux grands récits sur les méthodes de production, comme si la vie humaine allait être complètement bouleversée en peu de temps. Mais jusqu’à présent, cela ne s’est pas produit.

Dans le même temps, l'enthousiasme suscité par Sora et l'imagination technique trop ambitieuse ont progressivement fait perdre de vue l'ensemble du domaine des produits vidéo IA et ne trouver aucun lien avec la vie publique. Ainsi, d'une part, les produits vidéo IA tels que Runway, qui se positionnent comme des outils professionnels, sont difficiles à sortir du cercle en raison du seuil d'utilisation élevé. D'autre part, les produits qui se positionnent davantage vers le général. Le public est tombé dans un dilemme de « brûlure après lecture » après avoir été essayé par tout le monde. Une fois la nouveauté dissipée, il est difficile de retenir le produit sans idées de développement claires et spécifiques, il n'a donc d'autre choix que de sombrer. la logique simple de la « filtration » et des « effets spéciaux ».

En d’autres termes, l’immense ouverture des capacités de génération d’IA fait que presque tous les produits actuels dans le domaine de la vidéo IA ressemblent à une sorte de produit semi-fini. Le caractère aléatoire et incontrôlable du contenu généré est intégré dans une expérience nouvelle, ce qui signifie également. qu'il est difficile à utiliser sur le terrain dans un scénario spécifique et persistant.

Tout comme lorsque le monde extérieur était émerveillé par les capacités de génération d'hommes-ballons de Sora, Patrick Cederberg était troublé par le manque de cohérence dans la génération de contenu de Sora. Il se plaignait du fait que la couleur des ballons changeait à chaque génération, et ces imperfections signifient beaucoup de choses. du travail de post-production reste incontournable. Il existe de nombreux problèmes similaires, c'est pourquoi, bien qu'Hollywood ait commencé il y a un an à s'attaquer aux perturbations potentielles de l'industrie cinématographique par les grands modèles, un an plus tard, Sora ne peut toujours pas vraiment entrer dans le flux de travail du cinéma et de la télévision.

À l'heure actuelle, les produits vidéo IA sont plus ou moins piégés dans une situation similaire - bien que les capacités de génération vidéo IA passionnent tout le monde depuis longtemps, les produits de génération vidéo IA sont toujours une belle « exposition de vendeurs » ».

Face au nouveau torrent technologique, il est difficile pour un produit de rester « concret ». Cependant, ce qu'Aishi Technology a fourni depuis la version Web originale de PixVerse jusqu'au PixVerse V3 actuel est un rare chemin d'itération clair et ordonné.

En janvier de cette année, Aishi Technology a officiellement publié la version Web de PixVerse, un produit vidéo PixVerse. Mais à cette époque, y compris PixVerse, le problème rencontré par presque tous les produits vidéo Wensheng était que les images générées étaient incontrôlables, ce qui signifiait que les utilisateurs ne pouvaient pas générer en continu du contenu vidéo autour d'un personnage unifié. Trois mois plus tard, la version Web de PixVerse était équipée de la fonction C2V (Character to Video) développée sur la base du grand modèle vidéo auto-développé, qui résolvait initialement le problème de cohérence dans la création vidéo IA en extrayant avec précision les caractéristiques du personnage pour verrouiller le personnage.

Après avoir corrigé le « rôle » dans la vidéo, PixVerse a concentré les itérations suivantes sur la « contrôlabilité » du comportement dans le contenu généré. En juin de cette année, Aishi Technology a lancé la brosse de mouvement Magic Brush. Les utilisateurs peuvent contrôler avec précision le mouvement et la direction de chaque élément en les appliquant simplement sur l'écran vidéo. PixVerse V2 a été lancé fin juillet. En plus de montrer suffisamment de contrôle sur le contenu généré, la difficulté des invites a également été considérablement réduite. Dans le même temps, les moyens d'affiner les effets générés sont devenus plus abondants.

Il s'agit d'une autre itération avec des intentions très claires : « La forme spécifique du produit doit être essayée, mais en fin de compte, nous espérons toujours servir la majorité des utilisateurs ordinaires », comme l'a déclaré Wang Changhu dans une interview précédente.

Lorsque les capacités de génération vidéo ne peuvent pas répondre directement aux besoins des utilisateurs ordinaires, servir les créateurs professionnels et développer des outils de nouvelle génération basés sur de nouveaux paradigmes de génération de contenu est une priorité plus élevée. "Lorsque les facteurs de production sont inclus dans la technologie - par exemple, l'IA remplace les acteurs, les scènes et les caméras pendant le tournage - alors les capacités de génération vidéo de l'IA peuvent commencer à être utilisées par le public, et le cercle des utilisateurs s'élargira progressivement, créant d'énormes opportunités. "

Cette fois, PixVerse 3V a commencé à essayer d'introduire davantage de gameplay lié à la vie des gens ordinaires et a essayé d'utiliser Prompt pour régler l'objectif. Ce dernier peut être considéré comme une tentative de remplacement partiel de l'appareil photo. De ce point de vue, Aishi Technology a suivi une voie très déterminée pour peaufiner l’orientation de ses produits.

Dans la vague technologique de la génération de vidéos IA, où la divergence est la beauté, le choix d'Aishi Technology est d'aller à contre-courant de la tendance générale, de rester à l'écart des grands récits et de fournir le plan le plus spécifique sur la manière dont les produits vidéo IA peuvent être lus.

Ce n'est que lorsque les gens peuvent le tenir dans leurs mains et jouer avec autant que possible que l'application vidéo d'IA peut passer d'un « salon des vendeurs » dirigé par Sora à un « salon des acheteurs » dynamique.

Les débuts époustouflants de PixVerse V3 pourraient être le début d’un autre changement positif derrière ce « refroidissement » des vidéos IA.