L'éditeur de Downcodes a appris que l'équipe Tongyi Qianwen a récemment rendu open source sa dernière série complète de modèles Qwen2.5-Coder, ce qui marque une nouvelle étape dans le domaine des grands modèles open source. Les modèles de la série Qwen2.5-Coder ont attiré beaucoup d'attention en raison de leurs puissantes capacités de codage, de leurs diverses fonctions et de leur praticité. Ils ont démontré d'excellentes performances en matière de génération, de réparation et de raisonnement de code, offrant aux développeurs des outils puissants favorisant le développement ultérieur du code ouvert. LLM. L'open source de cette série de modèles favorisera grandement l'application et l'innovation de la technologie de l'intelligence artificielle dans le domaine de la programmation.

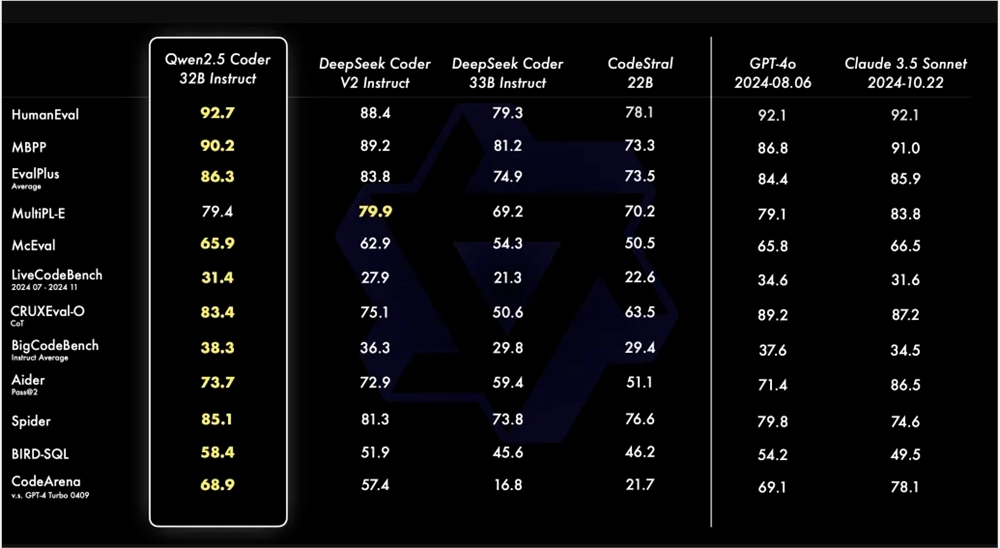

L'équipe Tongyi Qianwen a récemment annoncé qu'elle ouvrirait la dernière série Qwen2.5-Coder. Cette décision vise à promouvoir le développement de LLM Open Code. Qwen2.5-Coder a attiré l'attention pour sa puissance, sa diversité et sa praticité. Le modèle Qwen2.5-Coder-32B-Instruct a atteint le niveau SOTA en termes de capacités de code, qui est équivalent à GPT-4o, montrant des capacités complètes, y compris la génération de code, la réparation de code et le raisonnement de code. Il atteint des performances optimales sur plusieurs benchmarks de génération de code et obtient un score de 73,7 sur le benchmark Aider, comparable à GPT-4o.

Qwen2.5-Coder prend en charge plus de 40 langages de programmation et a obtenu 65,9 points sur McEval, des langages tels que Haskell et Racket étant particulièrement performants. Cela est dû à son nettoyage et à sa mise en correspondance uniques des données au cours de la phase de pré-formation. De plus, Qwen2.5-Coder-32B-Instruct fonctionne également bien en termes de capacités de réparation de code dans plusieurs langages de programmation, obtenant un score de 75,2 dans le benchmark MdEval, se classant premier.

Afin de tester les performances d'alignement de Qwen2.5-Coder-32B-Instruct sur les préférences humaines, un benchmark d'évaluation des préférences de code annoté en interne, Code Arena, a été construit. Les résultats montrent que Qwen2.5-Coder-32B-Instruct présente des avantages en termes d'alignement préféré.

La série Qwen2.5-Coder propose cette fois des modèles open source en quatre tailles, dont 0,5B/3B/14B/32B, couvrant les six tailles de modèles grand public pour répondre aux besoins des différents développeurs. Le responsable propose deux modèles : Base et Instruct. Le premier sert de base aux développeurs pour affiner le modèle, et le second sert de modèle de discussion officiellement aligné. Il existe une corrélation positive entre la taille du modèle et les performances, et Qwen2.5-Coder atteint les performances SOTA dans toutes les tailles.

Le modèle 0,5B/1,5B/7B/14B/32B de Qwen2.5-Coder adopte la licence Apache2.0, tandis que le modèle 3B est sous licence Research Only. L'équipe a vérifié l'efficacité de la mise à l'échelle sur les Code LLM en évaluant les performances de Qwen2.5-Coder de différentes tailles sur tous les ensembles de données.

L'open source de Qwen2.5-Coder offre aux développeurs un choix de modèles de programmation puissant, diversifié et pratique, contribuant ainsi à promouvoir le développement et l'application de modèles de langage de programmation.

Lien du modèle Qwen2.5-Coder :

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

En bref, l'open source de Qwen2.5-Coder apporte un outil puissant aux développeurs, et ses excellentes performances et sa large applicabilité favoriseront grandement le développement du domaine de la génération et de la programmation de code. Nous espérons que Qwen2.5-Coder pourra jouer un rôle dans davantage de scénarios d'application à l'avenir.