Le développement rapide de l’IA générative a apporté du confort, mais il a également posé le problème de la prolifération de fausses informations. Pour résoudre ce problème, Microsoft a lancé un nouvel outil appelé Correction, conçu pour corriger les informations erronées contenues dans le contenu généré par l'IA. L'éditeur de Downcodes vous amènera à comprendre en profondeur les principes, les applications et les enjeux de cet outil.

Aujourd’hui, avec le développement rapide de l’intelligence artificielle, même si l’IA générative a apporté de nombreux avantages, les fausses informations qu’elle génère sont également devenues un problème incontournable. En réponse à ce défi, le géant de la technologie Microsoft a récemment lancé un nouvel outil appelé Correction, conçu pour corriger les fausses informations contenues dans le contenu généré par l'IA.

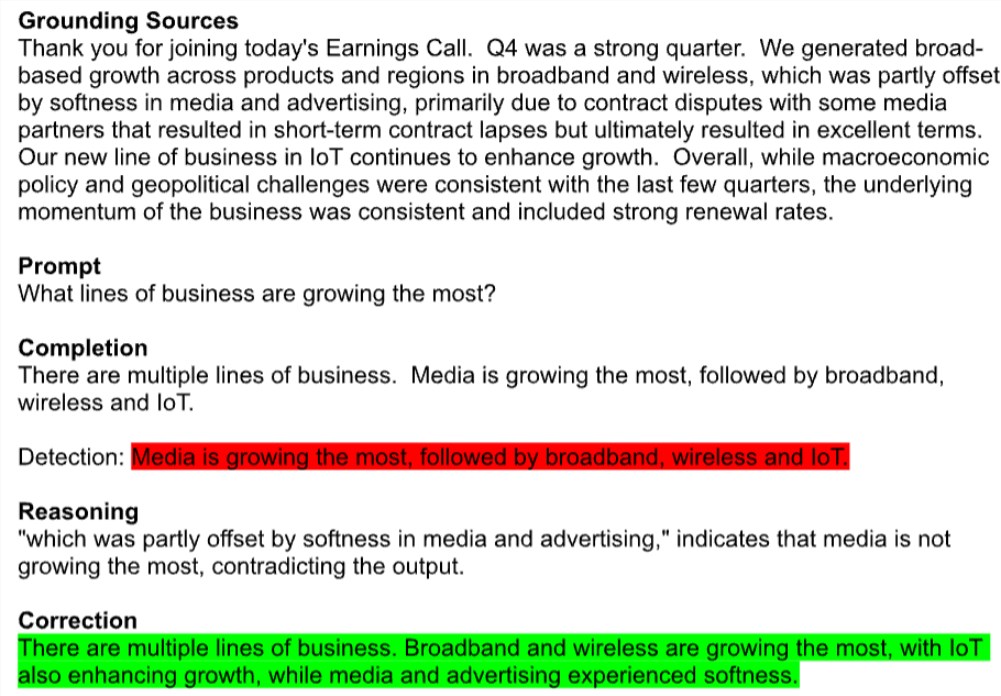

La correction est actuellement en préversion dans le cadre de l'API Azure AI Content Security de Microsoft. L'outil signale automatiquement les textes potentiellement erronés, tels que les résumés des résultats trimestriels des entreprises mal cités, et les compare à des sources crédibles pour corriger ces erreurs. Notamment, cette technologie fonctionne sur tous les modèles d’IA de génération de texte, y compris Meta’s Llama et OpenAI’s GPT-4.

Un porte-parole de Microsoft a déclaré que Correction garantit que le contenu généré est cohérent avec les documents réels en combinant de petits modèles de langage avec de grands modèles de langage. Ils espèrent que cette nouvelle fonctionnalité aidera les développeurs dans des domaines tels que le médical à améliorer la précision des réponses.

Les experts restent toutefois prudents. Os Keyes, doctorant à l'Université de Washington, estime qu'essayer de supprimer l'illusion de l'IA générée, c'est comme essayer d'éliminer l'hydrogène de l'eau, ce qui est un élément fondamental du fonctionnement de la technologie. En fait, les modèles de génération de texte produisent de fausses informations parce qu’ils ne savent rien et se contentent de faire des suppositions basées sur l’ensemble d’entraînement. Une étude a révélé que ChatGPT d’OpenAI avait un taux d’erreur allant jusqu’à 50 % lors des réponses à des questions médicales.

La solution de Microsoft consiste à identifier et à corriger ces fausses informations grâce à une paire de métamodèles d'édition à références croisées. Un modèle de classification recherche d'éventuelles erreurs, des fragments de texte fictifs ou non pertinents, et si ceux-ci sont détectés, un deuxième modèle de langue est introduit pour tenter de les corriger en fonction du document sous-jacent spécifique.

Bien que Microsoft affirme que la correction peut améliorer considérablement la fiabilité du contenu généré par l'IA, les experts ont encore des doutes. Mike Cook, chercheur à l'Université Queen Mary, a souligné que même si la correction fonctionne comme annoncé, elle pourrait exacerber les problèmes de confiance et d'explicabilité dans l'IA. Le service peut donner aux utilisateurs un faux sentiment de sécurité, les amenant à croire que le modèle est plus précis qu’il ne l’est en réalité.

Il convient de mentionner que Microsoft avait également des calculs commerciaux cachés lors du lancement de Correction. Bien que la fonctionnalité elle-même soit gratuite, il existe une limite d'utilisation mensuelle pour les capacités de base de détection de documents nécessaires à la détection de la désinformation, et toute utilisation supplémentaire sera facturée.

Microsoft est clairement sous pression pour prouver la valeur de ses investissements en IA. La société a dépensé près de 19 milliards de dollars en dépenses d’investissement et en équipements liés à l’IA au deuxième trimestre de cette année, mais n’a jusqu’à présent généré que des revenus modestes grâce à l’IA. Récemment, certains analystes de Wall Street ont abaissé la note de Microsoft, remettant en question la faisabilité de sa stratégie d'IA à long terme.

Le risque potentiel d’exactitude et de désinformation est devenu l’une des plus grandes préoccupations des entreprises lorsqu’elles testent des outils d’IA. Cook a conclu que s'il s'agissait d'un cycle de vie normal d'un produit, l'IA générative devrait encore être en phase de recherche et de développement universitaire pour continuer à s'améliorer et à comprendre ses forces et ses faiblesses. Cependant, nous l’avons utilisé dans plusieurs secteurs.

L’outil Correction de Microsoft est sans aucun doute une tentative de résoudre le problème de la désinformation sur l’IA, mais il reste à voir s’il peut réellement briser la crise de confiance dans l’IA générative. Alors que la technologie de l’IA se développe rapidement, la manière d’équilibrer innovation et risque deviendra un problème important auquel sera confronté l’ensemble du secteur.

Dans l’ensemble, l’émergence de l’outil Correction de Microsoft marque l’attention croissante de l’industrie au problème des fausses informations sur l’IA, mais elle déclenche également une réflexion approfondie sur la crédibilité et le modèle économique de l’IA. À l’avenir, comment mieux utiliser la technologie de l’IA tout en contrôlant efficacement ses risques constituera un défi majeur auquel tous seront confrontés.