La startup Rhymes AI, basée à Tokyo, a publié son premier modèle d'intelligence artificielle, Aria, un modèle expert hybride multimodal (MoE) open source. L'éditeur de Downcodes a appris qu'Aria fonctionne bien dans le traitement d'une variété d'entrées telles que le texte, le code, les images et les vidéos, et que ses capacités dépassent même certains modèles commerciaux bien connus. Aria utilise une architecture MoE unique pour augmenter l'efficacité informatique grâce à plusieurs experts spécialisés, et dispose d'une fenêtre contextuelle multimodale pouvant contenir jusqu'à 24,9 milliards de paramètres et 64 000 jetons, lui permettant de gérer des données d'entrée plus longues. Rhymes AI a également coopéré avec AMD pour optimiser les performances du modèle et a lancé l'application de recherche BeaGo basée sur le matériel AMD.

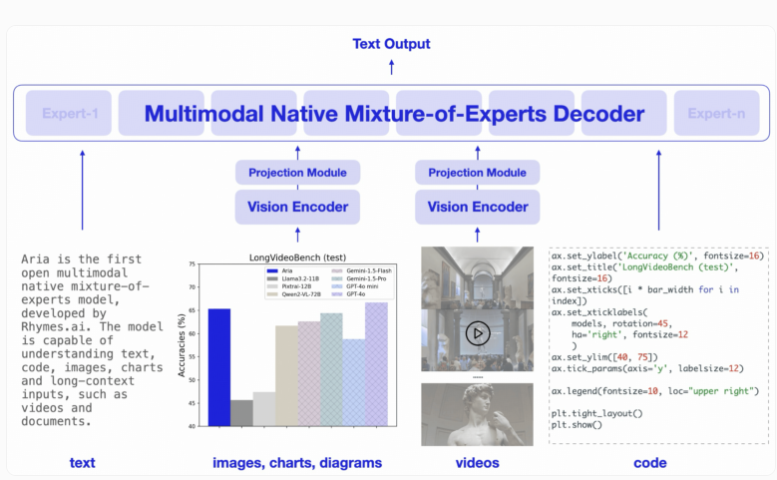

Aria est conçu pour offrir des capacités supérieures de compréhension et de traitement dans une variété de formats d'entrée, notamment le texte, le code, les images et la vidéo. Différent du modèle Transformer traditionnel, le modèle MoE remplace sa couche de rétroaction par plusieurs experts professionnels. Lors du traitement de chaque jeton d'entrée, un module de routage sélectionne un sous-ensemble d'experts à activer, améliorant ainsi l'efficacité de calcul et réduisant le nombre de paramètres d'activation par jeton.

Le décodeur d'Aria peut activer 3,5 milliards de paramètres par jeton de texte, et l'ensemble du modèle comporte 24,9 milliards de paramètres. Pour gérer les entrées visuelles, Aria a également conçu un encodeur visuel léger avec 438 millions de paramètres capables de convertir des entrées visuelles de différentes longueurs, tailles et proportions en jetons visuels. De plus, la fenêtre contextuelle multimodale d'Aria atteint 64 000 jetons, ce qui signifie qu'elle peut gérer des données d'entrée plus longues.

En termes de formation, Rhymes AI est divisé en quatre étapes. Elle utilise d'abord des données textuelles pour la pré-formation, puis introduit des données multimodales, suivies d'une formation en séquence longue et enfin d'un réglage fin.

Dans ce processus, Aria a utilisé un total de 6 400 milliards de jetons de texte et 400 milliards de jetons multimodaux pour la pré-formation. Les données provenaient d'ensembles de données bien connus tels que Common Crawl et LAION, et certaines améliorations synthétiques ont été apportées.

Selon des tests de référence pertinents, Aria surpasse les modèles tels que Pixtral-12B et Llama-3.2-11B dans de multiples tâches multimodales, de langage et de programmation, et présente des coûts d'inférence inférieurs en raison d'un nombre réduit de paramètres d'activation.

De plus, Aria fonctionne bien lors du traitement de vidéos avec sous-titres ou de documents de plusieurs pages, et sa capacité à comprendre de longues vidéos et documents dépasse les autres modèles open source tels que GPT-4o mini et Gemini1.5Flash .

Pour faciliter l'utilisation, Rhymes AI publie le code source d'Aria sur GitHub sous la licence Apache2.0, prenant en charge une utilisation académique et commerciale. Dans le même temps, ils fournissent également un cadre de formation permettant d'affiner Aria pour plusieurs sources et formats de données sur un seul GPU. Il convient de mentionner que Rhymes AI a conclu une coopération avec AMD pour optimiser les performances du modèle et a démontré une application de recherche appelée BeaGo, qui peut fonctionner sur le matériel AMD pour fournir aux utilisateurs des résultats de recherche d'IA de texte et d'image plus complets.

Souligner:

Aria est le premier modèle d'IA expert hybride multimodal open source au monde.

Aria surpasse de nombreux modèles homologues lors du traitement d'une variété d'entrées telles que du texte, des images et des vidéos.

? Rhymes AI coopère avec AMD pour optimiser les performances du modèle et lancer l'application de recherche BeaGo qui prend en charge plusieurs fonctions.

Dans l’ensemble, l’open source et les hautes performances du modèle Aria ont apporté de nouvelles avancées dans le domaine de l’intelligence artificielle et fourni des outils puissants aux développeurs et aux chercheurs. Ses capacités multimodales et sa grande efficacité de calcul lui confèrent un grand potentiel pour les applications futures. L'éditeur de Downcodes attend avec impatience l'application et le développement d'Aria dans davantage de domaines.