La capacité de raisonnement des grands modèles linguistiques (LLM) est un point chaud de la recherche dans le domaine de l’intelligence artificielle. L'équipe de recherche d'Apple en IA a récemment publié un article révélant les limites des LLM en matière de raisonnement mathématique. L'éditeur de Downcodes interprétera le contenu principal de l'article et analysera son impact sur le développement de la technologie de l'IA.

Dans le monde de l’intelligence artificielle, les capacités de raisonnement des modèles d’apprentissage automatique, en particulier les grands modèles de langage (LLM), ont toujours été au centre des préoccupations des scientifiques.

Récemment, l'équipe de recherche d'Apple en IA a publié un article intitulé « Comprendre les limites des grands modèles linguistiques dans le raisonnement mathématique », qui révèle les limites de ces modèles dans le traitement des problèmes logiques.

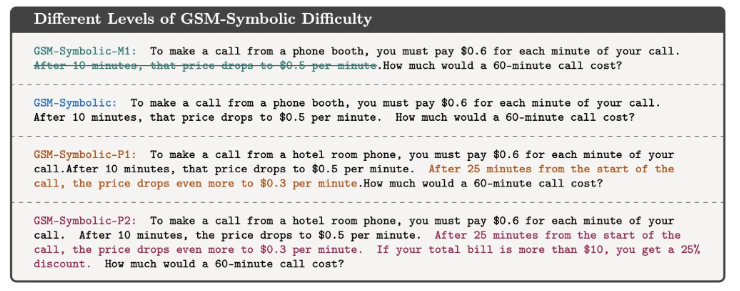

Dans cet article, les chercheurs démontrent cela à travers un simple problème mathématique. Ils ont d'abord posé une question sur Oliver cueillant des kiwis :

Comme indiqué ci-dessous :

Oliver a cueilli 44 kiwis vendredi. Samedi, il a cueilli 58 autres kiwis. Dimanche, il a récolté deux fois plus de kiwis que vendredi. Combien de kiwis Oliver possède-t-il au total ?

Évidemment, la réponse est 44+58+ (44*2) =190. Bien que les grands modèles de langage ne soient pas réellement parfaits mathématiquement, ils peuvent résoudre des problèmes comme celui-ci de manière assez fiable.

Mais si vous ajoutez des informations non pertinentes pour observer la réponse du modèle, telles que :

Oliver a cueilli 44 kiwis vendredi. Samedi, il en a choisi 58 autres. Dimanche, il a cueilli deux fois plus de kiwis que vendredi, mais cinq d'entre eux étaient un peu plus petits que la moyenne. Combien de kiwis Oliver possède-t-il ?

Bien que cela ne change pas la nature mathématique du problème, même les LLM les plus modernes donnent des réponses erronées à cette petite perturbation. Par exemple, GPT-o1-mini a soustrait par erreur 5 petits kiwis du nombre total de kiwis cueillis dimanche.

Cette expérience montre que même si les LLM peuvent donner la bonne réponse dans certains cas, ils ne comprennent pas vraiment la nature du problème.

Les chercheurs pensent que les schémas d’échec de ces modèles indiquent qu’ils n’effectuent pas un véritable raisonnement logique mais reproduisent les étapes de raisonnement qu’ils ont observées dans les données d’entraînement. C'est comme si un LLM était capable de compter que « Je t'aime » est généralement suivi de « Je t'aime aussi », mais cela ne signifie pas qu'il comprend vraiment le sens de l'amour.

Mehrdad Farajtabar, l'un des co-auteurs de l'article, a expliqué plus en détail ses conclusions sur les réseaux sociaux. Il souligne que s'il est possible d'améliorer les performances du modèle dans certains cas simples grâce à une meilleure ingénierie des indices, pour les perturbations complexes, le modèle peut avoir besoin de plus de données contextuelles pour être géré correctement, et ces perturbations peuvent ne pas être du tout réalisables pour un petit enfant. .Pas de problème.

Cette étude nous rappelle que même si les LLM excellent dans le traitement du langage, leurs capacités en raisonnement logique restent limitées. Il ne s’agit pas seulement d’une question académique. À mesure que la technologie de l’IA fait de plus en plus partie de notre vie quotidienne, les réponses à ces questions deviennent de plus en plus importantes.

Nous ne pouvons pas simplement supposer que l’IA peut comprendre et exécuter des tâches complexes, mais nous devons mieux comprendre leur fonctionnement et leurs limites. Cette recherche nous permet de mieux comprendre les technologies de l’IA, tout en fournissant également des informations précieuses sur la manière dont nous utilisons et développons ces technologies.

Référence : https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

Dans l'ensemble, les recherches de l'équipe Apple mettent en évidence les limites des grands modèles de langage dans le raisonnement logique, nous rappelant que nous devons être prudents quant aux capacités de l'IA et continuer à prêter attention à son orientation de développement pour éviter de trop dépendre de ses capacités. À l’avenir, nous devrons étudier plus en profondeur comment améliorer les capacités de raisonnement des LLM afin qu’ils puissent véritablement comprendre l’essence du problème au lieu de simplement imiter les modèles existants.