L'éditeur de Downcodes vous apporte une grande nouveauté ! Il y a un nouveau membre dans le domaine de l'intelligence artificielle : Zyphra a officiellement publié son petit modèle de langage Zamba2-7B ! Ce modèle à 7 milliards de paramètres a réalisé une percée en termes de performances, notamment en termes d'efficacité et d'adaptabilité, montrant des avantages impressionnants. Il convient non seulement aux environnements informatiques hautes performances, mais plus important encore, Zamba2-7B peut également fonctionner sur des GPU grand public, permettant à davantage d'utilisateurs de découvrir facilement le charme de la technologie avancée d'IA. Cet article approfondira les innovations de Zamba2-7B et son impact sur le domaine du traitement du langage naturel.

Récemment, Zyphra a officiellement lancé Zamba2-7B, un petit modèle de langage aux performances sans précédent, avec un nombre de paramètres atteignant 7B.

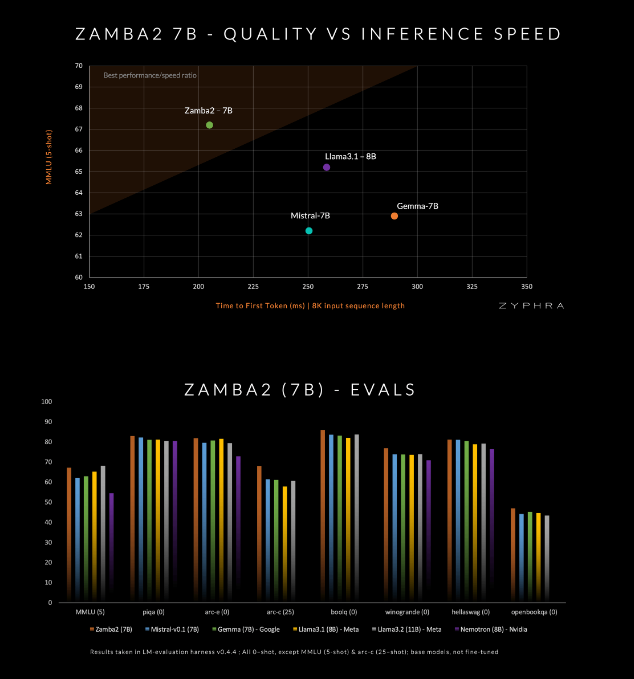

Ce modèle prétend surpasser ses concurrents actuels en termes de qualité et de vitesse, notamment le Mistral-7B, le Gemma-7B de Google et le Llama3-8B de Meta.

Zamba2-7B est conçu pour répondre aux besoins des environnements qui nécessitent de puissantes capacités de traitement du langage mais sont limités par les conditions matérielles, telles que le traitement sur l'appareil ou l'utilisation de GPU grand public. En améliorant l'efficacité sans sacrifier la qualité, Zyphra espère permettre à un plus large éventail d'utilisateurs, qu'il s'agisse d'entreprises ou de développeurs individuels, de profiter de la commodité de l'IA avancée.

Zamba2-7B a apporté de nombreuses innovations dans son architecture pour améliorer l'efficacité et les capacités d'expression du modèle. Différent du modèle de génération précédente Zamba1, Zamba2-7B utilise deux blocs d'attention partagés. Cette conception permet de mieux gérer les dépendances entre le flux d'informations et les séquences.

Le bloc Mamba2 constitue le cœur de toute l'architecture, ce qui rend l'utilisation des paramètres du modèle supérieure à celle des modèles de convertisseurs traditionnels. De plus, Zyphra utilise également la projection LoRA (low-rank adaptation) sur des blocs MLP partagés, ce qui améliore encore l'adaptabilité de chaque couche tout en conservant la compacité du modèle. Grâce à ces innovations, le premier temps de réponse du Zamba2-7B a été réduit de 25 % et le nombre de jetons traités par seconde a augmenté de 20 %.

L'efficacité et l'adaptabilité du Zamba2-7B ont été vérifiées par des tests rigoureux. Le modèle est pré-entraîné sur un ensemble de données massif contenant trois mille milliards de jetons, qui sont des données ouvertes de haute qualité et rigoureusement examinées.

De plus, Zyphra introduit également une étape de pré-formation de « recuit » qui réduit rapidement le taux d'apprentissage pour traiter plus efficacement les jetons de haute qualité. Cette stratégie permet à Zamba2-7B de bien fonctionner dans les tests de performance, surpassant ses concurrents en termes de vitesse et de qualité d'inférence, et convient à des tâches telles que la compréhension et la génération du langage naturel sans nécessiter les ressources informatiques massives requises par les modèles traditionnels de haute qualité.

amba2-7B représente une avancée majeure dans les petits modèles de langage, maintenant une qualité et des performances élevées tout en accordant une attention particulière à l'accessibilité. Grâce à une conception architecturale innovante et à une technologie de formation efficace, Zyphra a réussi à créer un modèle qui est non seulement facile à utiliser, mais qui peut également répondre à divers besoins en matière de traitement du langage naturel. La version open source de Zamba2-7B invite les chercheurs, les développeurs et les entreprises à explorer son potentiel et devrait faire progresser le développement du traitement avancé du langage naturel au sein de la communauté au sens large.

Entrée du projet : https://www.zyphra.com/post/zamba2-7b

https://github.com/Zyphra/transformers_zamba2

La version open source de Zamba2-7B a apporté une nouvelle vitalité au domaine du traitement du langage naturel et a offert davantage de possibilités aux développeurs. Nous espérons que Zamba2-7B sera plus largement utilisé à l’avenir et favorisera les progrès continus de la technologie de l’intelligence artificielle !