Rapports de l'éditeur de downcodes : des équipes de recherche de l'Université technique de Prague en République tchèque et de l'École polytechnique fédérale de Zurich ont récemment réalisé une avancée majeure. Ils ont développé une méthode innovante appelée WildGaussians, qui améliore considérablement les performances de la pulvérisation gaussienne 3D (. 3DGS) dans le traitement des structures non structurées. Capacités dans les ensembles d'images. Cette avancée technologique permet de réaliser des reconstructions 3D de haute qualité à partir d'ensembles d'images non structurées telles que des photos marquantes collectées sur Internet, ouvrant ainsi de nouvelles possibilités dans des domaines tels que la réalité virtuelle, la réalité augmentée et la vision par ordinateur. WildGaussians résout principalement des problèmes tels que les changements d'apparence et d'éclairage et l'occlusion d'objets en mouvement grâce à deux composants principaux : la modélisation de l'apparence et la modélisation de l'incertitude, et fonctionne sur des ensembles de données difficiles tels que les ensembles de données NeRF On-the-go et phototourisme. Excellent, c'est réel. la vitesse de rendu temporelle a également atteint le chiffre impressionnant de 117 images par seconde.

Une équipe de recherche de l'Université technique de Prague en République tchèque et de l'ETH Zurich en Suisse a récemment introduit une méthode innovante appelée WildGaussians, qui améliore considérablement les capacités de la technologie de pulvérisation gaussienne 3D (3DGS) lors du traitement d'ensembles d'images non structurés. Cette avancée permet de réaliser une reconstruction 3D de haute qualité à partir d’ensembles d’images non structurées telles que des photos historiques collectées sur Internet.

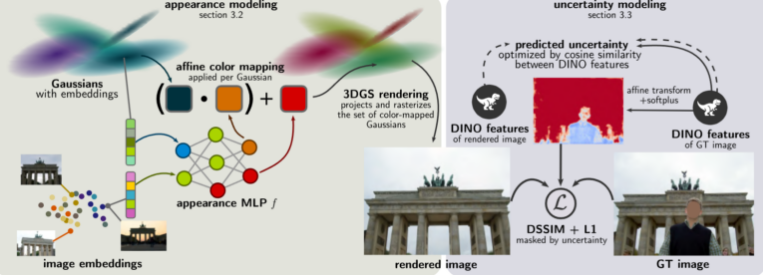

WildGaussians résout principalement deux défis clés : les changements d’apparence et d’éclairage, et les problèmes d’occlusion des objets en mouvement. L'équipe de recherche a relevé ces défis en développant deux composants principaux : la modélisation de l'apparence et la modélisation de l'incertitude.

La modélisation de l'apparence permet au système de traiter des images prises dans différentes conditions, telles que des heures ou des conditions météorologiques différentes. Le procédé utilise une intégration pouvant être entraînée pour chaque image d'entraînement et distribution gaussienne, et ajuste la couleur de la distribution gaussienne aux conditions de prise de vue correspondantes via un réseau neuronal (MLP).

La modélisation de l'incertitude permet d'identifier et d'ignorer les obstructions telles que les piétons ou les voitures pendant l'entraînement. Les chercheurs ont utilisé des fonctionnalités DINOv2 pré-entraînées pour améliorer l'adaptabilité du système aux changements de paysage.

En termes de performances, WildGaussians surpasse les méthodes de pointe existantes sur des ensembles de données difficiles tels que les ensembles de données NeRF On-the-go et Photo Tourism. Dans le même temps, cette méthode a atteint une vitesse de rendu en temps réel de 117 images par seconde sur le GPU Nvidia RTX4090.

Bien que WildGaussians ait fait des progrès significatifs dans le domaine de la reconstruction 3D, les chercheurs admettent que la méthode présente encore certaines limites, comme la représentation de reflets spéculaires sur les objets. Ils prévoient d'améliorer encore cette approche à l'avenir en incorporant des techniques telles que la modélisation de diffusion.

Cette recherche ouvre de nouvelles possibilités de reconstruction 3D robuste, polyvalente et photoréaliste à partir de données bruitées générées par les utilisateurs, ce qui devrait avoir un impact profond dans de multiples domaines tels que la réalité virtuelle, la réalité augmentée et la vision par ordinateur.

L’émergence des WildGaussians marque une avancée importante dans la technologie de reconstruction 3D, et leur efficacité et leur grande précision constituent une base solide pour de nombreuses applications futures. L'éditeur de Downcodes espère que cette technologie pourra être encore améliorée à l'avenir pour nous apporter une expérience numérique plus réaliste et immersive.