L'éditeur de Downcodes a appris que des universitaires chinois du Georgia Institute of Technology et de NVIDIA ont proposé un cadre de réglage innovant appelé RankRAG, qui simplifie considérablement le processus complexe de génération d'amélioration de récupération (RAG). RankRAG affine un seul grand modèle de langage (LLM) pour entreprendre simultanément les tâches de récupération, de classement et de génération, améliorant ainsi considérablement les performances et l'efficacité et obtenant des résultats expérimentaux supérieurs aux modèles open source existants. Cette technologie révolutionnaire ouvre de nouvelles possibilités d’application de l’IA dans divers domaines.

Récemment, deux chercheurs chinois du Georgia Institute of Technology et de NVIDIA ont proposé un nouveau cadre de réglage fin appelé RankRAG. Ce cadre simplifie considérablement le pipeline RAG complexe d'origine et utilise la méthode de réglage fin pour permettre au même LLM d'effectuer la récupération, le classement et la génération. tâches, ce qui a également entraîné une amélioration substantielle des performances.

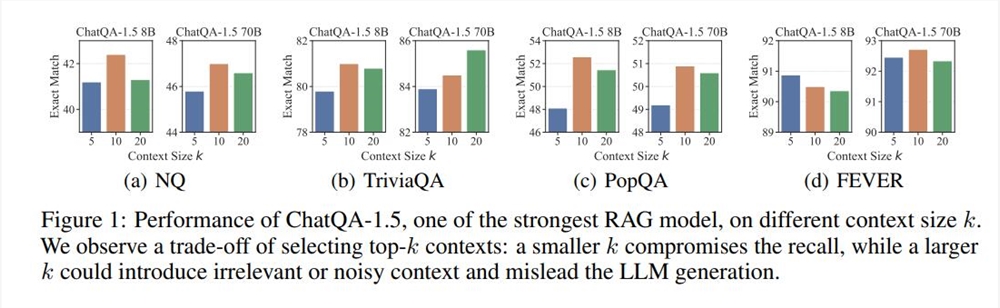

RAG (Retrieval-Augmented Generation) est une technologie couramment utilisée dans le déploiement LLM et est particulièrement adaptée aux tâches de génération de texte qui nécessitent une grande quantité de connaissances factuelles. Généralement, le processus de RAG est le suivant : un modèle dense basé sur l'encodage de texte récupère les k premiers segments de texte d'une base de données externe, puis LLM les lit et les génère. Ce processus a été largement utilisé, mais il présente également des limites, telles que la sélection de la valeur k. Si la valeur k est trop grande, même LLM qui prend en charge un contexte long aura des difficultés à la traiter rapidement ; si la valeur k est trop petite, un mécanisme de récupération à haut rappel est requis, et les récupérateurs et modèles de classement existants ont leurs propres défauts.

Sur la base des problèmes ci-dessus, le framework RankRAG propose une nouvelle idée : étendre les capacités de LLM grâce à un réglage fin et laisser LLM effectuer lui-même la récupération et le classement. Les résultats expérimentaux montrent que cette méthode améliore non seulement l’efficacité des données, mais améliore également considérablement les performances du modèle. En particulier sur plusieurs benchmarks généraux et benchmarks à forte intensité de connaissances biomédicales, le modèle Llama38B/70B affiné par RankRAG a surpassé respectivement les modèles ChatQA-1.58B et ChatQA-1.570B.

La clé de RankRAG est son haut degré d’interactivité et de modification. Les utilisateurs peuvent non seulement visualiser le contenu généré par l'IA en temps réel, mais également le modifier et le parcourir directement sur l'interface. Ce mécanisme de retour instantané améliore considérablement l’efficacité du travail et fait de l’IA un véritable assistant puissant dans le processus créatif. Ce qui est encore plus excitant, c'est que cette mise à jour fait que ces artefacts ne sont plus limités à la plateforme Claude et que les utilisateurs peuvent facilement les partager n'importe où.

Cette innovation du cadre de réglage fin RankRAG comprend également deux étapes de réglage fin de l'instruction. La première étape est le réglage fin supervisé (SFT), qui mélange plusieurs ensembles de données pour améliorer la capacité de suivi des instructions de LLM. L'ensemble de données de réglage fin de la deuxième étape contient une variété de données d'assurance qualité, de données d'assurance qualité améliorées par la récupération et de données de classement contextuel pour améliorer davantage les capacités de récupération et de classement de LLM.

Lors des expériences, RankRAG surpasse systématiquement le modèle SOTA open source ChatQA-1.5 actuel sur neuf ensembles de données de domaine général. Surtout dans les tâches d'assurance qualité difficiles, telles que l'assurance qualité longue traîne et l'assurance qualité multi-sauts, RankRAG améliore les performances de plus de 10 % par rapport à ChatQA-1.5.

Dans l’ensemble, RankRAG fonctionne non seulement bien dans les tâches de récupération et de génération, mais démontre également sa forte adaptabilité sur le benchmark biomédical RAG Mirage. Même sans ajustement fin, RankRAG surpasse de nombreux modèles open source dans des domaines spécialisés sur les tâches de réponse aux questions médicales.

Avec l’introduction et l’amélioration continue du framework RankRAG, nous avons des raisons de croire que l’avenir de la création collaborative entre l’IA et les humains sera plus prometteur. Les développeurs indépendants et les chercheurs peuvent utiliser ce cadre innovant pour inspirer davantage d'idées et de possibilités et promouvoir le développement de technologies et d'applications.

Adresse papier : https://arxiv.org/abs/2407.02485

L'émergence du framework RankRAG annonce un autre bond en avant pour les modèles linguistiques à grande échelle dans les domaines de la recherche d'informations et de la génération de textes. Sa conception efficace et simple et ses excellentes performances fourniront sans aucun doute de nouvelles orientations et motivations pour le développement de la technologie de l’IA à l’avenir. Nous attendons avec impatience que RankRAG montre son fort potentiel dans davantage de domaines !