Dans la formation sur des modèles de langage étendus (LLM), le mécanisme de point de contrôle est crucial, car il peut efficacement éviter d'énormes pertes causées par les interruptions de formation. Cependant, les systèmes de points de contrôle traditionnels sont souvent confrontés à des goulots d'étranglement en matière d'E/S et sont inefficaces. À cette fin, des scientifiques de ByteDance et de l'Université de Hong Kong ont proposé un nouveau système de points de contrôle appelé ByteCheckpoint, qui peut améliorer considérablement l'efficacité de la formation LLM.

Dans un monde numérique dominé par les données et les algorithmes, chaque étape de la croissance de l’intelligence artificielle est indissociable d’un élément clé : le point de contrôle. Imaginez que lorsque vous entraînez un modèle linguistique à grande échelle capable de comprendre l'esprit des gens et de répondre couramment aux questions, ce modèle est extrêmement intelligent, mais il est également un gros consommateur et nécessite d'énormes ressources informatiques pour l'alimenter. Pendant le processus de formation, en cas de panne de courant soudaine ou de panne matérielle, la perte sera énorme. À ce stade, le point de contrôle est comme une machine à voyager dans le temps, permettant à tout de revenir à son état de sécurité précédent et de poursuivre les tâches inachevées.

Cependant, la machine à remonter le temps elle-même nécessitait également une conception minutieuse. Des scientifiques de ByteDance et de l'Université de Hong Kong nous ont présenté un nouveau système de points de contrôle, ByteCheckpoint, dans l'article « ByteCheckpoint : A Unified Checkpointing System for LLM Development ». Il ne s'agit pas seulement d'un simple outil de sauvegarde, mais également d'un artefact qui peut considérablement améliorer l'efficacité de la formation des grands modèles de langage.

Premièrement, nous devons comprendre les défis rencontrés par les grands modèles de langage (LLM). La raison pour laquelle ces modèles sont volumineux est qu'ils doivent traiter et mémoriser d'énormes quantités d'informations, ce qui entraîne des problèmes tels que des coûts de formation élevés, une consommation de ressources importante et une faible tolérance aux pannes. Une fois qu'un dysfonctionnement survient, une longue période de formation peut devenir insatisfaisante.

Le système de points de contrôle est comme un instantané du modèle, sauvegardant régulièrement l'état pendant le processus de formation, de sorte que même en cas de problème, il puisse être rapidement restauré à l'état le plus récent et réduire les pertes. Cependant, les systèmes de points de contrôle existants souffrent souvent d'inefficacités dues aux goulots d'étranglement d'E/S (entrée/sortie) lors du traitement de grands modèles.

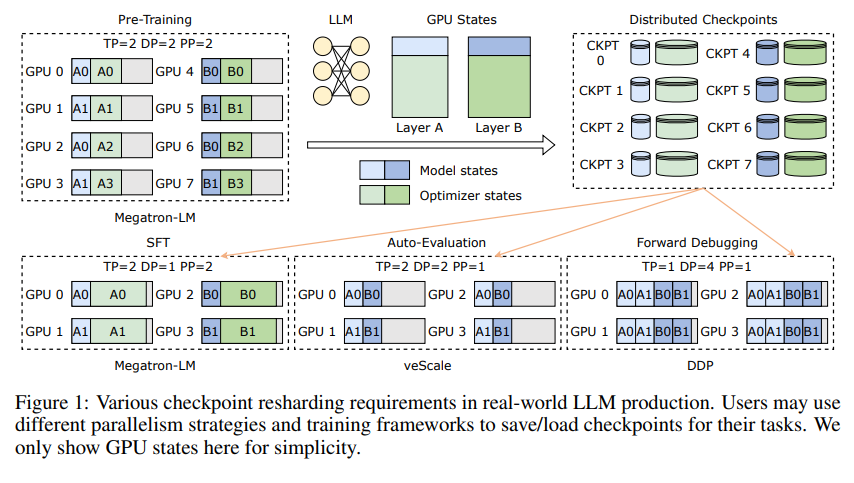

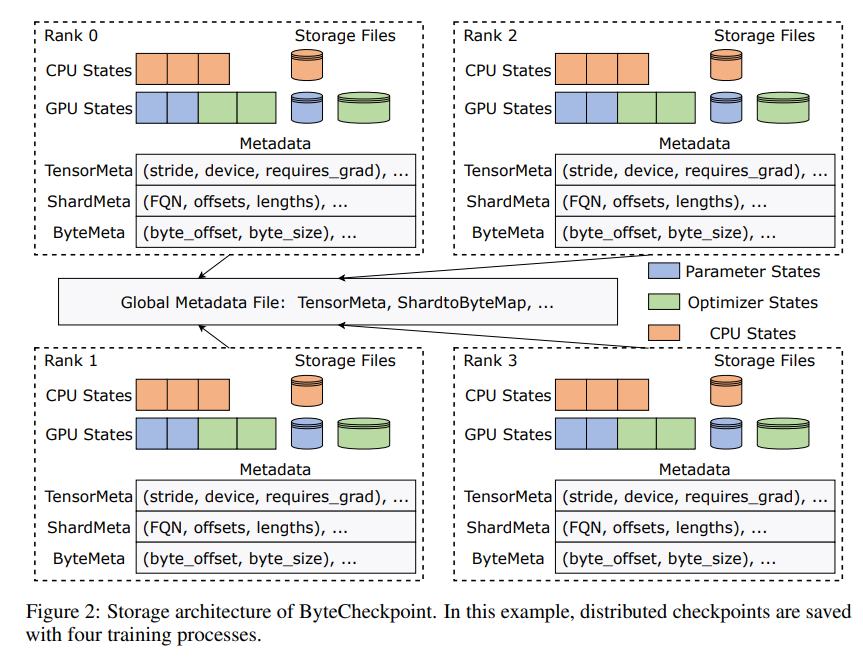

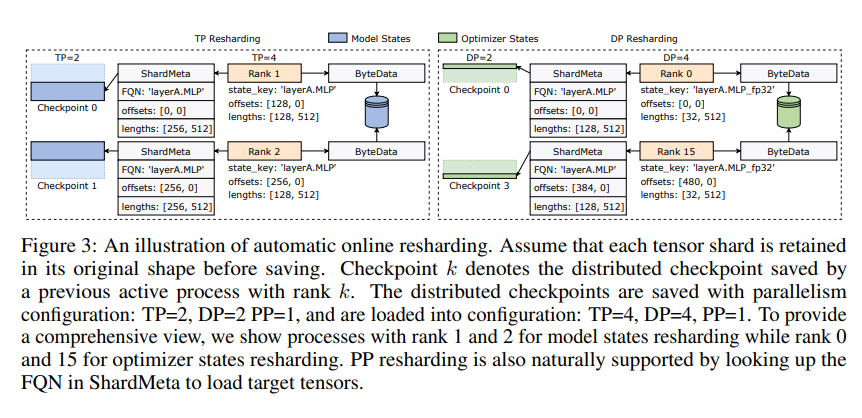

L'innovation de ByteCheckpoint réside dans l'adoption d'une nouvelle architecture de stockage qui sépare les données et les métadonnées et gère de manière plus flexible les points de contrôle sous différentes configurations parallèles et cadres de formation. Mieux encore, il prend en charge le repartitionnement automatique des points de contrôle en ligne, qui peut ajuster dynamiquement les points de contrôle pour s'adapter à différents environnements matériels sans interrompre la formation.

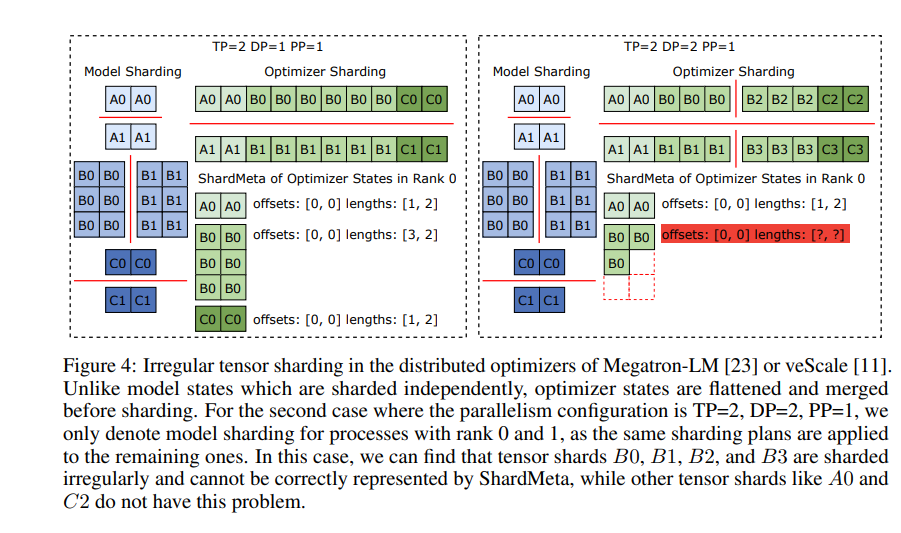

ByteCheckpoint introduit également une technologie clé : la fusion de tenseurs asynchrone. Cela peut gérer efficacement les tenseurs qui sont inégalement répartis sur différents GPU, garantissant que l'intégrité et la cohérence du modèle ne sont pas affectées lors du repartage des points de contrôle.

Afin d'améliorer la vitesse de sauvegarde et de chargement des points de contrôle, ByteCheckpoint intègre également une série de mesures d'optimisation des performances d'E/S, telles qu'un pipeline de sauvegarde/chargement sophistiqué, un pool de mémoire Ping-Pong, une sauvegarde équilibrée de la charge de travail et une charge sans redondance, etc. , ce qui réduit considérablement le temps d'attente pendant le processus de formation.

Grâce à une vérification expérimentale, par rapport aux méthodes traditionnelles, les vitesses de sauvegarde et de chargement des points de contrôle de ByteCheckpoint sont respectivement augmentées de dizaines, voire de centaines de fois, améliorant considérablement l'efficacité de la formation des grands modèles de langage.

ByteCheckpoint n'est pas seulement un système de points de contrôle, mais également un assistant puissant dans le processus de formation de grands modèles de langage. C'est la clé d'une formation d'IA plus efficace et plus stable.

Adresse papier : https://arxiv.org/pdf/2407.20143

L'éditeur de Downcodes résume : L'émergence de ByteCheckpoint résout le problème de la faible efficacité des points de contrôle dans la formation LLM et fournit un support technique solide pour le développement de l'IA. Cela mérite d'être pris en compte !