Le laboratoire d'intelligence artificielle de Shanghai a publié la dernière version du modèle de la série Scholar Puyu, InternLM2.5, lors du forum principal WAIC Science Frontier le 4 juillet 2024. Les capacités de raisonnement de cette version dans des scénarios complexes ont été considérablement améliorées, elle prend en charge un contexte ultra-long de 1 million et peut effectuer de manière indépendante des recherches sur Internet et l'intégration d'informations, ce qui constitue une avancée majeure. L'éditeur de Downcodes expliquera en détail les fonctions et les informations open source d'InternLM2.5.

Le laboratoire d'intelligence artificielle de Shanghai a lancé une nouvelle version du modèle de la série Scholar Puyu, InternLM2.5, lors du forum principal WAIC Science Frontier le 4 juillet 2024. Les capacités de raisonnement de cette version dans des scénarios complexes ont été considérablement améliorées, elle prend en charge un contexte ultra-long de 1 M, peut effectuer des recherches sur Internet de manière indépendante et intégrer des informations provenant de centaines de pages Web.

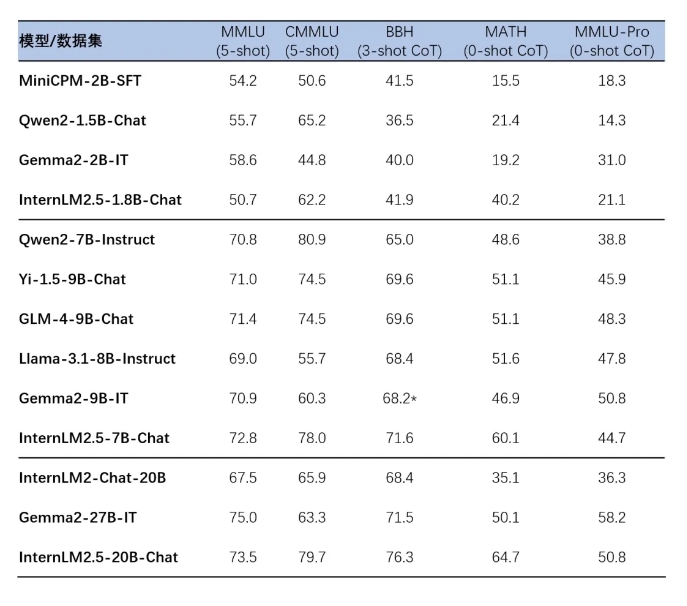

InternLM2.5 a publié trois versions de paramètres du modèle, à savoir 1.8B, 7B et 20B, pour s'adapter aux différents scénarios d'application et besoins des développeurs. La version 1.8B est un modèle ultra-léger, tandis que la version 20B offre des performances globales plus élevées et prend en charge des scénarios pratiques plus complexes. Tous ces modèles sont open source et peuvent être trouvés sur la page d'accueil des grands modèles de la série Scholar·Puyu, la page d'accueil ModelScope et la page d'accueil Hugging Face.

InternLM2.5 itère sur plusieurs technologies de synthèse de données, améliorant considérablement les capacités de raisonnement du modèle. En particulier, le taux de précision sur l'ensemble d'évaluation mathématique MATH a atteint 64,7 %. De plus, le modèle améliore les capacités de traitement de la longueur du contexte grâce à une formation efficace au cours de la phase de pré-formation.

Les modèles de la série InternLM2.5 permettent également une intégration transparente avec les cadres d'inférence et de réglage fin en aval, notamment le cadre de réglage fin XTuner et le cadre d'inférence LMDeploy développés indépendamment par le laboratoire d'intelligence artificielle de Shanghai, ainsi qu'avec d'autres cadres avec de vastes bases d'utilisateurs dans le domaine. communauté telle que vLLM et Ollama et llama.cpp. L'outil SWIFT lancé par la communauté Moda prend également en charge l'inférence, le réglage fin et le déploiement des modèles de la série InternLM2.5.

L'expérience d'application de ces modèles comprend un raisonnement complexe en plusieurs étapes, une compréhension précise des intentions de conversation à plusieurs tours, des opérations de contrôle de format flexibles et la capacité de suivre des instructions complexes. Des guides d'installation et d'utilisation détaillés sont fournis pour permettre aux développeurs de démarrer rapidement.

Page d'accueil du grand modèle de la série Scholar·Puyu :

https://internlm.intern-ai.org.cn

Page d'accueil de ModelScope :

https://www.modelscope.cn/organization/Shanghai_AI_Laboratory?tab=model

Page d'accueil du visage câlin :

https://huggingface.co/internlm

Lien open source InternLM2.5 :

https://github.com/InternLM/InternLM

La version open source d'InternLM2.5 apporte de nouvelles possibilités à la recherche et aux applications dans le domaine de l'intelligence artificielle. On pense que ses performances puissantes et sa facilité d'utilisation inciteront de nombreux développeurs à explorer et à innover. L'éditeur de Downcodes attend avec impatience de voir d'autres excellentes applications basées sur InternLM2.5 !