La startup israélienne d'intelligence artificielle aiOla a publié un nouveau modèle de reconnaissance vocale open source Whisper-Medusa, qui est amélioré par rapport à Whisper d'OpenAI et est 50 % plus rapide. Il est open source sous la licence MIT sur Hugging Face et son utilisation commerciale est autorisée. L'éditeur de Downcodes vous donnera une explication détaillée de ce nouveau modèle accrocheur.

La startup israélienne d'intelligence artificielle aiOla a récemment fait un grand pas en avant et a annoncé le lancement d'un nouveau modèle open source de reconnaissance vocale Whisper-Medusa.

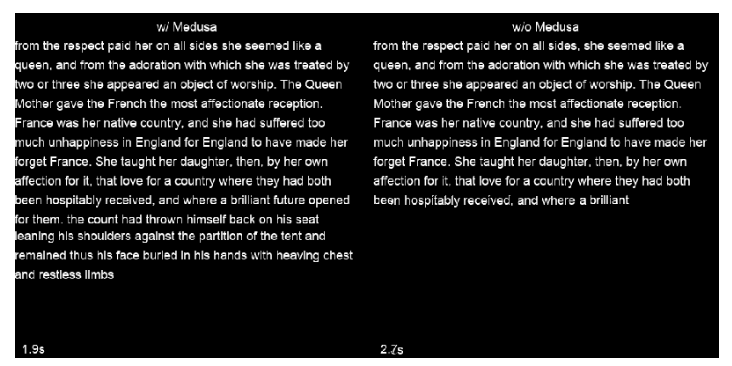

Ce modèle n'est pas simple. Il est 50 % plus rapide que le célèbre Whisper d'OpenAI ! Il est construit sur la base de Whisper, mais utilise une nouvelle architecture « d'attention multi-têtes » pour prédire le nombre de jetons à la fois, bien au-delà de celui d'OpenAI. produits. De plus, le code et les poids ont été publiés sur Hugging Face sous une licence MIT, qui permet la recherche et l'utilisation commerciale.

Gill Hetz, vice-présidente de la recherche chez aiOla, a déclaré que l'open source peut encourager l'innovation et la coopération communautaire, la rendant plus rapide et plus complète. Ces travaux pourraient ouvrir la voie à des systèmes d’intelligence artificielle complexes capables de comprendre et de répondre aux questions des utilisateurs presque en temps réel.

À une époque où les modèles de base peuvent produire une variété de contenus, la reconnaissance vocale avancée reste très importante. Whisper, par exemple, peut gérer des discours complexes dans différentes langues et accents. Il est téléchargé plus de 5 millions de fois par mois, prend en charge de nombreuses applications et est devenu la référence en matière de reconnaissance vocale.

Alors, qu’y a-t-il de si spécial à propos de Whisper-Medusa d’AiOla ?

La société a modifié la structure de Whisper et ajouté un mécanisme d'attention multi-têtes, qui peut prédire 10 jetons à la fois et augmenter la vitesse de 50 % sans affecter la précision. Une méthode d'apprentissage automatique faiblement supervisée a été utilisée pour entraîner ce modèle, et il y aura des versions plus puissantes à l'avenir. De plus, comme l'épine dorsale de Whisper-Medusa est construite sur Whisper, les améliorations de vitesse ne se feront pas au détriment des performances.

Lors de la formation de Whisper-Medusa, aiOla a utilisé une méthode d'apprentissage automatique appelée supervision faible. Dans ce cadre, il a gelé les principaux composants de Whisper et formé un module de prédiction de jetons supplémentaire en utilisant les transcriptions audio générées par le modèle comme étiquettes.

Lorsqu'on lui a demandé si des entreprises pourraient bénéficier d'un accès anticipé à Whisper-Medusa, Hetz a répondu qu'elles avaient été testées sur des cas d'utilisation réels de données d'entreprise et qu'elles pouvaient fonctionner avec précision dans des scénarios réels, rendant les applications vocales plus réactives à l'avenir. En fin de compte, il pense que l’augmentation des vitesses de reconnaissance et de transcription permettra des délais d’exécution plus rapides pour les applications vocales et ouvrira la voie à des réponses en temps réel.

Souligner:

50 % plus rapide : Whisper-Medusa d'aiOla est nettement plus rapide que la reconnaissance vocale Whisper d'OpenAI.

?Aucune perte de précision : La vitesse est améliorée tout en conservant la même précision que le modèle original.

Larges perspectives d'application : il devrait accélérer la réponse, améliorer l'efficacité et réduire les coûts des applications vocales.

Dans l'ensemble, le modèle Whisper-Medusa d'aiOla, avec son avantage en termes de vitesse et ses attributs open source, devrait déclencher une nouvelle vague dans le domaine de la reconnaissance vocale et apporter des améliorations significatives des performances à diverses applications vocales. L'éditeur de Downcodes continuera à prêter attention au développement ultérieur et aux contributions communautaires de ce modèle.