Google DeepMind s'est associé à un certain nombre d'universités pour développer une nouvelle méthode appelée Generative Reward Model (GenRM), qui vise à résoudre le problème de la précision et de la fiabilité insuffisantes de l'IA générative dans les tâches de raisonnement. Bien que les modèles d’IA générative existants soient largement utilisés dans des domaines tels que le traitement du langage naturel, ils génèrent souvent avec confiance des informations erronées, en particulier dans les domaines qui nécessitent une précision extrêmement élevée, ce qui limite leur champ d’application. L'innovation de GenRM consiste à redéfinir le processus de vérification en tant que tâche de prédiction du mot suivant, à intégrer les capacités de génération de texte des grands modèles de langage (LLM) dans le processus de vérification et à prendre en charge le raisonnement en chaîne, obtenant ainsi une vérification plus complète et systématique.

Récemment, l'équipe de recherche de Google DeepMind s'est associée à plusieurs universités pour proposer une nouvelle méthode appelée Generative Reward Model (GenRM), qui vise à améliorer la précision et la fiabilité de l'IA générative dans les tâches de raisonnement.

L’IA générative est largement utilisée dans de nombreux domaines comme le traitement du langage naturel. Elle génère principalement un texte cohérent en prédisant le mot suivant d’une série de mots. Cependant, ces modèles génèrent parfois des informations incorrectes, ce qui constitue un gros problème, en particulier dans les domaines où l'exactitude est essentielle, comme l'éducation, la finance et la santé.

Actuellement, les chercheurs ont essayé différentes solutions aux difficultés rencontrées par les modèles d’IA générative en matière de précision des résultats. Parmi eux, les modèles de récompense discriminants (RM) sont utilisés pour déterminer si les réponses potentielles sont correctes sur la base des scores, mais cette méthode ne parvient pas à utiliser pleinement les capacités génératives des grands modèles de langage (LLM). Une autre méthode couramment utilisée est le « LLM en tant que juge », mais cette méthode n'est souvent pas aussi efficace qu'un vérificateur professionnel pour résoudre des tâches de raisonnement complexes.

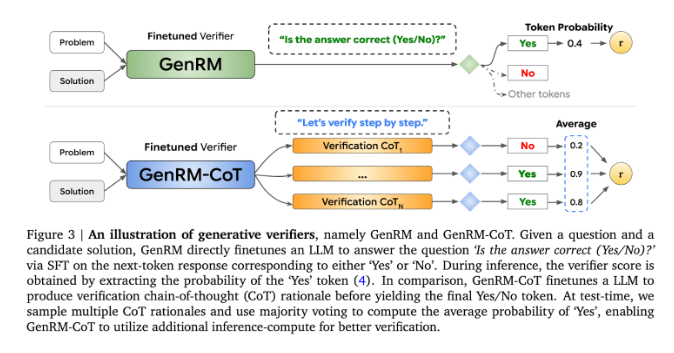

L'innovation de GenRM consiste à redéfinir le processus de vérification en tant que tâche de prédiction du mot suivant. Cela signifie que, contrairement aux modèles de récompense discriminants traditionnels, GenRM intègre les capacités de génération de texte des LLM dans le processus de vérification, permettant au modèle de générer et d'évaluer simultanément des solutions potentielles. De plus, GenRM prend également en charge le raisonnement chaîné (CoT), c'est-à-dire que le modèle peut générer des étapes de raisonnement intermédiaires avant d'arriver à la conclusion finale, rendant ainsi le processus de vérification plus complet et systématique.

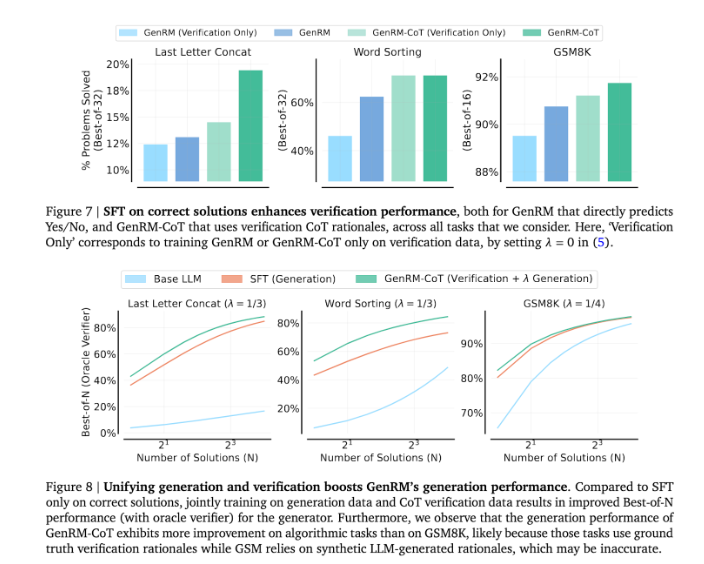

En combinant génération et validation, l'approche GenRM adopte une stratégie de formation unifiée qui permet au modèle d'améliorer simultanément les capacités de génération et de validation pendant la formation. Dans les applications réelles, le modèle génère des étapes d'inférence intermédiaires utilisées pour vérifier la réponse finale.

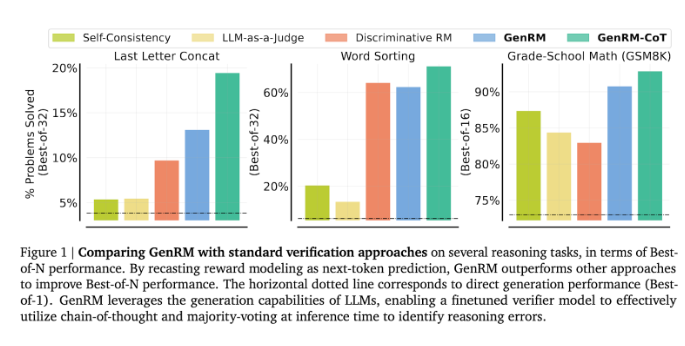

Les chercheurs ont constaté que le modèle GenRM fonctionnait bien lors de plusieurs tests rigoureux, tels qu'une précision considérablement améliorée dans les tâches de mathématiques préscolaires et de résolution de problèmes algorithmiques. Comparé au modèle de récompense discriminatoire et à la méthode LLM comme juge, le taux de réussite en résolution de problèmes de GenRM a augmenté de 16 % à 64 %.

Par exemple, lors de la vérification des résultats du modèle Gemini1.0Pro, GenRM a augmenté le taux de réussite en résolution de problèmes de 73 % à 92,8 %.

L'introduction de la méthode GenRM marque une avancée majeure dans le domaine de l'IA générative, améliorant considérablement la précision et la fiabilité des solutions générées par l'IA en unifiant la génération et la vérification des solutions en un seul processus.

Dans l’ensemble, l’émergence de GenRM fournit de nouvelles idées pour améliorer la fiabilité de l’IA générative. Son amélioration significative dans la résolution de problèmes de raisonnement complexes indique la possibilité d’appliquer l’IA générative dans davantage de domaines, ce qui mérite des recherches et des explorations plus approfondies.