Alibaba a annoncé qu'il ouvrirait en source son modèle de langage visuel de deuxième génération Qwen2-VL et fournirait des interfaces API et du code open source pour faciliter l'utilisation par les développeurs. Le modèle a fait des progrès significatifs dans la compréhension des images et des vidéos, prend en charge plusieurs langues et possède de solides capacités d'agent visuel, capables de faire fonctionner de manière autonome des téléphones mobiles et des robots. Qwen2-VL propose des modèles en trois tailles : 2B, 7B et 72B pour répondre aux besoins de différents scénarios d'application. Le modèle 72B fonctionne mieux sur la plupart des indicateurs, tandis que le modèle 2B est adapté aux applications mobiles.

Le 2 septembre, Tongyi Qianwen a annoncé l'open source de son modèle de langage visuel de deuxième génération Qwen2-VL et a lancé des API pour les tailles 2B et 7B ainsi que son modèle de version quantifiée sur la plateforme Alibaba Cloud Bailian que les utilisateurs peuvent appeler directement.

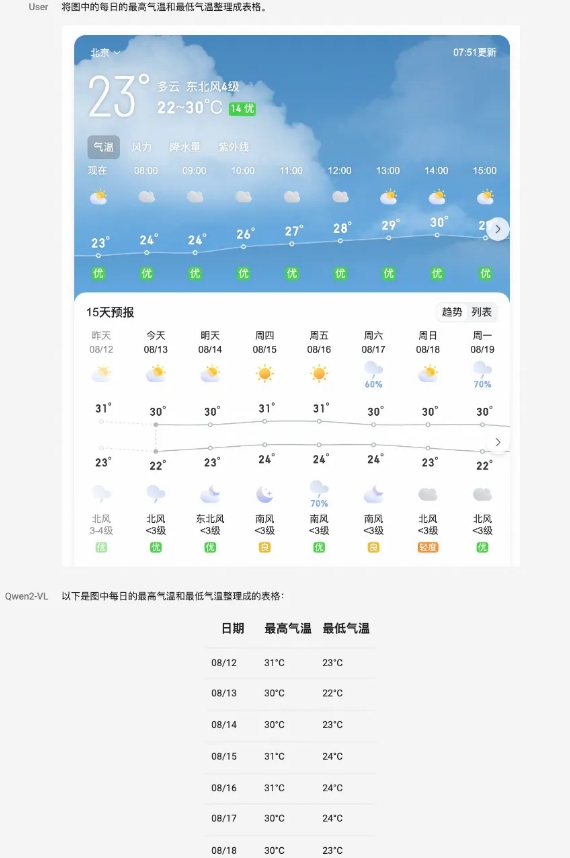

Le modèle Qwen2-VL permet d'obtenir des améliorations complètes des performances sous plusieurs aspects. Il peut comprendre des images de différentes résolutions et formats d'image et a atteint des performances de pointe dans les tests de référence tels que DocVQA, RealWorldQA et MTVQA. En outre, le modèle peut également comprendre de longues vidéos de plus de 20 minutes et prendre en charge les applications de questions-réponses, de dialogue et de création de contenu basées sur la vidéo. Qwen2-VL dispose également de puissantes capacités d’intelligence visuelle et peut faire fonctionner de manière autonome des téléphones mobiles et des robots pour effectuer des raisonnements et des prises de décision complexes.

Le modèle est capable de comprendre du texte multilingue dans des images et des vidéos, notamment le chinois, l'anglais, la plupart des langues européennes, le japonais, le coréen, l'arabe, le vietnamien, etc. L'équipe de Tongyi Qianwen a évalué les capacités du modèle sous six aspects, notamment les questions universitaires complètes, la capacité mathématique, la compréhension des documents, des tableaux, du texte et des images multilingues, les questions et réponses générales sur la scène, la compréhension des vidéos et les capacités des agents.

En tant que modèle phare, le Qwen2-VL-72B a atteint le niveau optimal dans la plupart des indicateurs. Qwen2-VL-7B atteint des performances hautement compétitives grâce à son échelle de paramètres économique, tandis que Qwen2-VL-2B prend en charge des applications mobiles riches et dispose de capacités complètes de compréhension multilingue des images et des vidéos.

En termes d'architecture de modèle, Qwen2-VL poursuit la structure en série de ViT plus Qwen2. Les trois tailles de modèles utilisent 600M ViT, prenant en charge l'entrée unifiée d'images et de vidéos. Afin d'améliorer la perception du modèle des informations visuelles et les capacités de compréhension vidéo, l'équipe a mis à niveau l'architecture, notamment en mettant en œuvre une prise en charge complète de la résolution dynamique native et en utilisant la méthode d'intégration de position de rotation multimodale (M-ROPE).

La plateforme Alibaba Cloud Bailian fournit l'API Qwen2-VL-72B, que les utilisateurs peuvent appeler directement. Dans le même temps, le code open source de Qwen2-VL-2B et Qwen2-VL-7B a été intégré dans Hugging Face Transformers, vLLM et d'autres frameworks tiers, et les développeurs peuvent télécharger et utiliser les modèles via ces plateformes.

Plateforme Alibaba Cloud Bailian :

https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api

GitHub :

https://github.com/QwenLM/Qwen2-VL

Visage câlin :

https://huggingface.co/collections/Qwen/qwen2-vl-66cee7455501d7126940800d

Portée du modèle magique :

https://modelscope.cn/organization/qwen?tab=model

Expérience modèle :

https://huggingface.co/spaces/Qwen/Qwen2-VL

En bref, l'open source du modèle Qwen2-VL fournit aux développeurs des outils puissants, favorise le développement de la technologie de modèle de langage visuel et apporte plus de possibilités à divers scénarios d'application. Les développeurs peuvent obtenir le modèle et le code via le lien fourni pour commencer à créer leurs propres applications.