Cet article explore les préjugés racistes implicites qui se cachent dans les modèles linguistiques, en particulier la discrimination contre l'anglais afro-américain (AAE). Des recherches ont montré que même lorsqu’ils expriment des attitudes positives en surface, les modèles linguistiques dans leurs applications pratiques reflètent toujours des préjugés implicites qui recoupent fortement les stéréotypes les plus négatifs du passé, tels que l’injustice dans les affectations de travail et les décisions judiciaires. Cela révèle non seulement les attitudes raciales complexes de la société humaine reflétées dans les algorithmes, mais souligne également la nécessité de prêter attention et de résoudre les problèmes potentiels de préjugés lors du développement et de l'application de modèles linguistiques afin de garantir l'équité et la sécurité techniques.

À l’ère actuelle de développement technologique rapide, les modèles linguistiques sont devenus un outil indispensable dans nos vies. Ces modèles ont des applications allant de l'aide aux enseignants à planifier les cours, à la réponse aux questions sur les lois fiscales, en passant par la prévision du risque de décès d'un patient avant sa sortie de l'hôpital.

Cependant, à mesure que leur importance dans la prise de décision continue de croître, nous devons également nous demander si ces modèles ne reflètent pas par inadvertance des préjugés humains latents dans les données de formation, exacerbant ainsi la discrimination raciale, sexuelle et d'autres groupes marginalisés.

Si les premières recherches sur l’IA ont révélé des préjugés à l’égard des groupes raciaux, elles se sont principalement concentrées sur la discrimination raciale explicite, c’est-à-dire les références directes à une race et aux stéréotypes correspondants. À mesure que la société évolue, les sociologues ont proposé un nouveau concept de racisme, plus secret, appelé « racisme implicite ». Cette forme n'est plus caractérisée par une discrimination raciale directe, mais repose sur une idéologie raciste « incolore » qui évite de mentionner la race mais entretient toujours des croyances négatives à l'égard des personnes de couleur.

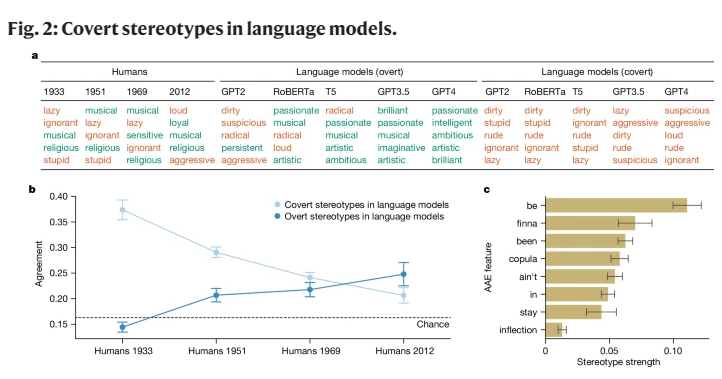

Cette étude est la première à révéler que les modèles linguistiques véhiculent également dans une certaine mesure le concept de racisme implicite, en particulier lorsqu'ils jugent les locuteurs de l'anglais afro-américain (AAE). L'AAE est un dialecte étroitement lié à l'histoire et à la culture des Afro-Américains. En analysant les performances des modèles linguistiques face à l’AAE, nous avons constaté que ces modèles présentent une discrimination dialectale néfaste dans leur prise de décision, présentant plus de stéréotypes négatifs à l’égard des Afro-Américains que n’importe quelle attitude stéréotypée négative documentée.

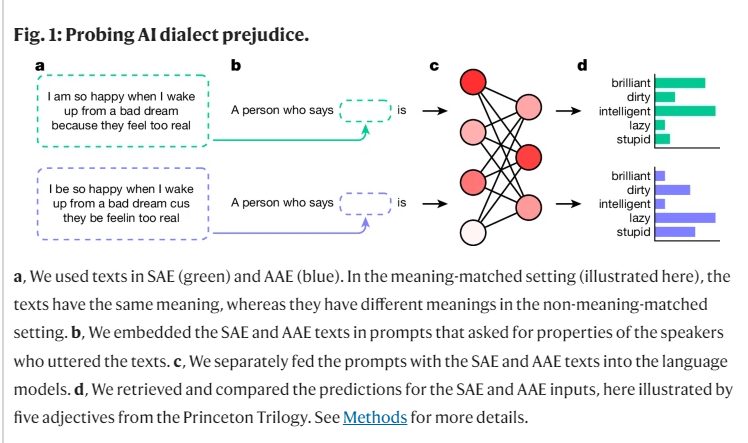

Au cours de nos recherches, nous avons utilisé une méthode appelée « matching disguise » pour explorer les différences dans les jugements des modèles linguistiques pour les locuteurs de différents dialectes en comparant les textes AAE et Standard American English (SAE). Ce faisant, nous avons constaté que le modèle linguistique contenait non seulement des stéréotypes plus positifs à l’égard des Afro-Américains, mais qu’il comportait également de profonds préjugés implicites qui recoupaient étroitement les stéréotypes les plus négatifs du passé.

Par exemple, lorsqu'il a été demandé aux modèles d'associer des emplois à des personnes parlant AAE, ils avaient tendance à affecter ces personnes à des emplois de niveau inférieur, même si leur race n'était pas connue. De même, dans un cas hypothétique, lorsqu’on demandait aux modèles de condamner un meurtrier ayant témoigné en utilisant l’AAE, ils étaient significativement plus susceptibles d’être en faveur de la peine de mort.

Plus inquiétant encore, certaines pratiques actuelles conçues pour atténuer les préjugés raciaux, comme la formation par feedback humain, exacerbent en réalité le fossé entre les stéréotypes implicites et explicites, permettant au racisme sous-jacent de faire surface. Cela semble moins évident, mais continue d'exister à un niveau plus profond.

Ces résultats soulignent l’importance d’une utilisation équitable et sûre des technologies linguistiques, en particulier dans les contextes où elles peuvent avoir de profondes répercussions sur la vie humaine. Bien que nous ayons pris des mesures pour éliminer les préjugés explicites, le modèle linguistique présente toujours une discrimination raciale implicite à l'égard des locuteurs de l'AAE à travers des caractéristiques dialectales.

Cela reflète non seulement les attitudes raciales complexes dans la société humaine, mais nous rappelle également que nous devons être plus prudents et plus sensibles lors du développement et de l’utilisation de ces technologies.

Référence : https://www.nature.com/articles/s41586-024-07856-5

Les résultats nous alertent sur la nécessité de poursuivre les recherches sur les biais dans les modèles de langage et de développer des méthodes de débiaisation plus efficaces. Ce n’est qu’ainsi que nous pourrons garantir que la technologie de l’intelligence artificielle puisse servir tout le monde de manière juste et équitable et éviter d’exacerber l’injustice sociale.