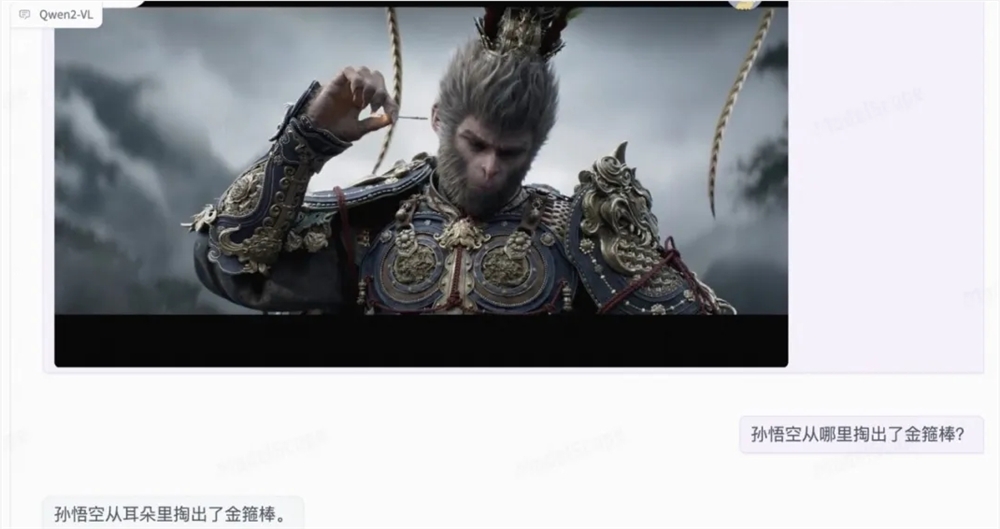

Alibaba Damo Academy a publié une mise à jour majeure de son modèle de langage multimodal à grande échelle Qwen2-VL le 30 août 2024. Cette mise à jour apporte des avancées significatives dans la compréhension des images, le traitement vidéo et la prise en charge multilingue et établit de nouvelles références de performances. Le modèle Qwen2-VL améliore non seulement la compréhension des informations visuelles, mais dispose également de capacités avancées de compréhension vidéo et de fonctions d'agent de visualisation intégrées, lui permettant d'effectuer un raisonnement et une prise de décision plus complexes. De plus, la prise en charge multilingue étendue facilite son utilisation à l’échelle mondiale.

Le modèle Qwen2-VL a réalisé des améliorations significatives en termes de compréhension des images, de traitement vidéo et de prise en charge multilingue, établissant ainsi une nouvelle référence pour les indicateurs de performance clés. Les nouvelles fonctionnalités du modèle Qwen2-VL incluent des capacités améliorées de compréhension des images qui permettent une compréhension et une interprétation plus précises des informations visuelles ; des capacités avancées de compréhension vidéo qui permettent au modèle d'analyser le contenu vidéo dynamique en temps réel et des capacités d'agent de visualisation intégrées qui transforment le modèle ; en un agent puissant pour le raisonnement et la prise de décision complexes ; et une prise en charge multilingue étendue, le rendant plus accessible et efficace dans différents environnements linguistiques.

En termes d'architecture technique, Qwen2-VL implémente un support de résolution dynamique et peut traiter des images de n'importe quelle résolution sans les diviser en blocs, garantissant ainsi la cohérence entre l'entrée du modèle et les informations inhérentes à l'image. De plus, l'innovation de l'intégration de position rotative multimodale (M-ROPE) permet au modèle de capturer et d'intégrer simultanément du texte 1D, une vision 2D et des informations de position vidéo 3D.

Le modèle Qwen2-VL-7B conserve avec succès la prise en charge des entrées image, multi-images et vidéo à l'échelle 7B, et fonctionne bien dans les tâches de compréhension de documents et de compréhension de texte multilingue basée sur des images.

Dans le même temps, l'équipe a également lancé un modèle 2B optimisé pour le déploiement mobile. Bien que le nombre de paramètres ne soit que de 2B, il fonctionne bien en termes de compréhension d'images, de vidéos et de plusieurs langues.

Lien du modèle :

Qwen2-VL-2B-Instruct :https://www.modelscope.cn/models/qwen/Qwen2-VL-2B-Instruct

Qwen2-VL-7B-Instruct :https://www.modelscope.cn/models/qwen/Qwen2-VL-7B-Instruct

La mise à jour du modèle Qwen2-VL marque une nouvelle avancée dans la technologie des modèles de langage multimodaux à grande échelle. Ses puissantes capacités de traitement d'image, de vidéo et multilingue offrent de larges perspectives pour les applications futures. Le lancement de deux versions, 7B et 2B, offre également des options plus flexibles pour différents scénarios d'application.