Anthropic a récemment lancé une nouvelle fonctionnalité de la série Claude de modèles de langage à grande échelle - répandait le cache pour réduire le coût de l'utilisation de l'IA et améliorer les performances. Cette décision est considérée comme une stratégie unique d'Anthropic en rivalisant avec des géants tels que OpenAI, Google et Microsoft pour choisir d'accroître l'efficacité et de réduire les perspectives de coûts. Cette fonction est actuellement testée publiquement sur l'API du modèle Claude3.5 Sonnet et Claude3 Haiku, promettant de réduire le coût allant jusqu'à 90% et d'augmenter la vitesse de réponse de certains scénarios d'application. Cependant, l'effet réel nécessite encore une inspection du marché.

Le 14 août, Anthropic a annoncé qu'il avait lancé une nouvelle fonctionnalité appelée le modèle de grande langue de la série Claude, affirmant qu'elle peut réduire considérablement le coût de l'IA et améliorer les performances. Mais si cette fonction peut être aussi magique que la société l'a dit et doit être testée sur le marché.

La fonction de cache sera testée publiquement sur son API de son modèle Claude3.5SONNet et Claude3Haiku. Cette fonction permet aux utilisateurs de stocker et de réutiliser des informations de contexte spécifiques, y compris des instructions et des données complexes, sans coûts supplémentaires ni retards accrus. Le porte-parole de la société a déclaré que c'était l'une des nombreuses caractéristiques de coupe qu'ils ont développées pour améliorer les capacités de Claude.

À l'heure actuelle, les géants technologiques tels qu'Openai, Google et Microsoft ont lancé des compétitions féroces dans le domaine des modèles de langage à grande échelle, et chaque entreprise essaie d'améliorer les performances et la compétitivité du marché de leurs produits. Dans cette concurrence, Anthropic a choisi de couper du point de vue de l'amélioration de l'efficacité de l'utilisation et de la réduction des coûts, montrant sa stratégie de marché unique.

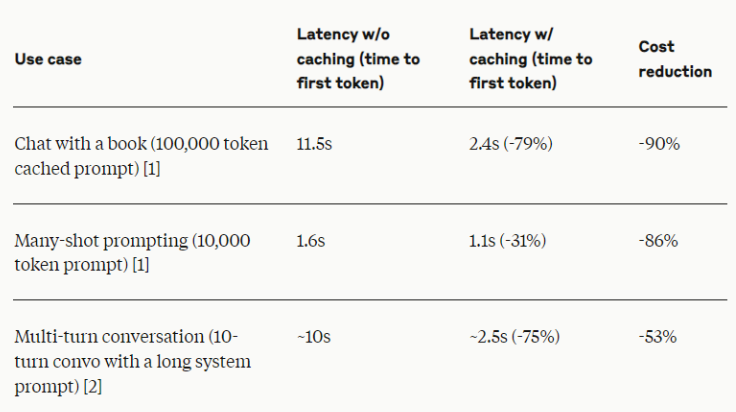

Selon Anthropic, cette nouvelle fonctionnalité peut rapporter jusqu'à 90% du coût et doubler la vitesse de réponse dans certains scénarios d'application. Ces chiffres sont sans aucun doute impressionnants, mais les experts de l'industrie rappellent que l'effet réel peut être différent en raison des scénarios d'application spécifiques et de la mise en œuvre.

Anthropic a déclaré que la fonction de cache est particulièrement adaptée aux scènes qui doivent être cohérentes dans le contexte dans plusieurs requêtes ou sessions, telles que le dialogue à long terme, le traitement de documents à grande échelle, l'assistance au code et les outils complexes. Cette méthode devrait apporter une amélioration de l'efficacité à diverses applications d'IA commerciales.

Les initiés de l'industrie ont souligné que bien que les nouvelles fonctionnalités d'Anthropic semblent brillantes, d'autres sociétés d'IA explorent également activement la méthode d'amélioration de l'efficacité du modèle et de réduction des coûts d'utilisation. Par exemple, OpenAI offre différentes capacités et options de modèles de prix, tandis que Google s'engage à développer des modèles qui peuvent fonctionner efficacement sur le matériel ordinaire.

Pour l'effet réel de cette nouvelle fonctionnalité, le marché est toujours prudent. Comme toute nouvelle technologie, en particulier dans le domaine de l'IA en développement rapide, les performances de la fonction de cache dans le monde réel n'ont pas encore été observées. Anthropic a déclaré qu'il travaillera en étroite collaboration avec les clients pour collecter des données et des commentaires pertinents, ce qui est conforme aux meilleures pratiques de l'industrie qui évalue l'influence de la nouvelle technologie d'IA.

L'initiative d'Anthropic peut avoir un large impact sur l'industrie de l'IA, en particulier en fournissant des capacités d'IA avancées aux PME. Si cette fonction est vraiment aussi efficace que la promotion, elle peut réduire le seuil pour que les entreprises adoptent des solutions d'IA complexes, favorisant ainsi l'application de la technologie d'IA dans un domaine commercial plus large.

Avec le développement de tests publics, les entreprises et les développeurs auront la possibilité d'évaluer personnellement les performances réelles de la fonction de cache et comment elle s'adapte à leurs stratégies d'IA respectives. Au cours des prochains mois, nous devons voir les performances de cette invite d'IA de gestion et le contexte dans les applications pratiques.

La fonction de cache rapide d'Anthropic représente une tentative intéressante de l'industrie de l'IA en termes d'efficacité et d'optimisation des coûts. Cependant, si cela peut vraiment conduire le changement de l'industrie, il nécessite également une inspection plus approfondie du marché. Dans tous les cas, cette innovation reflète l'exploration continue des nouvelles directions dans les entreprises d'IA dans une concurrence féroce, et indique également que la technologie de l'IA peut inaugurer un nouveau cycle de révolution efficace.

Dans l'ensemble, la clé du succès de la fonction de cache invite anthropique est son effet d'application réel. La performance du marché ultérieure deviendra la norme ultime pour tester cette technologie et apportera également une nouvelle révélation à l'ensemble de l'industrie de l'IA.