Les progrès des grands modèles de langage (LLM) sont impressionnants, mais ils présentent des lacunes inattendues sur certains problèmes simples. Andrej Karpathy a souligné avec acuité ce phénomène d'"intelligence irrégulière", c'est-à-dire que LLM est capable d'accomplir des tâches complexes, mais commet fréquemment des erreurs sur des problèmes simples. Cela a déclenché une réflexion approfondie sur les défauts essentiels du LLM et les orientations d'amélioration futures. Cet article expliquera cela en détail et explorera comment mieux utiliser le LLM et éviter ses limites.

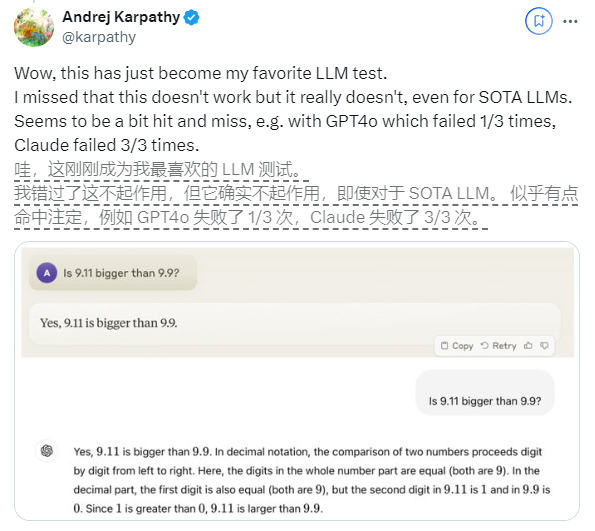

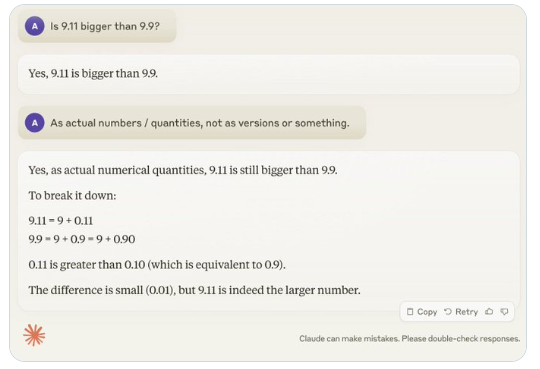

Récemment, une question apparemment simple : « 9.11 est-il plus grand que 9.9 ? » a attiré l'attention dans le monde entier. Presque tous les grands modèles de langage (LLM) ont commis des erreurs sur cette question. Ce phénomène a attiré l'attention d'Andrej Karpathy, un expert dans le domaine de l'IA. À partir de cette question, il a discuté en profondeur des défauts essentiels et des orientations futures d'amélioration de la technologie actuelle des grands modèles.

Karpathy appelle ce phénomène « intelligence irrégulière » ou « intelligence irrégulière », soulignant que même si les LLM de pointe peuvent effectuer une variété de tâches complexes, telles que la résolution de problèmes mathématiques difficiles, ils échouent dans certaines tâches apparemment simples. fonctionne mal face aux problèmes, et ce déséquilibre de l’intelligence est semblable à la forme d’une dent de scie.

Par exemple, le chercheur d'OpenAI Noam Brown a découvert que LLM fonctionnait mal dans le jeu de Tic-Tac-Toe, le modèle étant incapable de prendre les bonnes décisions même lorsque l'utilisateur était sur le point de gagner. Karpathy pense que cela est dû au fait que le modèle prend des décisions « injustifiées », tandis que Noam pense que cela peut être dû à un manque de discussion pertinente sur les stratégies dans les données d'entraînement.

Un autre exemple est l'erreur commise par LLM lors du comptage de quantités alphanumériques. Même la dernière version de Llama 3.1 donne de mauvaises réponses à des questions simples. Karpathy a expliqué que cela découle du manque de « connaissance de soi » du LLM, c'est-à-dire que le modèle ne peut pas distinguer ce qu'il peut et ne peut pas faire, ce qui fait que le modèle est « confiant » face aux tâches.

Pour résoudre ce problème, Karpathy a mentionné la solution proposée dans l'article Llama3.1 publié par Meta. L'article recommande d'aligner le modèle au cours de la phase post-formation afin que le modèle développe une conscience de soi et sache ce qu'il sait. Le problème de l'illusion ne peut pas être éradiqué simplement en ajoutant des connaissances factuelles. L'équipe Llama a proposé une méthode de formation appelée « détection des connaissances », qui encourage le modèle à répondre uniquement aux questions qu'il comprend et refuse de générer des réponses incertaines.

Karpathy estime que même si les capacités actuelles de l'IA présentent divers problèmes, ceux-ci ne constituent pas des défauts fondamentaux et il existe des solutions réalisables. Il a proposé que l'idée actuelle de la formation en IA consiste simplement à « imiter les étiquettes humaines et à élargir l'échelle ». Pour continuer à améliorer l'intelligence de l'IA, davantage de travail doit être effectué sur l'ensemble de la pile de développement.

Jusqu'à ce que le problème soit complètement résolu, si les LLM doivent être utilisés en production, ils doivent être limités aux tâches pour lesquelles ils sont bons, être conscients des « bords irréguliers » et maintenir les humains impliqués à tout moment. De cette manière, nous pouvons mieux exploiter le potentiel de l’IA tout en évitant les risques provoqués par ses limites.

Dans l’ensemble, « l’intelligence irrégulière » du LLM constitue un défi auquel est actuellement confronté le domaine de l’IA, mais il n’est pas insurmontable. En améliorant les méthodes de formation, en renforçant la conscience de soi du modèle et en l'appliquant soigneusement à des scénarios réels, nous pouvons mieux exploiter les avantages du LLM et promouvoir le développement continu de la technologie de l'intelligence artificielle.