Le laboratoire d'intelligence artificielle de Shanghai a récemment annoncé que le grand modèle multimodal InternLM-XComposer développé par lui avait été mis à niveau vers la version 2.5 (IXC-2.5). Cette version a réalisé des avancées majeures dans la compréhension du contexte long, la compréhension du langage visuel et l'expansion des applications, a considérablement amélioré les capacités de compréhension et de création d'images de texte et a surpassé les modèles open source existants dans plusieurs tests de référence. Certains indicateurs sont même comparables à GPT-4V et Gemini Pro. est comparable. IXC-2.5 présente de solides performances et un large potentiel d'application, établissant une nouvelle référence pour le développement de grands modèles multimodaux.

Récemment, le grand modèle multimodal InternLM-XComposer a été mis à niveau vers la version 2.5. Ce modèle, développé par le laboratoire d'intelligence artificielle de Shanghai, a amélioré la compréhension du texte et des images grâce à ses excellentes capacités d'entrée et de sortie de contexte long et à ses applications créatives. avancées révolutionnaires.

IXC-2.5 est capable de gérer facilement des contextes longs jusqu'à 96 Ko, grâce aux données image-texte entrelacées de 24 Ko utilisées dans sa formation. Cette capacité de contexte long permet à IXC-2.5 de bien fonctionner dans les tâches qui nécessitent un contexte d'entrée et de sortie étendu.

Par rapport à la version précédente, IXC-2.5 comporte trois améliorations majeures dans la compréhension du langage visuel :

Compréhension de l'ultra haute résolution : IXC-2.5 prend en charge les images haute résolution de n'importe quel rapport d'aspect via l'encodeur visuel natif 560 × 560ViT.

Compréhension vidéo fine : traitez la vidéo comme une image composite ultra haute résolution composée de dizaines à des centaines d'images, capturant les détails grâce à un échantillonnage dense et une résolution plus élevée.

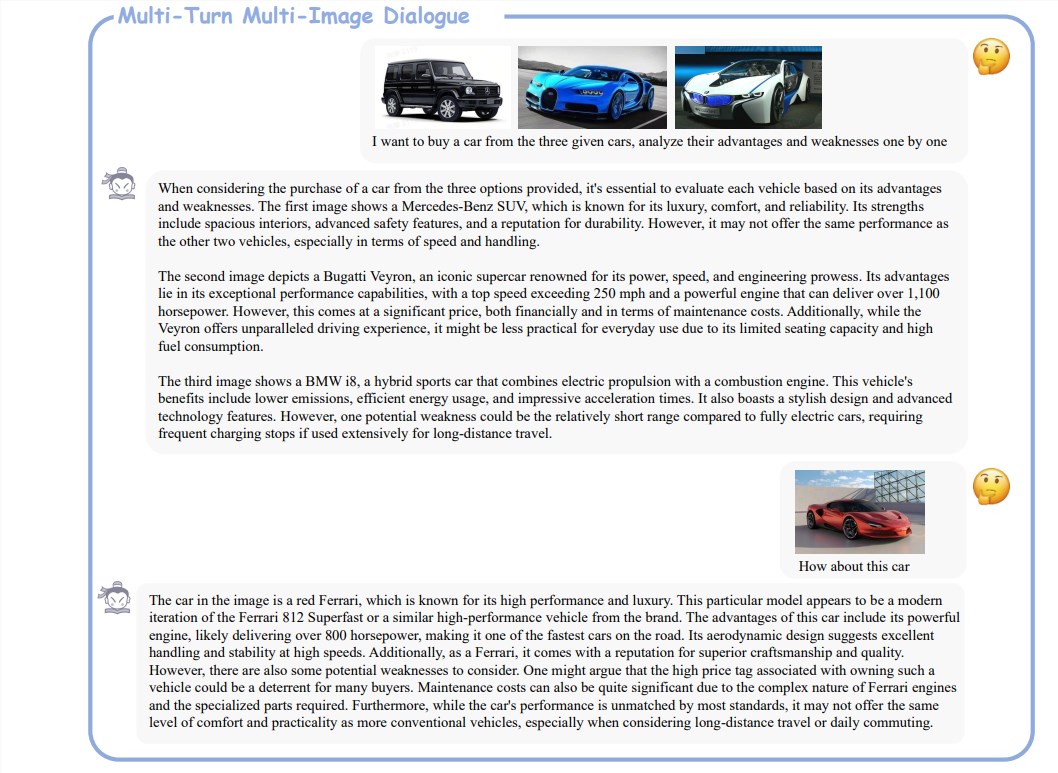

Dialogue multi-tours et multi-images : prend en charge le dialogue multi-tours et multi-images de forme libre pour une interaction naturelle avec les humains.

En plus d'améliorer la compréhension, IXC-2.5 étend également deux applications intéressantes en utilisant des paramètres LoRA supplémentaires pour la création d'images texte :

Créer des pages Web : sur la base d'instructions d'image texte, IXC-2.5 peut écrire des codes sources HTML, CSS et JavaScript pour créer des pages Web.

Rédigez des articles graphiques de haute qualité : utilisez les technologies de chaîne de pensée (CoT) et d'optimisation des préférences directes (DPO) spécialement conçues pour améliorer considérablement la qualité de votre contenu d'écriture.

IXC-2.5 est évalué sur 28 benchmarks et surpasse les modèles open source de pointe existants sur 16 benchmarks. De plus, il a égalé ou dépassé GPT-4V et Gemini Pro dans 16 tâches clés. Cette réalisation prouve pleinement les performances puissantes et le large potentiel d’application de l’IXC-2.5.

Adresse papier : https://arxiv.org/pdf/2407.03320

Adresse du projet : https://github.com/InternLM/InternLM-XComposer

Dans l'ensemble, la sortie de la version IXC-2.5 marque un progrès significatif dans la technologie multimodale des grands modèles, et ses performances puissantes et ses riches scénarios d'application indiquent un avenir radieux pour le développement de la technologie de l'intelligence artificielle à l'avenir. Dans l’attente de mises à jour de fonctionnalités de plus en plus puissantes à l’avenir !