Le robot d'exploration Web ClaudeBot utilisé par Anthropic a fréquemment visité le site Web d'iFixit sur une période de 24 heures, semblant enfreindre les conditions d'utilisation de l'entreprise.

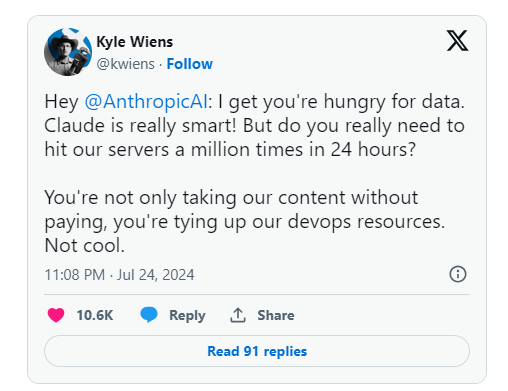

Le PDG d'iFixit, Kyle Wiens, a déclaré que non seulement cette utilisation non autorisée du contenu était également une utilisation de leurs ressources de développement. En réponse à cela, Fixit a ajouté une extension de délai d'exploration au robots.txt pour restreindre l'accès des robots.

En plus d'iFixit, Eric Holscher, co-fondateur de Read the Docs, et Matt Barrie, PDG de Freelancer.com, ont également signalé que leurs sites Web avaient été envahis par le robot d'exploration Anthropic.

Au cours des mois précédents, les publications sur Reddit ont signalé une forte augmentation de l'activité de web scraping d'Anthropic. En avril de cette année, une panne du site sur le forum Web Linux Mint a également été attribuée à l'activité d'exploration de ClaudeBot.

De nombreuses sociétés d'IA comme OpenAI refusent l'accès des robots via les fichiers robots.txt, mais cela ne donne pas aux propriétaires de sites Web la possibilité de définir de manière flexible quel contenu d'exploration est autorisé et interdit. Il a été constaté qu’une autre société d’IA, Perplexity, ignorait complètement les règles d’exclusion du fichier robots.txt.

Pourtant, il s’agit de l’une des rares options dont disposent de nombreuses entreprises pour protéger les données contre leur utilisation pour le matériel de formation en IA, et Reddit a également récemment pris des mesures contre les robots d’exploration du Web.