Que se passerait-il si l'IA était recyclée à l'aide des images qu'elle génère ? Récemment, des chercheurs de l'Université de Stanford et de l'Université de Californie à Berkeley ont mené une telle expérience et les résultats ont été surprenants.

Les chercheurs ont découvert que lorsque les modèles générateurs d’images d’IA étaient recyclés pour utiliser les images qu’ils généraient eux-mêmes, les modèles produisaient des images très déformées. Pire encore, cette distorsion ne se limite pas aux indices textuels utilisés pour le recyclage. Une fois le modèle « contaminé », il est difficile pour le modèle de récupérer complètement, même s'il est ensuite recyclé avec uniquement des images réelles.

Le point de départ de l’expérience est un modèle open source appelé Stable Diffusion (SD). Les chercheurs ont d’abord sélectionné 70 000 images de visages de haute qualité dans l’ensemble de données faciales FFHQ et les ont automatiquement classées. Ils ont ensuite utilisé ces images réelles comme entrée pour générer 900 images cohérentes avec les caractéristiques d’un groupe spécifique de personnes grâce au modèle de diffusion stable.

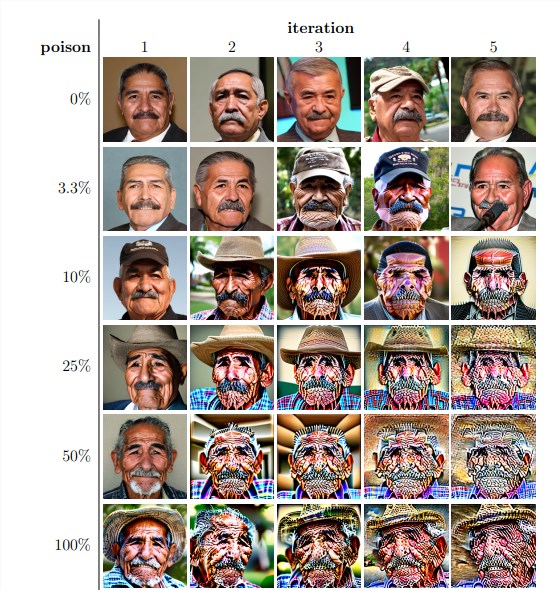

Ensuite, les chercheurs ont utilisé ces images générées pour le recyclage itératif du modèle. Ils ont constaté que quelle que soit la proportion d’images auto-générées dans l’ensemble de données de recyclage, le modèle finissait par s’effondrer et la qualité des images générées diminuait considérablement. Même lorsque les données de recyclage ne contiennent que 3 % d’images auto-générées, le phénomène d’effondrement du modèle existe toujours.

Les résultats expérimentaux montrent que la version de base du modèle de diffusion stable génère des images cohérentes avec les indices textuels et présentant une qualité visuelle élevée. Mais à mesure que le modèle était recyclé de manière itérative, les images générées ont commencé à présenter des incohérences sémantiques et des distorsions visuelles. Les chercheurs ont également constaté que l’effondrement du modèle affectait non seulement la qualité des images, mais entraînait également un manque de diversité dans les images générées.

Pour vérifier cela, les chercheurs ont également mené des expériences contrôlées pour tenter d'atténuer l'impact de l'effondrement du modèle en ajustant l'histogramme des couleurs des images générées et en supprimant les images de mauvaise qualité. Mais les résultats montrent que ces mesures ne sont pas efficaces pour empêcher l’effondrement du modèle.

Les chercheurs ont également étudié s'il était possible pour un modèle de récupérer grâce à une reconversion après avoir été « contaminé ». Ils ont constaté que même si, dans certains cas, la qualité des images résultantes s'est rétablie après plusieurs itérations de recyclage, des signes d'effondrement du modèle subsistaient. Cela montre qu’une fois qu’un modèle est « contaminé », les effets peuvent être à long terme, voire irréversibles.

Cette étude révèle un problème important : les systèmes d’IA de génération de texte en image basés sur la diffusion, actuellement populaires, sont très sensibles à la « contamination » des données. Cette « contamination » peut se produire involontairement, par exemple en récupérant sans discernement des images de sources en ligne. Il peut également s'agir d'une attaque ciblée, telle que le placement délibéré de données « altérées » sur un site Web.

Face à ces défis, les chercheurs ont proposé quelques solutions possibles, comme l'utilisation de détecteurs d'authenticité d'image pour exclure les images générées par l'IA, ou l'ajout de filigranes aux images générées. Bien qu’imparfaites, ces méthodes combinées peuvent réduire considérablement le risque de « contamination » des données.

Cette étude rappelle que le développement de la technologie de l’IA n’est pas sans risques. Nous devons être plus prudents avec le contenu généré par l’IA pour garantir qu’il n’a pas d’impact négatif à long terme sur nos modèles et ensembles de données. Les recherches futures doivent explorer davantage comment rendre les systèmes d’IA plus résilients à ce type de « contamination » des données ou développer des techniques susceptibles d’accélérer la « guérison » des modèles.