Après que Meta ait publié Llama 3.1, Mistral AI a lancé le modèle phare Mistral Large 2, avec un volume de paramètres de 123 milliards, une fenêtre contextuelle étonnante de 128k et des performances comparables à Llama 3.1. Le modèle prend en charge plusieurs langages et langages de programmation, est conçu pour l'inférence à nœud unique, est efficace et économique. Cet article examinera en profondeur les différents indicateurs de performance, les méthodes d'utilisation et ses excellentes performances en matière de traitement multilingue, de compréhension du code et de suivi des instructions de Mistral Large 2, et analysera son potentiel dans les applications commerciales et la recherche.

Suite à l'annonce hier par Meta de la sortie du modèle open source le plus puissant, Llama3.1, Mistral AI a lancé en grande pompe son modèle phare Mistral Large2 tôt ce matin. Ce nouveau produit possède 123 milliards de paramètres et une grande fenêtre contextuelle de 128k. comparable à Llama3.1.

Détails du modèle Mistral Large2

Mistral Large2 dispose d'une fenêtre contextuelle de 128 000 et prend en charge des dizaines de langues, dont le français, l'allemand, l'espagnol, l'italien, le portugais, l'arabe, l'hindi, le russe, le chinois, le japonais et le coréen, ainsi que Python, Java, C, C++, plus de 80 langages de codage dont JavaScript et Bash.

Mistral Large2 est conçu pour l'inférence à nœud unique, ciblant principalement les applications à contexte long : sa taille de 123 milliards de paramètres lui permet de s'exécuter à haut débit sur un seul nœud. Mistral Large2 est publié sous la licence Mistral Research et est destiné à la recherche et à une utilisation non commerciale. S'il existe un besoin commercial, les utilisateurs doivent contacter pour obtenir une licence commerciale.

Performance globale :

En termes de performance, Mistral Large2 a établi une nouvelle référence en matière d'indicateurs d'évaluation, en atteignant notamment une précision de 84,0% dans le test de référence MMLU, démontrant un solide équilibre entre performance et coût du service.

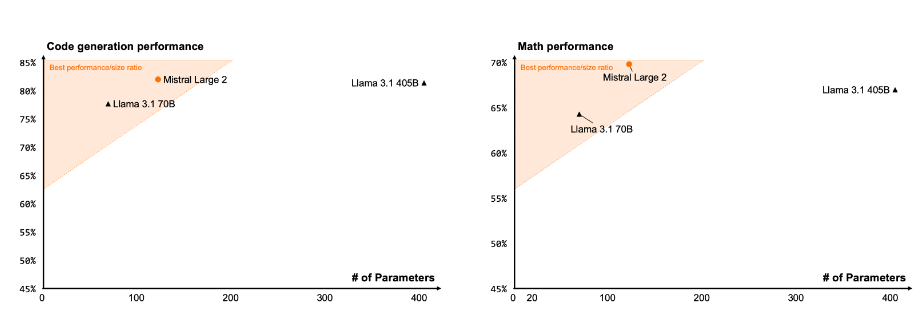

Code et raisonnement

Grâce à son expérience de formation avec Codestral22B et Codestral Mamba, Mistral Large2 fonctionne parfaitement dans le traitement du code, rivalisant même avec les meilleurs modèles tels que GPT-4o, Claude3Opus et Llama3405B.

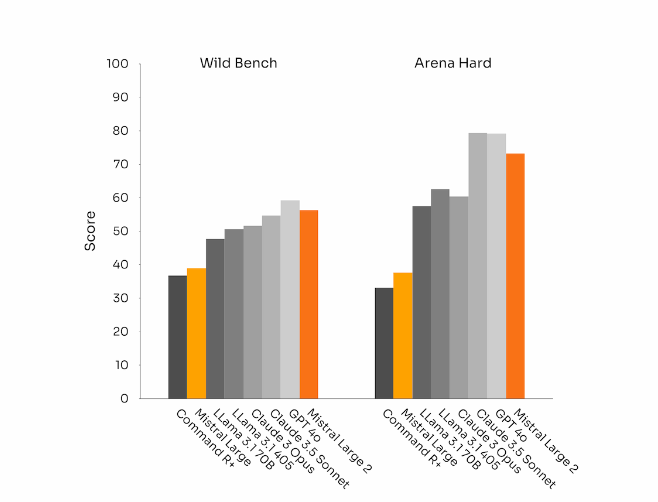

Conformité et alignement des instructions

Mistral Large 2 a également réalisé des progrès significatifs en matière de suivi de commandes et de capacités de dialogue, notamment lors de la gestion de dialogues complexes et multitours avec une plus grande flexibilité. Dans certains benchmarks, générer des réponses plus longues a tendance à améliorer les scores. Cependant, dans de nombreuses applications commerciales, la simplicité est cruciale : une génération de modèles plus courte permet des interactions plus rapides et rend l'inférence plus rentable.

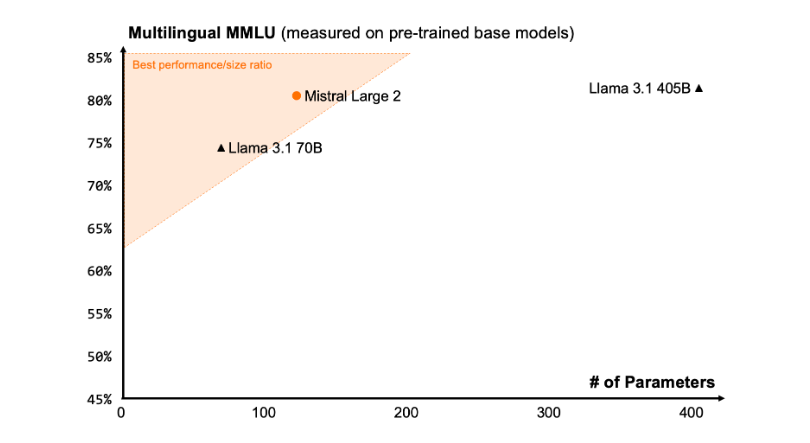

diversité linguistique

Le nouveau Mistral Large2 est formé sur de grandes quantités de données multilingues, notamment en anglais, français, allemand, espagnol, italien, portugais, néerlandais, russe, chinois, japonais, coréen, arabe et hindi. Excellentes performances. Vous trouverez ci-dessous les résultats de performances de Mistral Large2 sur le benchmark multilingue MMLU, par rapport aux précédents modèles Mistral Large, Llama3.1 et Command R+ de Cohere.

Utilisation des outils et appels de fonctions

Mistral Large2 est équipé de compétences améliorées en matière d'appel et de récupération de fonctions et est formé pour exécuter de manière experte des appels de fonctions parallèles et séquentiels, ce qui lui permet de servir de centrale pour les applications métier complexes.

Comment utiliser :

Actuellement, les utilisateurs peuvent utiliser Mistral Large2 sous le nom mistral-large-2407 à la Plateforme (https://console.mistral.ai/) et testé sur le Chat. Il est disponible en version 24.07 (le système de contrôle de version YY.MM que nous appliquons à tous les modèles) et sous le nom API mistral-large-2407 . Les poids du modèle d'instruction sont disponibles et sont également hébergés sur HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407).

Les produits présents sur La Plateforme comprennent deux modèles universels, Mistral Nemo et Mistral Large, et deux modèles professionnels, Codestral et Embed. Alors que nous supprimons progressivement les anciens modèles sur La Plateforme, tous les modèles Apache (Mistral7B, Mixtral8x7B et 8x22B, Codestral Mamba, Mathstral) peuvent toujours être déployés et peaufinés à l'aide des SDK mistral-inference et mistral-finetune.

À partir d'aujourd'hui, le produit étendra les capacités de réglage fin à la Plateforme : ces capacités sont désormais disponibles pour Mistral Large, Mistral Nemo et Codestral.

Mistral AI s'est également associé à plusieurs grands fournisseurs de services cloud pour rendre Mistral Large2 disponible dans le monde entier, notamment dans Vertex AI sur Google Cloud Platform.

** Points forts: **

Mistral Large2 dispose de 128 000 fenêtres contextuelles et prend en charge jusqu'à dix langages et plus de 80 langages de programmation.

Atteindre une précision de 84,0 % dans le test de référence MMLU, avec d'excellentes performances et coûts.

« Les utilisateurs peuvent accéder à de nouveaux modèles via La Plateforme et sont largement utilisés sur les plateformes de services cloud.

Dans l'ensemble, Mistral Large 2 a démontré une forte compétitivité dans le domaine des grands modèles de langage grâce à ses performances puissantes, sa prise en charge linguistique étendue et sa commodité d'utilisation, offrant de nouvelles possibilités pour la recherche et les applications commerciales. Sa nature open source favorise également le développement innovant dans le domaine de l’IA.