L'équipe d'Alibaba Qwen a publié un nouveau benchmark appelé « PROCESSBENCH », qui vise à évaluer de manière plus complète la capacité des modèles de langage en matière de raisonnement mathématique, avec un accent particulier sur la capacité du modèle à identifier les erreurs de processus. Les tests de référence existants présentent des limites, par exemple parce qu'ils sont trop simplistes pour des modèles de haut niveau ou qu'ils ne fournissent que des évaluations d'exactitude binaires, sans analyse détaillée des étapes d'erreur. L'émergence de "PROCESSBENCH" comble cette lacune et fournit un nouvel outil pour une compréhension plus approfondie et une amélioration du mécanisme de raisonnement des modèles de langage.

Récemment, des chercheurs de l'équipe Qwen d'Alibaba ont lancé un nouveau benchmark appelé « PROCESSBENCH », conçu pour mesurer la capacité des modèles de langage à identifier les erreurs de processus dans le raisonnement mathématique. Alors que les modèles de langage ont fait des progrès significatifs dans des tâches de raisonnement complexes, les chercheurs dans ce domaine ont constaté que malgré leurs excellentes performances, ils sont encore confrontés à des défis dans la résolution de certains problèmes difficiles. Il est donc particulièrement important de développer une méthode de supervision efficace.

Les critères d'évaluation actuels des modèles de langage présentent certaines lacunes. D'une part, certains ensembles de problèmes deviennent trop simples pour les modèles avancés, et d'autre part, les méthodes d'évaluation existantes ne fournissent souvent que des évaluations d'exactitude binaires sans annotations d'erreur détaillées. Ce phénomène souligne le besoin urgent de cadres d'évaluation plus complets pour examiner plus en profondeur les mécanismes d'inférence des modèles de langage complexes.

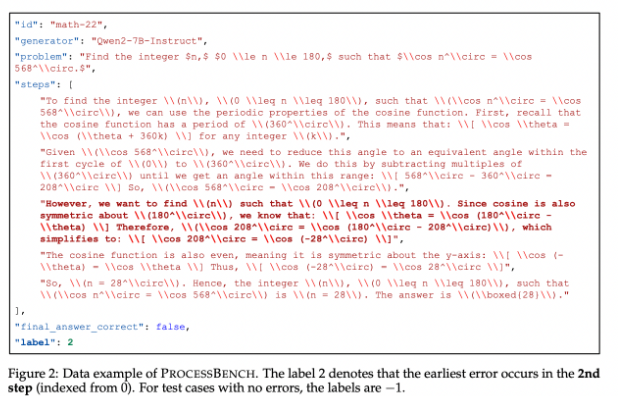

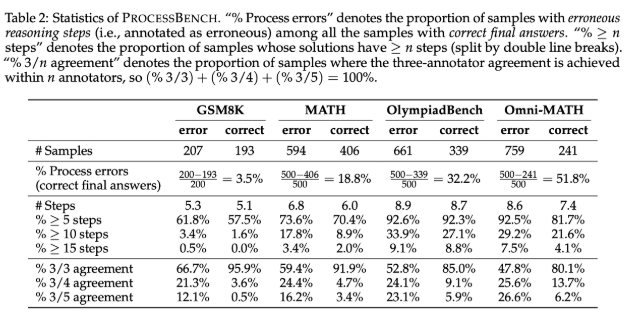

Pour combler cette lacune, les chercheurs ont conçu « PROCESSBENCH », un outil de référence axé sur l'identification des étapes défectueuses du raisonnement mathématique. Ses principes de conception incluent la difficulté des problèmes, la diversité des solutions et une évaluation complète. Le benchmark cible les problèmes mathématiques de niveau compétition et Olympiade, en exploitant plusieurs modèles de langage open source pour générer des solutions qui démontrent différentes approches pour résoudre les problèmes. PROCESSBENCH contient un total de 3 400 cas de test qui ont été soigneusement annotés par plusieurs experts humains pour garantir la qualité des données et la fiabilité de l'évaluation.

Au cours du développement, l'équipe de recherche a collecté des problèmes mathématiques à partir de quatre ensembles de données bien connus (GSM8K, MATH, OlympiadBench et Omni-MATH), garantissant ainsi qu'un large éventail de difficultés était couvert, de l'école primaire au niveau compétition. Ils ont exploité des modèles open source pour générer jusqu'à 12 solutions différentes afin d'augmenter la diversité des solutions. De plus, afin d’unifier le format des étapes de solution, l’équipe a adopté une méthode de reformatage pour garantir un raisonnement étape par étape logiquement complet.

Les résultats de la recherche montrent que les modèles de récompense de processus existants fonctionnent mal lorsqu'il s'agit de problèmes difficiles, en particulier sur des ensembles de problèmes plus simples, et que le modèle de jugement basé sur l'invite est plus performant. La recherche révèle les limites des modèles existants dans l’évaluation du raisonnement mathématique, en particulier lorsque le modèle parvient à la bonne réponse via de mauvaises étapes intermédiaires, ce qui rend difficile un jugement précis.

En tant que référence pionnière pour évaluer la capacité des modèles de langage à identifier les erreurs de raisonnement mathématique, PROCESSBENCH fournit un cadre important pour les recherches futures et favorise la compréhension et l'amélioration de l'IA dans le processus de raisonnement.

Entrée papier : https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Code : https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Dans l'ensemble, le lancement du benchmark PROCESSBENCH fournit un outil plus complet et plus approfondi pour évaluer la capacité de raisonnement mathématique des modèles de langage, contribuant ainsi à promouvoir le développement de la recherche dans ce domaine et, à terme, à améliorer les performances des modèles de langage dans des tâches de raisonnement complexes.