Avec l’explosion des contenus générés par l’intelligence artificielle, les plateformes de réseaux sociaux sont confrontées à un défi sans précédent : comment garantir que les utilisateurs peuvent distinguer les informations vraies des fausses informations ? Adam Mosseri, responsable d'Instagram, a récemment publié une série d'articles sur Threads exprimant ses inquiétudes concernant le contenu généré par l'IA et présentant les stratégies d'Instagram et de Meta pour relever ce défi. Il a souligné que les utilisateurs doivent être plus vigilants et apprendre à identifier le contenu généré par l'IA, et a appelé les plateformes à renforcer la supervision du contenu et à améliorer la transparence et la crédibilité de l'information.

Dans une récente série de publications sur Threads, Adam Mosseri, responsable d'Instagram, a souligné la nécessité pour les utilisateurs des médias sociaux d'être plus vigilants face aux quantités croissantes de contenu généré par l'IA.

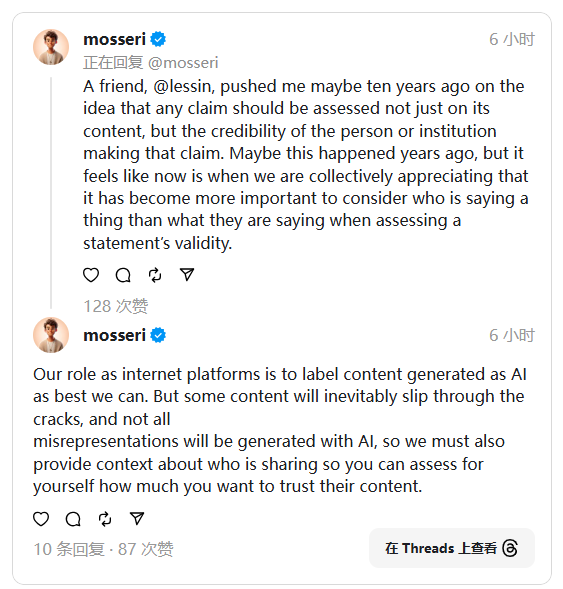

Il a souligné que les images et les informations que les utilisateurs voient en ligne pourraient ne pas être réelles, car la technologie de l’IA peut déjà générer un contenu très similaire à la réalité. Pour aider les utilisateurs à mieux juger de l'authenticité des informations, Mosseri a mentionné que les utilisateurs devraient prendre en compte la source du contenu, et que les plateformes sociales ont également la responsabilité de prendre en charge cela.

Mosseri a déclaré que le rôle des plateformes de médias sociaux est d'étiqueter autant que possible le contenu généré par l'IA pour aider les utilisateurs à l'identifier. Cependant, il a également admis que certains contenus pouvaient manquer et ne pouvaient pas être marqués à temps. À cette fin, il a souligné que les plateformes doivent également fournir aux utilisateurs des informations générales sur le contenu partagé afin que les utilisateurs puissent mieux décider dans quelle mesure ils peuvent faire confiance au contenu. Ses opinions reflètent de profondes inquiétudes quant à la crédibilité des messages sur les réseaux sociaux.

A ce stade, Meta (la société mère d'Instagram) n'a pas fourni suffisamment d'informations contextuelles pour aider les utilisateurs à juger de l'authenticité du contenu. Pourtant, la société a récemment laissé entendre qu'elle pourrait apporter des changements importants à ses règles en matière de contenu. Ce changement devrait accroître la confiance des utilisateurs dans l’information et les aider à mieux faire face aux défis posés par la technologie de l’IA.

Mosseri a mentionné que les utilisateurs doivent confirmer si les informations fournies par le chatbot sont fiables avant de faire confiance à un moteur de recherche piloté par l'IA. Cela revient à vérifier la source d’une déclaration ou d’une image publiée, seules les informations provenant de comptes réputés sont plus fiables.

L'approche de modération de contenu décrite par Mosseri est plus proche des systèmes de modération pilotés par l'utilisateur, tels que les notes de la communauté sur Twitter et les filtres de contenu de YouTube. Bien qu'il ne soit pas clair si Meta introduira des fonctionnalités similaires, étant donné l'expérience passée de l'entreprise en matière d'emprunt à d'autres plates-formes, les futures politiques de modération de contenu méritent d'être surveillées.

Dans l'ensemble, face aux défis posés par le contenu généré par l'IA, Instagram et Meta explorent activement des solutions, ce qui nécessite non seulement les efforts de la plateforme elle-même, mais oblige également les utilisateurs à améliorer leurs propres capacités de discernement et à maintenir conjointement le crédibilité et sécurité des informations en ligne. La manière dont le futur modèle de supervision du contenu évoluera mérite notre attention continue.