Ces dernières années, les grands modèles de langage (LLM) ont fait des progrès significatifs dans le domaine du traitement du langage naturel, mais leurs méthodes de traitement au niveau des jetons présentent des limites en termes de compréhension du contexte et d'applications multilingues et multimodales. Meta AI propose à cet effet une toute nouvelle méthode : les Large Concept Models (LCM), visant à résoudre les lacunes des LLM existants. En modélisant dans l'espace d'intégration de grande dimension SONAR, les LCM prennent en charge plusieurs langages et modalités et adoptent une architecture hiérarchique pour améliorer la cohérence et les capacités d'édition locale du contenu long, améliorant ainsi considérablement l'efficacité et les capacités de généralisation du modèle.

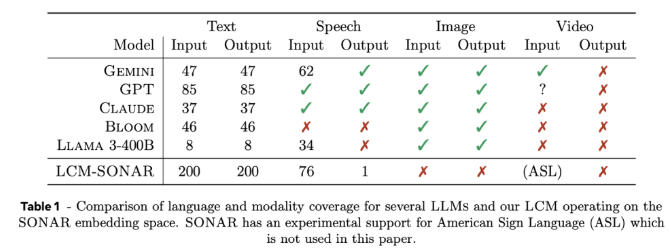

Les grands modèles conceptuels (LCM) représentent un changement important par rapport à l'architecture LLM traditionnelle. Ils introduisent deux innovations majeures : premièrement, les LCM modélisent dans un espace d'intégration de grande dimension plutôt que de s'appuyer sur des jetons discrets. Cet espace d'intégration, appelé SONAR, est conçu pour prendre en charge plus de 200 langues et plusieurs modalités, notamment le texte et la parole, offrant des capacités de traitement indépendantes de la langue et des modalités. Deuxièmement, la conception des LCM permet une transition transparente au niveau sémantique, permettant de fortes capacités de généralisation sans tir dans différents langages et modalités.

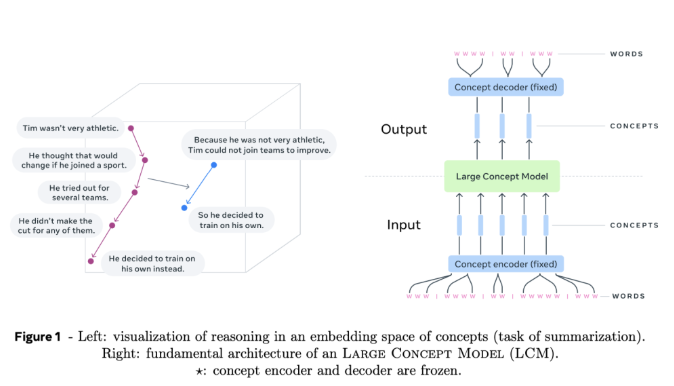

Au cœur des LCM se trouvent des encodeurs et des décodeurs de concepts, qui sont des composants qui mappent les phrases d'entrée à l'espace d'intégration de SONAR et décodent les intégrations en langage naturel ou en d'autres modalités. La conception figée de ces composants garantit la modularité, ce qui facilite l'extension de nouveaux langages ou modalités sans recycler l'intégralité du modèle.

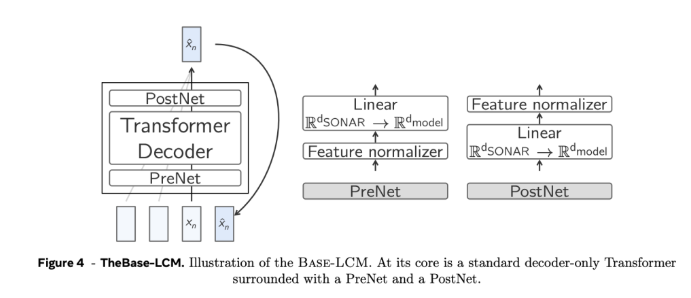

En termes de détails techniques, les LCM adoptent une architecture hiérarchique qui imite le processus de raisonnement humain, améliorant ainsi la cohérence du contenu long tout en permettant une édition locale sans perturber le contexte global. Les LCM excellent dans le processus de génération en utilisant des modèles de diffusion qui prédisent la prochaine intégration SONAR en fonction de l'intégration précédente. Dans l'expérience, deux architectures, à tour unique et à double tour, ont été utilisées. L'architecture à double tour traitait séparément le codage et le débruitage du contexte, ce qui améliorait l'efficacité.

Les résultats expérimentaux montrent que les LCM à deux tours basés sur la diffusion font preuve de compétitivité dans plusieurs tâches. Par exemple, dans la tâche de synthèse multilingue, les LCM surpassent les modèles de base dans le cas du tir zéro, démontrant leur adaptabilité. Dans le même temps, les LCM font également preuve d’une efficacité et d’une précision élevées lors du traitement de séquences plus courtes, ce qui est confirmé par l’amélioration significative des métriques associées.

Le grand modèle conceptuel de Meta AI offre une alternative prometteuse aux modèles de langage traditionnels au niveau des jetons, résolvant certaines des principales limitations des méthodes existantes grâce à l'intégration de concepts de grande dimension et à un traitement indépendant des modalités. À mesure que la recherche sur cette architecture s'approfondit, les LCM devraient redéfinir les capacités des modèles de langage et fournir une approche plus évolutive et adaptable de la communication basée sur l'IA.

Entrée du projet : https://github.com/facebookresearch/large_concept_model

Dans l'ensemble, le modèle LCM proposé par Meta AI fournit une solution innovante pour résoudre les limites du LLM traditionnel. Ses avantages en matière de traitement multilingue et multimodal et de conception d'architecture efficace lui confèrent un grand avenir dans le domaine du langage naturel. transformation. Il a un énorme potentiel et mérite une attention continue et des recherches approfondies.