Google a officiellement lancé le TPU de sixième génération, Trillium, et l'a ouvert aux clients Google Cloud. Trillium est le TPU le plus puissant de Google à ce jour et est utilisé pour entraîner Gemini 2.0, son modèle d'IA le plus puissant. Il améliore considérablement les performances de formation, le débit d'inférence et l'efficacité énergétique, tout en réduisant les coûts. Cet article examinera en profondeur les améliorations de performances, les fonctionnalités clés et les performances exceptionnelles de Trillium TPU dans différentes charges de travail d'IA, et démontrera ses cas d'application pratiques auprès de clients tels que AI21Labs.

Plus tôt cette année, Google a lancé Trillium, son TPU de sixième génération et le plus puissant à ce jour. Aujourd'hui, Trillium est officiellement disponible pour les clients Google Cloud.

Google a utilisé Trillium TPU pour former le dernier Gemini2.0, qui est le modèle d'IA le plus puissant de Google à ce jour. Désormais, les entreprises et les startups peuvent accéder à la même infrastructure robuste, efficace et durable.

Le cœur du supercalculateur IA : Trillium TPU

Trillium TPU est un composant clé de l'hyperordinateur Google Cloud AI. AI Hypercomputer est une architecture de supercalculateur révolutionnaire qui exploite un matériel aux performances optimisées, des logiciels ouverts, des cadres de ML de pointe et des systèmes d'intégration de modèles de consommation flexibles. Avec le lancement officiel de Trillium TPU, Google a également apporté des améliorations clés à la couche logicielle ouverte de l'hyperordinateur IA, notamment en optimisant le compilateur XLA et les frameworks populaires tels que JAX, PyTorch et TensorFlow pour atteindre un rapport prix/performance inégalé dans la formation en IA. , tuning et services .

De plus, des fonctionnalités telles que le déchargement de l'hôte à l'aide d'une DRAM hôte massive (mémoire supplémentaire à large bande passante, ou HBM) offrent des niveaux d'efficacité plus élevés. AI Hypercomputer vous permet d'extraire la valeur maximale d'un déploiement sans précédent de plus de 100 000 puces Trillium par architecture réseau Jupiter avec 13 pétabits/seconde de bande passante bidirectionnelle et la possibilité d'adapter une seule tâche de formation distribuée à des centaines de milliers d'accélérateurs.

Des clients comme AI21Labs utilisent déjà Trillium pour fournir plus rapidement des solutions d'IA significatives à leurs clients :

Barak Lenz, CTO d'AI21Labs, a déclaré : « Chez AI21, nous travaillons constamment à améliorer les performances et l'efficacité des modèles de langage Mamba et Jamba. En tant qu'utilisateurs de longue date de TPU v4, nous sommes impressionnés par les capacités de Trillium de Google Cloud. À l'échelle, à la vitesse et au coût. Les améliorations en termes d'efficacité sont significatives. Nous pensons que Trillium jouera un rôle essentiel dans l'accélération du développement de notre prochaine génération de modèles de langage complexes, nous permettant de proposer des solutions d'IA plus puissantes et plus accessibles à nos clients.

Les performances de Trillium ont été grandement améliorées et de nombreux indicateurs ont établi de nouveaux records.

Par rapport à la génération précédente, Trillium a apporté des améliorations significatives dans :

Performances d'entraînement améliorées de plus de 4 fois

Amélioration par 3 du débit d'inférence

L'efficacité énergétique a augmenté de 67%

Amélioration de 4,7 fois des performances informatiques maximales par puce

La mémoire à large bande passante (HBM) double la capacité

L'interconnexion inter-puces (ICI) double la bande passante

Une seule architecture réseau Jupiter contient 100 000 puces Trillium

Amélioration de 2,5 fois des performances de formation par dollar et amélioration de 1,4 fois des performances d'inférence par dollar

Ces améliorations permettent à Trillium de bien fonctionner sur une variété de charges de travail d'IA, notamment :

Faire évoluer les charges de travail de formation en IA

Former des LLM, y compris des modèles denses et des modèles Mixed Expert (MoE)

Performance d'inférence et planification collective

Intégration de modèles denses

Fournir une formation et une inférence rentables

Comment Trillium fonctionne-t-il sur différentes charges de travail ?

Faire évoluer les charges de travail de formation en IA

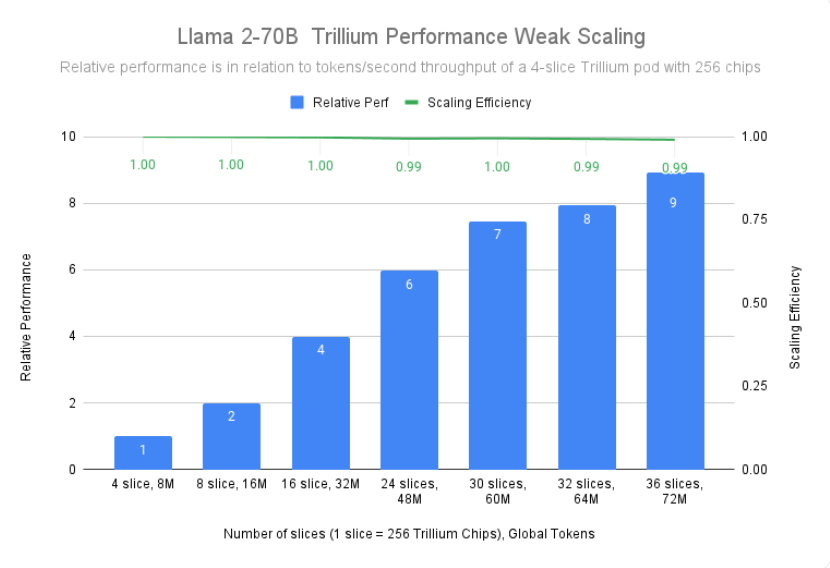

La formation d'un grand modèle comme Gemini2.0 nécessite beaucoup de données et de calculs. L'évolutivité quasi linéaire de Trillium permet à ces modèles d'être formés beaucoup plus rapidement en répartissant efficacement les charges de travail sur plusieurs hôtes Trillium, connectés via des interconnexions puce à puce à haut débit dans des modules de 256 puces et notre état de l'art en matière de le réseau de centres de données Jupiter. Ceci est réalisé grâce à la technologie TPU multi-puces et full-stack pour la formation à grande échelle, et est encore optimisé grâce à Titanium, un système de déchargement dynamique au niveau du centre de données qui va des adaptateurs hôtes à l'architecture réseau.

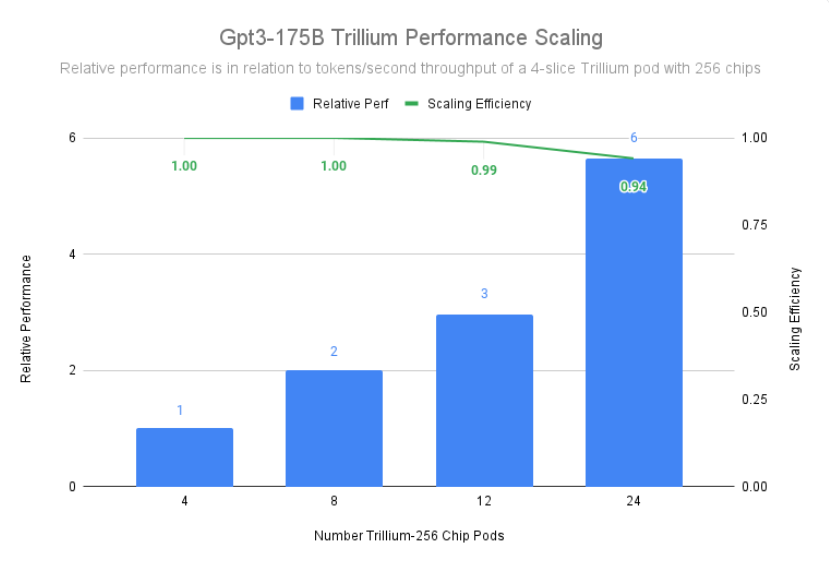

Trillium a atteint une efficacité de mise à l'échelle de 99 % dans un déploiement de 12 pods avec 3 072 puces et a démontré une efficacité de mise à l'échelle de 94 % dans 24 pods avec 6 144 puces pour pré-entraîner gpt3-175b, même en cas d'exécution sur des réseaux de centres de données.

Former des LLM, y compris des modèles denses et des modèles Mixed Expert (MoE)

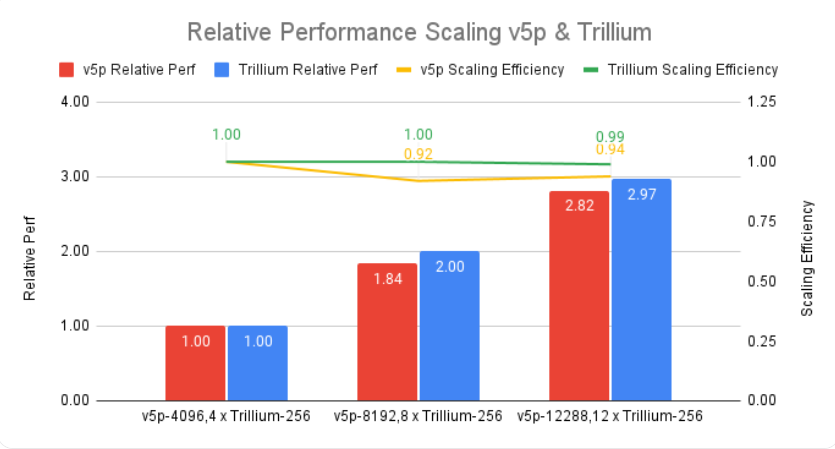

Les LLM comme Gemini sont intrinsèquement puissants et complexes, avec des milliards de paramètres. Former un LLM aussi intensif nécessite une énorme puissance de calcul ainsi qu'une optimisation logicielle co-conçue. Trillium est 4 fois plus rapide que la génération précédente de Cloud TPU v5e lors de l'entraînement de LLM intensifs tels que Llama-2-70b et gpt3-175b.

En plus du LLM intensif, une approche de plus en plus populaire consiste à former le LLM à l'aide d'une architecture experte mixte (MoE), qui combine plusieurs réseaux de neurones « experts », chacun spécialisé dans différents aspects de la tâche d'IA. La gestion et la coordination de ces experts pendant la formation ajoutent de la complexité par rapport à la formation d'un modèle monolithique unique. Trillium est 3,8 fois plus rapide que la génération précédente de Cloud TPU v5e lors de la formation des modèles MoE.

De plus, Trillium TPU fournit 3 fois plus de mémoire vive dynamique (DRAM) hôte que Cloud TPU v5e. Cela décharge une partie des calculs sur l'hôte, contribuant ainsi à maximiser les performances à grande échelle et un bon débit. La fonction de déchargement d'hôte de Trillium offre une amélioration des performances de plus de 50 % dans l'utilisation du modèle FLOP (MFU) lors de la formation du modèle Llama-3.1-405B.

Performance d'inférence et planification collective

L’importance croissante de l’inférence en plusieurs étapes nécessite des accélérateurs capables de gérer efficacement les demandes informatiques croissantes. Trillium apporte des avancées significatives pour les charges de travail d'inférence, permettant un déploiement plus rapide et plus efficace des modèles d'IA. En fait, Trillium offre nos meilleures performances d'inférence TPU pour la diffusion d'images et le LLM dense. Nos tests montrent que Stable Diffusion XL a un débit d'inférence relatif (images par seconde) plus de 3 fois supérieur à celui de Cloud TPU v5e, tandis que Llama2-70B en a près de 2 fois.

Trillium est notre TPU le plus performant pour les cas d'utilisation d'inférence hors ligne et sur serveur. La figure ci-dessous montre que par rapport à Cloud TPU v5e, le débit relatif (images par seconde) de Stable Diffusion XL pour l'inférence hors ligne est 3,1 fois plus élevé, et son débit relatif pour l'inférence du serveur est 2,9 fois plus élevé.

En plus de meilleures performances, Trillium introduit également de nouvelles capacités de planification collective. Cette fonctionnalité permet au système de planification de Google de prendre des décisions intelligentes en matière de planification des tâches afin d'améliorer la disponibilité globale et l'efficacité des charges de travail d'inférence lorsque plusieurs réplicas existent dans la collection. Il permet de gérer plusieurs tranches TPU exécutant des charges de travail d'inférence sur un ou plusieurs hôtes, notamment via Google Kubernetes Engine (GKE). Le regroupement de ces pièces dans une collection permet d'ajuster facilement le nombre de répliques en fonction de la demande.

Intégration de modèles denses

En ajoutant SparseCore de troisième génération, Trillium améliore de 2x les performances des modèles à forte intégration et du DLRM DCNv2 de 5x.

SparseCore est un processeur de flux de données qui fournit une base architecturale plus adaptable pour les charges de travail intégrées intensives. SparseCore de troisième génération de Trillium excelle dans l'accélération des opérations dynamiques et liées aux données telles que la collecte de dispersion, les sommes de segments clairsemées et le partitionnement.

Fournir une formation et une inférence rentables

En plus des performances et de l'évolutivité nécessaires pour former certaines des charges de travail d'IA les plus importantes au monde, Trillium est conçu pour optimiser les performances par dollar. À ce jour, Trillium a atteint des performances par dollar 2,1 fois supérieures à celles de Cloud TPU v5e et 2,5 fois supérieures à celles de Cloud TPU v5p lors de la formation de LLM intensifs tels que Llama2-70b et Llama3.1-405b.

Trillium excelle dans le traitement parallèle et rentable de grands modèles. Il est conçu pour permettre aux chercheurs et aux développeurs de fournir des modèles d’images puissants et efficaces à un coût bien inférieur à celui d’avant. Le coût de génération d'un millier d'images sur Trillium est 27 % inférieur à celui de Cloud TPU v5e pour l'inférence hors ligne et 22 % inférieur à celui de Cloud TPU v5e pour l'inférence de serveur sur SDXL.

Faire passer l’innovation en IA au niveau supérieur

Trillium représente une avancée majeure dans l'infrastructure d'IA de Google Cloud, offrant des performances, une évolutivité et une efficacité incroyables pour une variété de charges de travail d'IA. Grâce à sa capacité à s'adapter à des centaines de milliers de puces à l'aide d'un logiciel de co-conception de classe mondiale, Trillium vous permet de réaliser des percées plus rapides et de fournir des solutions d'IA de qualité supérieure. De plus, le rapport prix/performance exceptionnel de Trillium en fait un choix rentable pour les organisations cherchant à maximiser la valeur de leurs investissements en IA. Alors que le paysage de l'IA continue d'évoluer, Trillium démontre l'engagement de Google Cloud à fournir une infrastructure de pointe pour aider les entreprises à libérer tout le potentiel de l'IA.

Introduction officielle : https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

Dans l'ensemble, l'émergence de Trillium TPU marque une amélioration significative des capacités de calcul de l'IA dans le cloud. Ses puissantes performances, son évolutivité et ses avantages économiques favoriseront un développement plus rapide dans le domaine de l'IA et fourniront des solutions d'IA plus puissantes aux entreprises et aux instituts de recherche.