La dernière série de modèles Tülu3 publiée par l'Allen Institute for Artificial Intelligence (AI2) a apporté des avancées impressionnantes dans le domaine des modèles de langage open source. Non seulement Tülu3 est comparable en termes de performances aux modèles fermés tels que GPT-4o-mini, mais plus important encore, il est entièrement open source et fournit des données de formation complètes, du code, des recettes de formation et des cadres d'évaluation, ce qui est essentiel pour promouvoir l'open source. modèles sources. Le développement de la technologie de formation revêt une importance capitale. Il résout de nombreux problèmes existant dans l'application pratique des modèles de pré-formation traditionnels, tels que la génération d'informations nuisibles et la difficulté à suivre des instructions, etc., et ouvre de nouvelles possibilités de recherche et d'application dans le domaine de l'intelligence artificielle.

Dans le domaine de l'intelligence artificielle, la technologie post-formation devient progressivement un moyen important d'améliorer les performances des modèles. Récemment, l'Allen Institute for Artificial Intelligence (AI2) a publié la série de modèles Tülu3, qui est un modèle de langage avancé entièrement open source avec des performances comparables aux modèles fermés tels que GPT-4o-mini. Tülu3 contient non seulement des données de modèle, du code et des recettes de formation, mais fournit également un cadre d'évaluation visant à promouvoir le développement de technologies post-formation de modèles open source.

Traditionnellement, les modèles pré-entraînés seuls sont souvent inefficaces pour répondre aux besoins des applications pratiques, peuvent produire des informations toxiques ou dangereuses et sont difficiles à suivre les instructions humaines. Par conséquent, les étapes post-formation telles que la mise au point de l’instruction et l’apprentissage par feedback humain sont particulièrement importantes. Cependant, comment optimiser le processus post-formation reste un problème technique, en particulier lorsque l'amélioration d'une capacité du modèle peut affecter d'autres capacités.

Afin de surmonter ce problème, les grandes entreprises ont accru la complexité des méthodes post-formation, en essayant plusieurs cycles de formation et en combinant des données artificielles et synthétiques, mais la plupart des méthodes restent fermées. En revanche, la sortie de la série Tülu3 a comblé l'écart de performances entre les modèles open source et les modèles fermés et a apporté de nouvelles idées de formation.

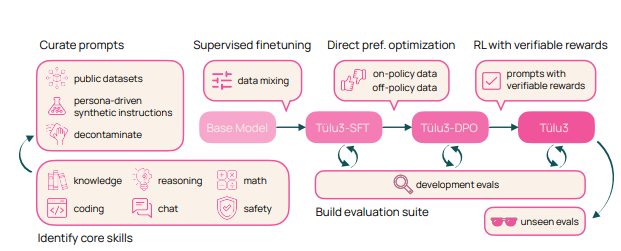

Le processus de formation de Tülu3 est divisé en quatre étapes : construction des données, réglage fin supervisé, ajustement des préférences et apprentissage par renforcement avec des récompenses vérifiables.

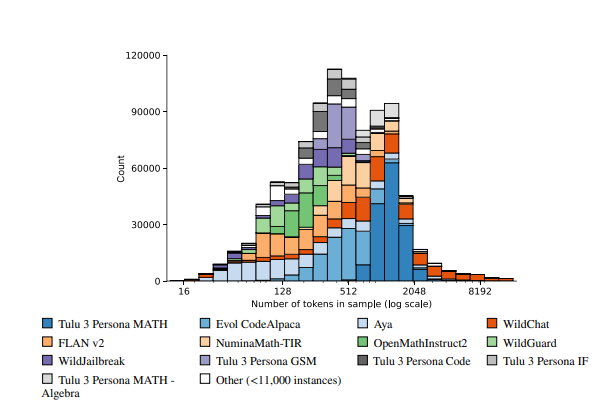

Premièrement, les chercheurs se concentrent sur les compétences de base du modèle et construisent des données de formation en combinant des données artificielles avec des données synthétiques.

Deuxièmement, un réglage fin supervisé est effectué pour garantir que le modèle fonctionne aussi bien que d'autres modèles de pointe sur des compétences spécifiques.

Troisièmement, la méthode d’optimisation des préférences directes est utilisée pour améliorer encore les performances globales du modèle. Enfin, la méthode innovante d'apprentissage par renforcement des récompenses vérifiables est introduite pour aider le modèle à mieux accomplir les tâches avec des résultats vérifiables.

Le modèle Tülu3 est construit sur la base de Llama3.1 et présente d'excellentes performances dans des domaines tels que le raisonnement, les mathématiques, la programmation et le suivi des instructions. Par rapport à d'autres modèles open source et fermés, les capacités complètes de Tülu3 fonctionnent bien dans plusieurs benchmarks, marquant une avancée majeure dans la technologie de formation post-open source.

Lien vers l'article : https://allenai.org/papers/tulu-3-report.pdf

Démo :https://playground.allenai.org/

Points forts:

? Tülu3 est un modèle de langage open source lancé par AI2, qui offre des performances comparables aux modèles fermés tels que GPT-4o-mini.

? La technologie post-formation est cruciale et peut améliorer efficacement les performances du modèle dans les applications pratiques.

? Le processus de formation innovant de Tülu3 est divisé en quatre étapes : construction de données, réglage fin supervisé, ajustement des préférences et apprentissage par renforcement des récompenses vérifiables.

La nature open source de Tülu3 permet aux chercheurs d'étudier en profondeur ses méthodes de formation et d'apporter des améliorations et des innovations sur cette base, ce qui favorisera grandement le développement de modèles de langage open source. Ses excellentes performances dans de nombreux domaines indiquent également que le modèle open source jouera un rôle plus important à l'avenir. On s'attend à ce que Tülu3 puisse promouvoir davantage la vulgarisation et l'application de la technologie de l'intelligence artificielle.