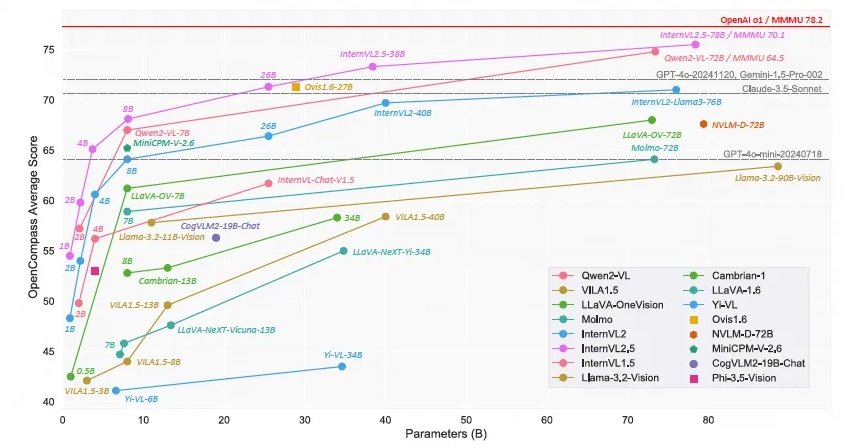

Le Shanghai AI Laboratory a lancé le modèle de langage multimodal open source à grande échelle - Scholar·Wanxiang InternVL2.5. Ses performances ont atteint une précision de plus de 70 % sur le benchmark de compréhension multimodale (MMMU), comparable à celui de Shanghai AI Laboratory. Les modèles GPT-4o et Claude-Commercial tels que le 3.5-Sonnet ont des performances comparables. Le modèle InternVL2.5 utilise la technologie de raisonnement en chaîne pour démontrer de solides performances dans plusieurs tests de référence, en particulier en matière de raisonnement multidisciplinaire, de compréhension de documents et de détection d'hallucinations multimodales. La nature open source de ce modèle favorisera grandement le développement et l’innovation de la technologie d’IA multimodale.

Récemment, le Shanghai AI Laboratory a annoncé le lancement du modèle Scholar·Wanxiang InternVL2.5. Grâce à ses performances exceptionnelles, ce modèle de langage multimodal open source à grande échelle est devenu le premier modèle open source à dépasser 70 % de précision sur le Multi-modal Understanding Benchmark (MMMU), en concurrence avec des modèles commerciaux tels que GPT-4o et Claude. -3.5-Sonnet Performances comparables.

Le modèle InternVL2.5 a obtenu une amélioration de 3,7 points de pourcentage grâce à la technologie de raisonnement Chain of Thinking (CoT), démontrant un fort potentiel d'évolutivité du temps de test. Le modèle est développé davantage sur la base d'InternVL2.0, améliorant encore les performances en améliorant les stratégies de formation et de test et en améliorant la qualité des données. Des recherches approfondies sont menées sur les encodeurs visuels, les modèles de langage, la taille des ensembles de données et les configurations de temps de test pour explorer la relation entre la taille du modèle et les performances.

InternVL2.5 démontre des performances compétitives dans plusieurs benchmarks, en particulier dans le raisonnement multidisciplinaire, la compréhension de documents, la compréhension multi-images/vidéos, la compréhension du monde réel, la détection d'hallucinations multimodales, l'ancrage visuel, les capacités multilingues et le traitement du langage pur. et d'autres domaines. Cette réalisation fournit non seulement à la communauté open source une nouvelle norme pour le développement et l'application de systèmes d'IA multimodaux, mais ouvre également de nouvelles possibilités de recherche et d'applications dans le domaine de l'intelligence artificielle.

InternVL2.5 conserve la même architecture de modèle que ses prédécesseurs InternVL1.5 et InternVL2.0, suit le paradigme "ViT-MLP-LLM" et implémente l'intégration du nouveau InternViT-6B ou InternViT-300M pré-entraîné incrémentiel avec divers Des LLM pré-entraînés de différentes tailles et types sont intégrés ensemble à l'aide de projecteurs MLP à deux couches initialisés de manière aléatoire. Pour améliorer l'évolutivité du traitement haute résolution, l'équipe de recherche a appliqué une opération de mélange de pixels pour réduire le nombre de jetons visuels à la moitié du nombre d'origine.

La nature open source du modèle signifie que les chercheurs et les développeurs peuvent accéder et utiliser librement InternVL2.5, ce qui favorisera grandement le développement et l'innovation de la technologie d'IA multimodale.

Lien du modèle :

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

La version open source d'InternVL2.5 fournit des ressources précieuses pour la recherche sur l'IA multimodale. Ses excellentes performances et son évolutivité devraient favoriser de nouvelles percées dans ce domaine et favoriser la naissance d'applications plus innovantes. Dans l'attente de voir des résultats plus surprenants basés sur InternVL2.5 à l'avenir.