Le dernier modèle de langage visuel ouvert de NVIDIA, NVILA, a réalisé des avancées significatives en termes de précision et d'efficacité, devenant ainsi une nouvelle étape dans le domaine de l'IA visuelle. Par rapport à d'autres modèles de vision à grande échelle, NVILA a obtenu des réductions significatives des coûts de formation, de l'utilisation de la mémoire et de la latence. Il a également démontré d'excellentes performances lors de plusieurs tests de référence, surpassant même certains concurrents. L'article présente en détail les détails techniques de NVILA, y compris la technologie « expansion d'abord et compression ultérieure » ainsi que l'expansion dynamique S2, l'élagage des ensembles de données basé sur DeltaLoss et d'autres stratégies d'optimisation, visant à équilibrer la précision et l'efficacité du modèle. Cela marque le développement de la technologie des modèles de langage visuel dans une direction plus économique et plus efficace.

Récemment, NVIDIA a lancé une nouvelle génération de modèle de langage visuel ouvert : NVILA. Conçu pour optimiser la précision et l’efficacité, il est devenu un leader dans le domaine de l’IA visuelle grâce à ses performances exceptionnelles.

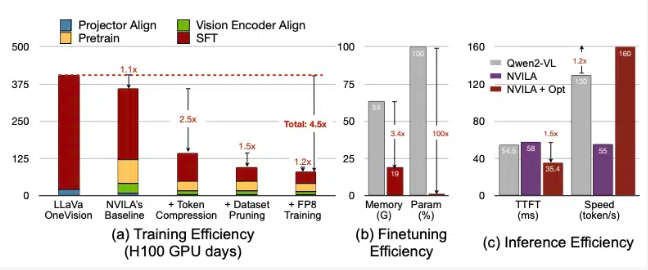

Selon NVIDIA, NVILA réduit les coûts de formation de 4,5 fois, réduit la mémoire requise pour le réglage fin de 3,4 fois et réduit les latences de pré-remplissage et de décodage de près de 2 fois. Ces données sont comparées à un autre grand modèle de vision, LLaVa OneVision.

Dans les benchmarks vidéo, NVILA a surpassé GPT4o Mini et a également obtenu de bons résultats en comparaison avec GPT4o, Sonnet3.5 et Gemini1.5Pro. De plus, NVILA a également remporté une légère victoire par rapport à Llama3.2. Malgré cela, NVIDIA a déclaré que le modèle n'avait pas encore été publié sur la plate-forme Hugging Face et a promis de publier prochainement le code et le modèle pour promouvoir la reproductibilité du modèle.

NVIDIA a souligné que le coût de formation des modèles de langage visuel est très élevé. Il faut environ 400 jours GPU pour former un modèle de langage visuel à 7 paramètres B. Dans le même temps, le réglage fin d'un tel modèle est également très gourmand en mémoire, avec un modèle à paramètres 7B nécessitant plus de 64 Go de mémoire GPU.

Par conséquent, NVIDIA utilise une technique appelée « étendre puis compresser » pour équilibrer la précision et l’efficacité du modèle. Au lieu de réduire la taille des photos et des vidéos, le modèle utilise plusieurs images d'images et de vidéos haute résolution pour garantir qu'aucun détail n'est perdu.

Pendant le processus de compression, le modèle réduit la taille des données d'entrée en compressant les informations visuelles en moins de jetons et en regroupant les pixels pour conserver les informations importantes. NVIDIA a mentionné dans le document que doubler la résolution doublerait le nombre de jetons visuels, ce qui augmenterait les coûts de formation et d'inférence de plus de 2 fois. Par conséquent, ils réduisent ce coût en compressant les jetons espace/temps.

NVIDIA a également présenté des démonstrations de certains modèles et NVILA peut répondre à plusieurs requêtes basées sur une image ou une vidéo. Ses résultats de sortie sont également comparés au modèle VILA1.5 précédemment publié par NVIDIA. En outre, NVIDIA a également présenté en détail d'autres technologies, telles que l'expansion dynamique S2, l'élagage des ensembles de données basé sur DeltaLoss, la quantification utilisant la précision FP8, etc.

Ces techniques sont appliquées à un modèle de paramètres 8B et les détails spécifiques peuvent être consultés sur Arxiv.

Entrée papier : https://arxiv.org/pdf/2412.04468

Souligner:

? Le modèle NVILA réduit les coûts de formation de 4,5 fois, améliorant ainsi l'efficacité de l'IA visuelle.

? Avec des images et des images vidéo haute résolution, NVILA garantit l'intégrité des informations d'entrée.

? NVIDIA promet de publier prochainement du code et des modèles pour favoriser la reproductibilité des recherches.

Dans l’ensemble, l’émergence de NVILA a apporté de nouvelles possibilités au développement de modèles de langage visuel. Son processus efficace de formation et d’inférence abaissera le seuil des applications d’IA visuelle et favorisera le développement ultérieur dans ce domaine. Nous attendons avec impatience la divulgation rapide du code et des modèles par NVIDIA afin que davantage de chercheurs puissent participer et promouvoir conjointement les progrès de la technologie de l'IA visuelle.