Le modèle linguistique Gemini-Exp-1206 de Google a obtenu des résultats remarquables dans le classement LMArena, attirant l'attention de l'industrie. Son score Arena de 1 379 a dépassé ChatGPT-4.0 et est devenu le nouveau leader. Cependant, ChatGPT-4.0 montre une plus grande acceptation et fiabilité des utilisateurs avec un nombre de votes plus élevé. Cet article fournira une analyse approfondie des avantages et des inconvénients de Gemini-Exp-1206, ainsi que du mécanisme d'évaluation de la plateforme LMArena, et discutera de son impact sur le développement du domaine de l'intelligence artificielle.

La dernière incursion de Google dans le domaine de l'IA générative a attiré une large attention. Après plusieurs mois de performances médiocres, Google Gemini s'est rapidement mis sur la voie rapide et a lancé un nouveau modèle de langage expérimental, Gemini-Exp-1206. Selon le dernier classement ChatArena, ce modèle se démarque parmi de nombreux concurrents et devient le leader de l'IA générative.

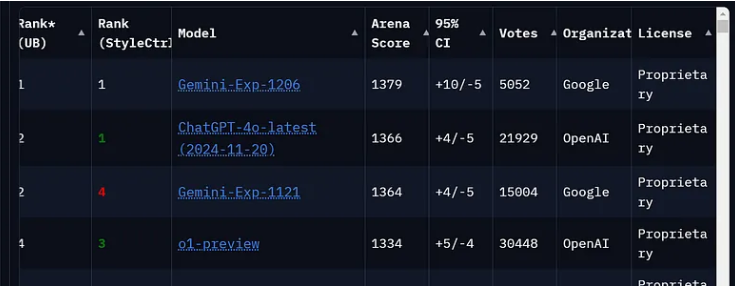

Gemini-Exp-1206 a obtenu le score d'arène le plus élevé sur LMArena, atteignant 1 379 points, légèrement supérieur aux 1 366 points de ChatGPT-4.0. Ce score montre que le Gemini-Exp-1206 a obtenu de bons résultats lors de plusieurs évaluations, démontrant ainsi ses excellentes capacités globales. De plus, le nouveau modèle affiche également des performances supérieures à celles du précédent Gemini-Exp-1114.

Alors, qu'est-ce que LMArena ? LMArena, également connue sous le nom de Chatbot Arena, est une plateforme open source permettant d'évaluer de grands modèles de langage. Développée conjointement par LMSYS et UC Berkeley SkyLab, cette plateforme est conçue pour soutenir l'évaluation par la communauté des performances LLM grâce à des tests en temps réel et à une comparaison directe.

Dans le classement, Arena Score représente la performance moyenne du modèle dans diverses tâches. Plus le score est élevé, plus la capacité est forte. Bien que le score de GeminiExp-1206 soit supérieur à celui de ChatGPT-4.0, en termes de nombre de votes, ChatGPT-4.0 est encore loin devant, avec un total de 21 929 votes, tandis que Gemini-Exp-1206 a reçu 5 052 votes. Un nombre de votes plus élevé signifie généralement une plus grande fiabilité, car cela indique que le modèle a été testé de manière plus approfondie.

De plus, les données d'intervalle de confiance à 95 % montrent que Gemini a un IC de ±10/-5, tandis que ChatGPT a un IC de ±4/-5. Cela montre que Gemini a un score moyen plus élevé, mais ChatGPT-4.0 est plus performant en termes de stabilité des performances.

Il convient de mentionner que les modèles expérimentaux Gemini sont des prototypes de pointe conçus pour les tests et les commentaires. Ces modèles offrent aux développeurs un accès anticipé aux dernières avancées de Google en matière d’IA tout en démontrant une innovation continue. Cependant, ces modèles expérimentaux sont temporaires et peuvent être remplacés à tout moment et ne conviennent pas à une utilisation dans des environnements de production.

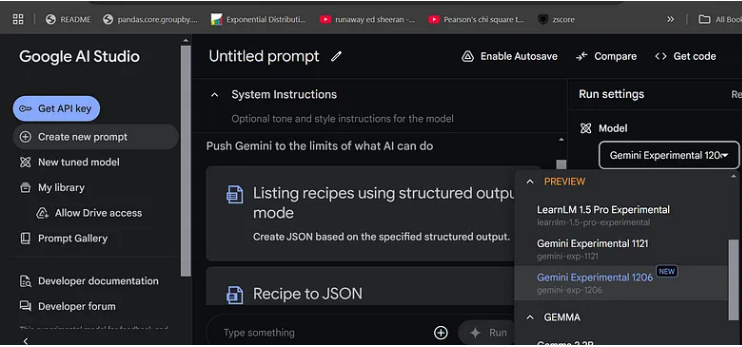

Si vous souhaitez utiliser Gemini-Exp-1206 gratuitement, accédez simplement à Google AI Studio, connectez-vous, sélectionnez l'invite de création et modifiez le modèle en Gemini Experimental1206 dans les paramètres pour commencer à discuter.

Bien que les résultats de Gemini-Exp-1206 soient assez spectaculaires, il convient de garder à l’esprit sa nature expérimentale. Il faudra du temps pour que le potentiel futur soit révélé, et l’industrie attend avec impatience la sortie régulière de ce concurrent de taille.

Entrée du projet : https://ai.google.dev/gemini-api/docs/models/experimental-models?hl=zh-cn

Points forts:

? Gemini-Exp-1206 a obtenu un score élevé de 1379 au classement LMArena, dépassant le score de 1366 de ChatGPT-4.0.

?️ ChatGPT-4.0 a reçu 21 929 votes, ce qui était nettement supérieur aux 5052 votes de Gemini-Exp-1206, démontrant sa fiabilité.

? Le modèle expérimental Gemini offre aux développeurs des opportunités sans précédent d'expérimenter l'IA, mais il est encore en phase de test et n'est pas adapté à une utilisation en production.

Dans l’ensemble, Gemini-Exp-1206 présente un fort potentiel, mais sa nature expérimentale et son faible nombre de votes nous rappellent également que nous devons encore être prudents dans les applications pratiques. À l'avenir, avec de nouvelles améliorations du modèle et des retours de tests d'un plus grand nombre d'utilisateurs, les modèles de la série Gemini devraient occuper une position plus importante dans le domaine de l'IA générative. Continuer à prêter attention à son développement aidera à mieux comprendre les tendances futures des grands modèles linguistiques.