Une nouvelle étude du Tow Center for Digital Journalism de l'Université Columbia révèle de sérieux problèmes avec la citation des sources d'information par ChatGPT. Les chercheurs ont testé 200 citations d'actualités provenant de 20 éditeurs et ont constaté que jusqu'à 76,5 % des citations de ChatGPT contenaient des erreurs ou des erreurs partielles, et reconnaissaient rarement des informations manquantes. Cette étude a soulevé des inquiétudes quant à la fiabilité des services de recherche par intelligence artificielle et a soulevé des questions sur la sécurité des applications de l'intelligence artificielle dans le domaine de la diffusion de l'information. Ses conclusions ont d'importantes implications d'avertissement pour les médias d'information et les sociétés d'intelligence artificielle.

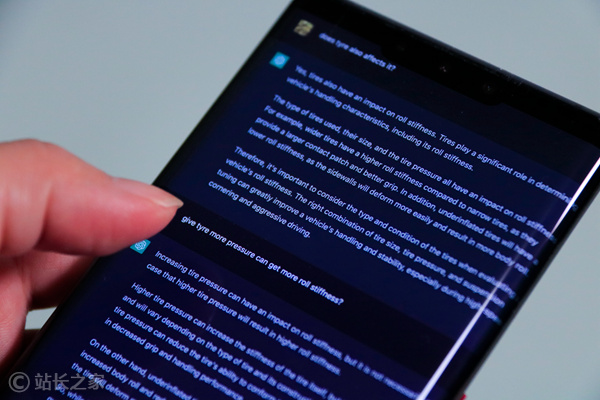

Une nouvelle recherche du Tow Center for Digital Journalism de l'Université Columbia tire la sonnette d'alarme pour les services de recherche d'intelligence artificielle. La recherche montre que ChatGPT rencontre de sérieux problèmes de précision lorsqu'il cite des sources d'information, même pour les éditeurs qui travaillent directement avec OpenAI. L'équipe de recherche a mené des tests complets sur 200 citations d'actualités provenant de 20 éditeurs différents, et les résultats ont été choquants : dans 153 de ces cas, ChatGPT avait des informations sources incorrectes ou partiellement incorrectes. Plus inquiétant encore, le système a rarement admis de manière proactive que des informations manquaient, admettant après seulement sept tentatives qu'il n'avait pas pu trouver la source.

Les chercheurs ont souligné que pour maintenir l’expérience utilisateur, ChatGPT préfère inventer des réponses plutôt que d’admettre un manque d’informations. Ce qui est plus grave, c'est que le système présente ces fausses sources avec une confiance inquiétante, ne montrant aucune incertitude. Même des éditeurs de renom comme le New York Post et The Atlantic, qui entretiennent des partenariats directs avec OpenAI, ne sont pas à l’abri de ce problème. Dans certains cas, ChatGPT établissait même des liens vers des sites Web qui copiaient des articles entiers sans autorisation, plutôt que la source originale.

Matt Honan, rédacteur en chef de la MIT Technology Review, a commenté à ce sujet : "En tant qu'éditeurs, ce n'est certainement pas une situation que nous souhaitons voir, et les recours disponibles à l'heure actuelle sont extrêmement limités."

OpenAI a été relativement prudent dans sa réponse à ces découvertes inquiétantes. La société a souligné que ChatGPT dessert 250 millions d'utilisateurs chaque semaine et a déclaré qu'elle travaillait avec des partenaires pour améliorer l'exactitude des citations.

La conclusion finale de l'étude est claire : à l'heure actuelle, les éditeurs n'ont aucune garantie que ChatGPT Search affichera avec précision leur contenu, qu'ils aient ou non un partenariat avec OpenAI. Cette découverte favorisera sans aucun doute de nouvelles discussions et une amélioration de la fiabilité des informations issues de l’intelligence artificielle.

Les résultats donnent à réfléchir et soulignent l’importance de la pensée critique et de la vérification des faits lorsque l’on s’appuie sur la technologie de l’intelligence artificielle pour obtenir des informations. À l’avenir, la surveillance et l’amélioration des modèles d’intelligence artificielle devront être encore renforcées afin de garantir que les informations qu’ils fournissent sont exactes et fiables et d’éviter d’induire le public en erreur.