Epoch AI a récemment publié un simulateur de puissance de calcul pour la formation de modèles de langage à grande échelle. Le simulateur fournit une référence précieuse aux chercheurs en simulant le coût et l'efficacité de la formation de GPT-4 dans différentes conditions matérielles. Les résultats de la simulation montrent que même l'utilisation d'une ancienne carte graphique GTX580 de 2012 peut entraîner GPT-4, mais le coût sera dix fois supérieur à celui du matériel moderne, ce qui souligne l'importance de l'amélioration des performances matérielles pour la formation des modèles d'IA. Le simulateur prend également en charge la simulation de formation multi-centres de données, permettant aux utilisateurs de personnaliser les paramètres et d'analyser les différences de performances des différents matériels et stratégies de formation, fournissant ainsi une base décisionnelle importante pour la formation des futurs modèles d'IA à grande échelle.

Récemment, la société de recherche en intelligence artificielle Epoch AI a publié un simulateur interactif spécialement conçu pour simuler la puissance de calcul requise pour former de grands modèles de langage. À l'aide de ce simulateur, les chercheurs ont découvert que s'il était possible d'entraîner GPT-4 en utilisant des cartes graphiques plus anciennes de 2012, comme une GTX580, le coût serait dix fois plus élevé que celui du matériel moderne d'aujourd'hui.

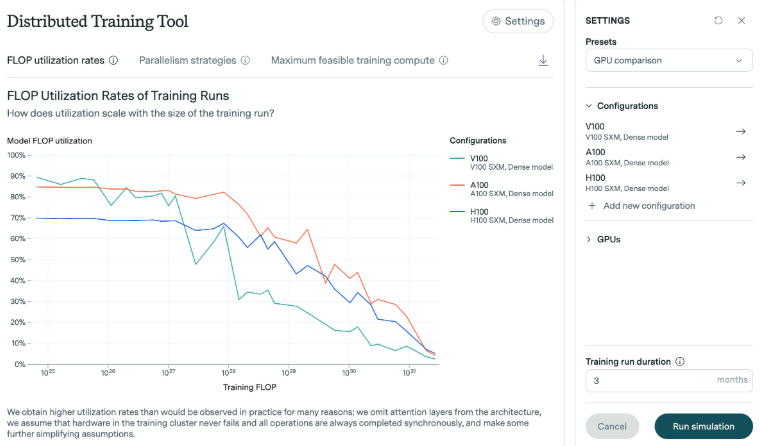

Les recherches d'Epoch AI montrent que le nombre d'opérations en virgule flottante (FLOP) nécessaires pour entraîner GPT-4 est compris entre 1e25 et 1e26. Pour cette étude, le simulateur a analysé l’efficacité de différentes cartes graphiques, notamment à mesure que le modèle évolue. Les résultats montrent qu’à mesure que le modèle se développe, l’efficacité diminue généralement. Prenons l'exemple de la carte graphique H100 lancée ces dernières années. Elle peut maintenir une efficacité élevée pendant une longue période, tandis que l'efficacité de la carte graphique V100 diminue de manière plus évidente face à des échelles d'entraînement plus importantes.

Dans les expériences d'Epoch AI, la mémoire de la carte graphique GTX580 n'était que de 3 Go. Cette carte graphique était le choix dominant lors de la formation du modèle AlexNet en 2012. Bien que la technologie ait progressé, les chercheurs estiment qu'une formation à si grande échelle est possible en utilisant du matériel plus ancien, mais les ressources et les coûts requis seraient prohibitifs.

De plus, le simulateur prend en charge des simulations de formation complexes dans plusieurs centres de données. Les utilisateurs peuvent personnaliser des paramètres tels que la taille du centre de données, la latence et la bande passante de connexion pour simuler des formations sur plusieurs sites. Cet outil permet également d'analyser les différences de performances entre les cartes graphiques modernes (telles que H100 et A100), d'étudier les effets des différentes tailles de lots et de la formation multi-GPU, et de générer des fichiers journaux détaillés documentant la sortie du modèle.

Epoch AI a déclaré avoir développé le simulateur pour approfondir sa compréhension des améliorations de l'efficacité du matériel et évaluer l'impact des contrôles à l'exportation de puces. Avec l’augmentation attendue des missions de formation à grande échelle au cours de ce siècle, il est particulièrement important de comprendre les exigences matérielles requises à l’avenir.

Dans l’ensemble, cette recherche et ce simulateur d’Epoch AI fournissent une valeur de référence importante pour la formation de grands modèles de langage, aidant les chercheurs à mieux comprendre l’efficacité du matériel, à optimiser les stratégies de formation et à fournir une formation plus fiable pour les futurs modèles d’IA.