Les grands modèles linguistiques (LLM) ont connu un grand succès dans le domaine du traitement du langage naturel, mais leur traitement basé sur des jetons limite leurs performances dans la compréhension de textes longs et dans les applications multilingues et multimodales. Le Large Concept Model (LCM) proposé par Meta AI fournit une toute nouvelle solution qui exploite des unités sémantiques abstraites - des concepts dans un espace d'intégration de grande dimension, surmontant ainsi les limites du LLM. L'innovation de LCM réside dans son approche de modélisation indépendante du langage et des modalités, ainsi que dans son architecture hiérarchique et son mécanisme de génération basé sur la diffusion. Cela permet à LCM de réaliser une modélisation de langage efficace et évolutive avec de fortes capacités de généralisation sans tir.

Les grands modèles de langage (LLM) ont fait des progrès significatifs dans le domaine du traitement du langage naturel (NLP), ce qui les rend populaires dans des applications telles que la génération de texte, le résumé et la réponse à des questions. Cependant, le recours de LLM au traitement au niveau des jetons (prédire un mot à la fois) pose également certains défis. Cette approche contraste avec la façon dont les humains communiquent, qui opère généralement à un niveau d’abstraction plus élevé, comme les phrases ou les idées.

La modélisation au niveau des jetons est également insuffisante pour les tâches qui nécessitent une compréhension du contexte à long terme et peuvent produire des résultats incohérents. De plus, l’extension de ces modèles à des applications multilingues et multimodales est coûteuse en termes de calcul et nécessite beaucoup de données. Pour résoudre ces problèmes, les chercheurs de Meta AI ont proposé une nouvelle méthode : le Large Conceptual Model (LCM).

Grands modèles conceptuels : un nouveau paradigme pour la compréhension sémantique

Le grand modèle conceptuel (LCM) de Meta AI représente un changement par rapport à l'architecture LLM traditionnelle. LCM introduit deux innovations majeures :

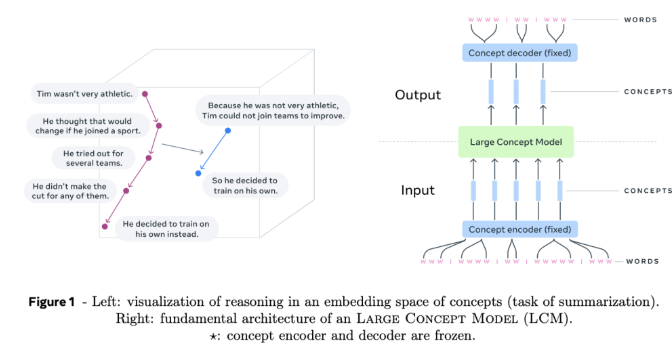

Modélisation de l'espace d'intégration de grande dimension : LCM ne fonctionne plus sur des jetons discrets, mais effectue des calculs dans un espace d'intégration de grande dimension. Cet espace représente des unités abstraites de sens, appelées concepts, correspondant à des phrases ou des énoncés. Cet espace d'intégration, appelé SONAR, est conçu pour être indépendant de la langue et des modalités, prenant en charge plus de 200 langues et plusieurs modalités, y compris le texte et la parole.

Modélisation indépendante du langage et des modalités : contrairement aux modèles liés à un langage ou une modalité spécifique, LCM traite et génère du contenu à un niveau purement sémantique. Cette conception permet une commutation transparente entre les langues et les modalités, ce qui entraîne une forte généralisation sans tir.

Au cœur de LCM se trouvent des encodeurs et décodeurs conceptuels qui mappent les phrases d'entrée à l'espace d'intégration de SONAR et décodent les intégrations en langage naturel ou d'autres modalités. Ces composants sont gelés, garantissant la modularité et une expansion facile vers de nouveaux langages ou modalités sans recycler l'intégralité du modèle.

Détails techniques et avantages du LCM

LCM introduit plusieurs innovations pour faire progresser la modélisation du langage :

Architecture en couches : LCM adopte une structure en couches qui reflète le processus de raisonnement humain. Cette conception améliore la cohérence du contenu long et permet une édition locale sans détruire le contexte plus large.

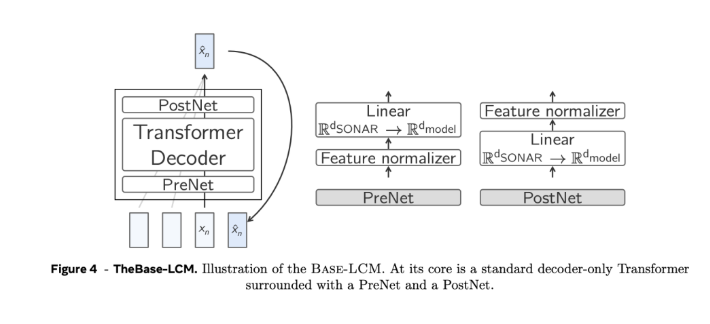

Génération basée sur la diffusion : le modèle de diffusion est considéré comme la conception la plus efficace de LCM. Ces modèles prédisent la prochaine intégration SONAR en fonction de l'intégration précédente. Deux architectures ont été explorées :

Tour unique : un seul décodeur Transformer gère l'encodage du contexte et le débruitage.

Twin Towers : codage et débruitage de contexte séparés, fournissant des composants dédiés à chaque tâche.

Évolutivité et efficacité : par rapport au traitement au niveau du jeton, la modélisation au niveau du concept réduit la longueur des séquences, résout la complexité quadratique des Transformers standard et peut gérer plus efficacement les contextes longs.

Généralisation sans tir : LCM présente de solides capacités de généralisation sans tir dans des langues et des modalités inédites en tirant parti de la prise en charge étendue multilingue et multimodalité de SONAR.

Critères de recherche et d'arrêt : Algorithme de recherche avec critères d'arrêt basés sur l'éloignement de la notion de « fin de document », garantissant une génération cohérente et complète sans nécessité de mise au point.

Dans l'ensemble, le grand modèle conceptuel (LCM) de Meta AI apporte de nouvelles idées dans le domaine du traitement du langage naturel. Ses avantages dans le traitement de textes longs, de données multilingues et multimodales indiquent une direction importante pour le développement futur des modèles de langage. . L'émergence du LCM améliorera considérablement les capacités de l'intelligence artificielle dans le traitement de l'information multilingue et multimodale, et étendra ses applications dans davantage de domaines.