Answer.AI et LightOn ont publié conjointement le modèle de langage open source ModernBERT, qui constitue une amélioration majeure par rapport à Google BERT et a considérablement amélioré la vitesse, l'efficacité et la qualité. ModernBERT traite quatre fois plus rapidement que BERT, utilise moins de mémoire et peut gérer du texte jusqu'à 8 192 jetons, soit 16 fois plus rapide que les modèles existants. Il a également réalisé des progrès révolutionnaires dans le codage du code de programmation pour la première fois, obtenant un score de plus de 80 sur l'ensemble de données StackOverflow Q&A, établissant ainsi un nouveau record. Plus important encore, ModernBERT réduit considérablement le coût du traitement de texte à grande échelle et peut fonctionner sur du matériel grand public ordinaire, ce qui le rend plus rentable que des modèles tels que GPT-4.

La conception de ModernBERT lui permet de gérer du texte d'une longueur maximale de 8 192 jetons, ce qui représente une amélioration de 16 fois par rapport à la limite typique de 512 jetons des modèles d'encodage existants. De plus, ModernBERT est le premier modèle d'encodage de code de programmation largement formé, atteignant un score de plus de 80 sur l'ensemble de données StackOverflow Q&A, établissant un nouveau record pour les modèles d'encodage.

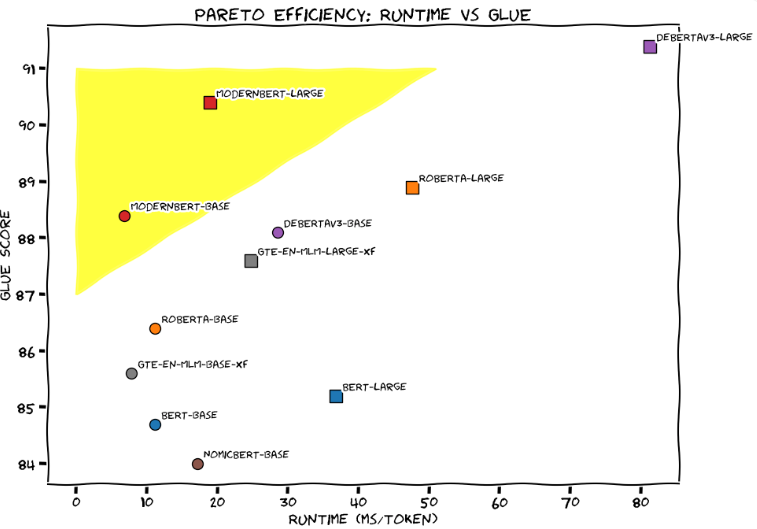

Dans l'évaluation GLUE (General Language Understanding), ModernBERT-Large a atteint le meilleur équilibre entre vitesse de traitement et précision, avec un temps de traitement d'environ 20 millisecondes par jeton et un score de 90. L'équipe de développement a clairement comparé ModernBERT à une Honda Civic optimisée, soulignant sa fiabilité et son efficacité dans les applications quotidiennes.

Par rapport aux modèles linguistiques à grande échelle existants tels que GPT-4, ModernBERT réduit considérablement le coût du traitement de texte à grande échelle. GPT-4 coûte quelques centimes par requête, tandis que ModernBERT s'exécute localement, est plus rapide et moins cher. Par exemple, lorsque le projet FineWeb Edu a filtré 15 milliards de balises, le coût d'utilisation du modèle BERT s'est élevé à 60 000 dollars, et même en utilisant le décodeur Gemini Flash de Google, le coût s'est élevé à plus d'un million de dollars.

L'équipe de développement affirme que ModernBERT est bien adapté à une variété d'applications pratiques, notamment les systèmes de génération augmentée par récupération (RAG), la recherche de code et la révision de contenu. Contrairement à GPT-4, qui nécessite un matériel spécialisé, ModernBERT peut fonctionner efficacement sur les GPU de jeux grand public ordinaires.

Actuellement, ModernBERT est disponible en deux versions : le modèle de base contient 139 millions de paramètres et la version large contient 395 millions de paramètres. Les deux versions sont désormais publiées sur Hugging Face et les utilisateurs peuvent directement remplacer les modèles BERT existants par elles. L’équipe de développement prévoit de lancer une version plus grande l’année prochaine, mais aucune fonctionnalité multimodale n’est prévue. Pour promouvoir le développement de nouvelles applications, ils lancent également un concours qui attribuera 100 $ et un abonnement professionnel de six mois à Hugging Face aux cinq meilleurs présentateurs.

Depuis que Google a lancé BERT en 2018, le modèle est l'un des modèles linguistiques les plus populaires, avec plus de 68 millions de téléchargements mensuels sur HuggingFace.

Entrée du projet : https://huggingface.co/blog/modernbert

Souligner:

ModernBERT est quatre fois plus rapide que BERT et peut gérer du texte jusqu'à 8 192 jetons.

Par rapport à GPT-4, le coût de ModernBERT en matière de traitement de texte à grande échelle est considérablement réduit et son fonctionnement est plus efficace.

Ce modèle est particulièrement efficace pour traiter le code de programmation, obtenant un score de plus de 80 sur l'ensemble de données StackOverflow Q&A, établissant ainsi un nouveau record.

En bref, la version open source de ModernBERT offre aux développeurs un choix de modèle de langage efficace, économique et puissant. Elle présente des avantages significatifs en termes de vitesse, d'efficacité et de capacité à traiter des textes longs, et devrait promouvoir le développement innovant d'un plus grand nombre d'applications d'IA. . Dans l’attente de futures mises à jour et d’applications plus larges.