OpenAI a publié une nouvelle génération de modèle d'inférence o3 et sa version simplifiée o3-mini, qui sont les successeurs de la série o1 et sont conçues pour améliorer la précision des réponses aux questions grâce à une réflexion plus approfondie. o3 a réalisé des progrès révolutionnaires dans le benchmark ARC-AGI, démontrant des capacités de résolution de problèmes proches du niveau humain. o3-mini se concentre sur la rapidité et la rentabilité et est particulièrement adapté aux tâches de programmation. Bien que les modèles de la série o3 ne soient pas directement rendus publics, OpenAI les a ouverts aux chercheurs en sécurité pour un aperçu.

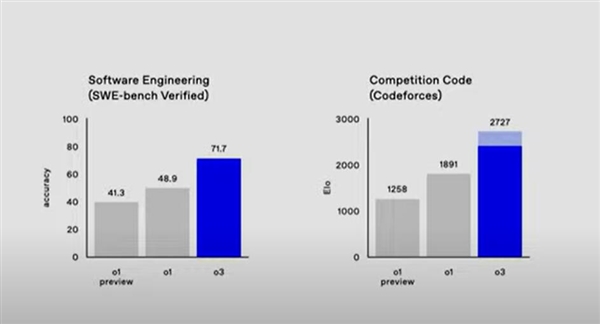

Le modèle o3 fonctionne bien dans plusieurs benchmarks. Par exemple, la précision du benchmark SWE-bench Verified est supérieure de plus de 20 % à celle de o1, et la précision des mathématiques de compétition et du GPQA Diamond est également considérablement améliorée. OpenAI a également introduit une nouvelle méthode d'évaluation de la sécurité appelée « alignement délibératif » pour garantir la sécurité du modèle et la conformité aux spécifications de sécurité. Actuellement, OpenAI subit des tests de sécurité externes et a ouvert des applications à accès anticipé.

En termes de programmation et de résolution de problèmes mathématiques, le modèle o3 a démontré des capacités remarquables. Sur le benchmark SWE-bench Verified, la précision de o3 est d'environ 71,7 %, soit plus de 20 % de plus que celle du modèle o1. Dans le Code de la compétition, o3 a reçu un score Elo de 2727, tandis que o1 n'en a reçu que 1891. De plus, la précision d'o3 en mathématiques de compétition a atteint 96,7 % et sa précision en GPQA Diamond a atteint 87,7 %, soit près de 10 % de plus que celle d'o1.

OpenAI a également introduit une nouvelle méthode d'évaluation de la sécurité : l'alignement délibératif, qui est un nouveau paradigme qui enseigne directement les spécifications de sécurité du modèle et peut entraîner le modèle à rappeler explicitement les spécifications et à effectuer un raisonnement précis avant de répondre. Cette approche est utilisée pour aligner les modèles de la série o d’OpenAI et assurer une conformité très précise avec les politiques de sécurité d’OpenAI.

Actuellement, OpenAI promeut les tests de sécurité externes et a ouvert des applications à accès anticipé sur le site Web. Les candidats doivent remplir un formulaire en ligne et fournir les informations pertinentes. Les chercheurs sélectionnés auront accès à o3 et o3-mini pour explorer leurs capacités et contribuer aux évaluations de sécurité.

La sortie des modèles de la série OpenAI o3 marque une amélioration significative des capacités de raisonnement de l'intelligence artificielle, et ses performances exceptionnelles dans plusieurs domaines annoncent une nouvelle direction pour le développement futur de la technologie de l'IA. À l'avenir, nous continuerons à prêter attention aux progrès et à l'application des modèles de la série o3.