Le Zhiyuan Research Institute et Tencent ont publié conjointement LongBench v2, une plateforme de test de référence pour évaluer les capacités de compréhension et de raisonnement de textes longs des grands modèles linguistiques (LLM). LongBench v2 améliore considérablement la longueur du texte et la difficulté de l'évaluation, y compris 503 questions difficiles à quatre choix et à choix multiples, ce qui rend difficile, même pour les experts humains, d'obtenir une grande précision en peu de temps. Le benchmark couvre six grandes catégories de tâches et comprend des améliorations de la méthodologie d'évaluation pour accroître la fiabilité et l'exactitude des résultats. Cette démarche vise à promouvoir les progrès des grands modèles de langage dans le traitement de textes longs et à fournir un outil d'évaluation plus efficace pour la recherche connexe.

Lors d'une conférence de presse le 19 décembre 2024, l'Institut de recherche Zhiyuan et Tencent ont annoncé le lancement de LongBench v2, conçu pour évaluer les capacités de compréhension et de raisonnement approfondies des grands modèles de langage (LLM) dans des tâches multitâches de texte long du monde réel. Conception de benchmarks. La plateforme vise à promouvoir les progrès des modèles de textes longs dans la compréhension et le raisonnement, et répond aux défis actuels liés à l'application de modèles de textes longs et de grands langages.

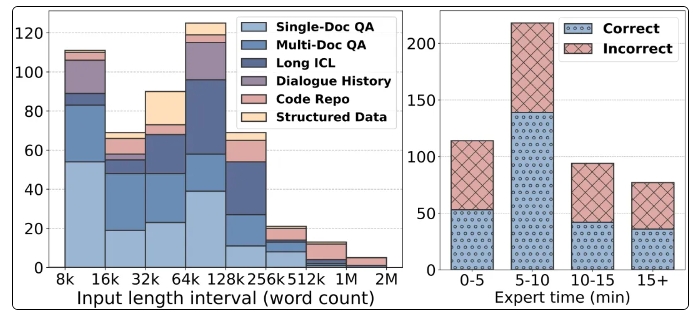

Les fonctionnalités notables de LongBench v2 incluent la prise en charge de textes plus longs, allant de 8 000 à 2 millions de mots, et contient 503 questions difficiles à choix multiples à quatre choix avec une difficulté plus élevée, même la précision moyenne des experts humains en 15 minutes. Le taux n'est que de 53,7 % . En outre, le benchmark couvre six catégories de tâches principales, notamment les questions-réponses sur un seul document, les questions-réponses sur plusieurs documents, l'apprentissage du contexte de texte long, etc., garantissant un large éventail de scénarios d'application.

Afin de garantir la fiabilité de l'évaluation, toutes les questions de LongBench v2 se présentent sous la forme de questions à choix multiples et sont soumises à un processus strict d'annotation et de révision manuelle. Au cours du processus de collecte de données, des annotateurs issus des meilleures universités ont été recrutés pour garantir la qualité et la difficulté des questions. En introduisant des variables de contrôle, LongBench v2 améliore l'algorithme statistique original de Bradley-Terry, réduisant l'impact des facteurs de confusion et rendant le classement des modèles plus scientifique et plus précis.

En termes de résultats d'évaluation, l'équipe de recherche a testé 10 LLM open source et 6 LLM open source et a constaté que les performances du modèle étaient considérablement améliorées après l'introduction de variables de contrôle. En particulier, le modèle GPT-4o fonctionne bien sur des tâches telles que la réponse à des questions multidocuments et l'apprentissage de contextes de textes longs après avoir introduit davantage d'étapes de raisonnement, montrant l'importance des capacités de raisonnement.

Le lancement de LongBench v2 fournit non seulement un nouvel outil pour l'évaluation de grands modèles de langage, mais indique également l'orientation des recherches futures, en soulignant l'importance d'améliorer la compréhension et les capacités de raisonnement du modèle. La coopération entre l'Institut de recherche Zhiyuan et Tencent marque un développement ultérieur dans le domaine de la technologie de l'IA. On s'attend à ce que ce test de référence puisse promouvoir l'avancement de la compréhension des textes longs et de la technologie de raisonnement.

Page d'accueil : https://longbench2.github.io

Article : https://arxiv.org/abs/2412.15204

Données et code : https://github.com/THUDM/LongBench

La sortie de LongBench v2 marque une nouvelle étape dans l'évaluation des grands modèles de langage. Ses normes d'évaluation plus strictes et son contenu de test plus complet contribueront à promouvoir l'amélioration continue des grands modèles de langage en termes de compréhension de textes longs et de capacités de raisonnement. Nous attendons avec impatience que d’autres résultats de recherche basés sur LongBench v2 apparaissent à l’avenir pour promouvoir davantage le développement de la technologie de l’IA.